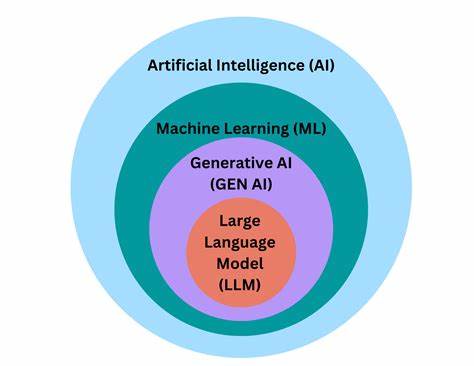

В последние годы большие языковые модели (LLM) стали объектом оживленных дискуссий в научных кругах, индустрии и широкой общественности. Однако наряду с восхищением и надеждами на их способности часто появляется тенденция приписывать этим системам человеческие качества: сознание, волю, этические устремления. Такой антропоморфный подход к пониманию языковых моделей порождает множество заблуждений и усложняет обсуждение реальных технических, этических и социальных вопросов, связанных с развертыванием искусственного интеллекта. Рассмотрим альтернативный взгляд, который опирается на принципиальное понимание LLM как сложных математических функций и исключает представления о них как о живых существах или мыслящих агентах. Большие языковые модели — это прежде всего системы, основанные на механизмах матричного умножения и нелинейных преобразованиях.

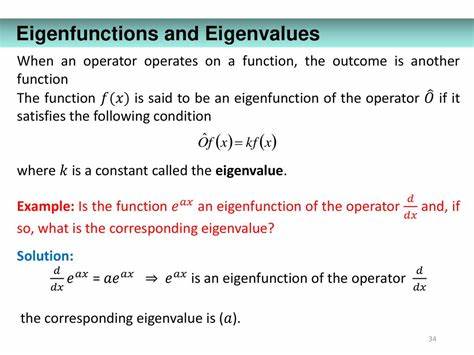

Они обрабатывают входные последовательности токенов, сопоставляя каждому из них вектор в многомерном пространстве. Таким образом весь текст можно представить как путь в этом пространстве, где каждое слово — это точка, а последовательность слов — траектория. Модель, обучаясь на большом массиве текстов, учится предсказывать следующий токен, основываясь на предыдущих, что математически сводится к отображению пространства R^n, где n — размерность векторного пространства для токенов, в последовательности длиной c. Такое рассмотрение позволяет представить процесс генерации текста как динамическую систему, где последовательность слов — сложный, возможно хаотичный, но структурированный путь, похожий на странные аттракторы в теории динамических систем. Модель работает с вероятностями того, какой токен может быть следующим, и случайно выбирает из распределения, обученного на текстах разных жанров и тем.

Обучение языковых моделей основывается на огромных корпусах человеческих текстов, включая произведения экспертов в различных областях и автоматически сгенерированные данные с верификацией качества. Целью такого обучения является создание функционала, который максимально точно отражает вероятностные связи между последовательностями слов в человеческом языке и способен генерировать связный и контекстно релевантный текст. Важным аспектом является то, что среди всех возможных последовательностей слов существуют «нежелательные» — те, которые по этическим, юридическим или социальным соображениям нежелательно генерировать. Однако строгого математического описания этих нежелательных путей нет, можно лишь предоставлять примеры и антиприимеры, чтобы стараться смещать вероятностное распределение так, чтобы минимизировать их появление. Сам процесс «выравнивания» (alignment) моделей сводится к попытке оценить и ограничить вероятность генерации таких нежелательных последовательностей, что пока представляет серьезную техническую задачу в силу сложности и размытости критериев «нежелательности».

Часто в публичных и научных дискуссиях наблюдается тенденция переносить на LLM понятия человеческого сознания, морали, ценностей и намерений. Однако такие приписывания не соответствуют сути технологической реализации. Большие языковые модели — это не мыслящие существа, не обладающие сознанием или субъектностью, а сложные математические функции, которые вычисляют вероятности появления следующего слова. Без активации (вводного текста) они просто не функционируют, подобно тому, как цифровая метеорологическая модель не «сознает» свой прогноз, а лишь по заданным алгоритмам выдает статистически обоснованные вычисления. Понимание LLM как инструментов генерации последовательностей, а не как интеллектов с внутренним миром, становится ключом к более ясному обсуждению вопросов безопасности и этичности ИИ.

Вместо разговоров о якобы возникающих у таких систем мотивах, злокозненных планах или желании вредить, правильнее рассматривать их как стохастические генераторы текста, чью работу можно анализировать с помощью вероятностных моделей и ограничения пространства допустимых выходных данных. Такой подход также помогает избавиться от страха перед «пробуждением» искусственного интеллекта, вызывающим массу спекуляций и мифов. В действительности, современные LLM — это вычислительные модели, которые, хотя и впечатляют своими способностями решать задачи, ранее считавшиеся неразрешимыми, таких как автоматическое суммирование текстов, генерация творческих рассказов или структурирование информации в формате JSON, остаются детерминированными функциями, поддающимися формальному анализу. Несмотря на отсутствие сознания, LLM оказывают огромное влияние на общество, технику и экономику, становясь новым технологическим рычагом, сравнимым с изобретением электричества. Их применение уже меняет множество отраслей: от образования и здравоохранения до бизнеса и развлечений.

Это мощный инструмент, обладающий огромным потенциалом, но требующий ответственного подхода при внедрении и эксплуатации. Понимание того, что модели создаются и обучаются людьми, а не рождаются сознательными существами, позволяет сосредоточиться на решении реальных и конкретных задач — улучшении качества данных, управлении рисками ошибок и нежелательного поведения, разработке методов оценки и ограничения вероятностей опасных или некорректных ответов. Отказ от антропоморфизации способствует более прозрачному и научному обсуждению, снижает уровень страха и мистификации, окружавших искусственный интеллект. Исторически человечество склонно объяснять непонятные явления через призму мистики и религии, как «гнев богов» или «злые духи». Современные дискуссии в области ИИ неоднократно демонстрируют подобные тенденции, когда математические инструменты превращаются в «разумных агентов».