В современном программировании часто возникает задача сериализации данных — то есть преобразования структурированной информации в последовательность байтов для хранения или передачи. Одним из широко используемых форматов для таких целей является DER (Distinguished Encoding Rules) — строгий способ кодирования данных на основе ASN.1. Несмотря на то чтоDER часто путают с ASN.1, это два разных, но тесно связанных понятия.

ASN.1 — это язык описания структуры данных, а DER — один из способов их упаковывать для передачи или хранения. Формат DER построен на принципе TLV — type-length-value, что означает, что каждая единица данных состоит из трех частей: кода типа, длины и значения. Значение занимает строго определённое количество байтов, указанное в поле длины, что позволяет однозначно интерпретировать сериализованные данные. Несмотря на кажущуюся простоту, кодирование длины в DER является переменной по размеру величиной.

Например, длина 8 будет кодироваться одним байтом [0x08], а длина 100 — двумя байтами [0x81, 0x64]. Такая особенность создает определённые сложности для разработчиков, которые собираются сериализовать данные потоково, без предварительного вычисления размера. Для многих типов данных вычислить длину значения при сериализации – процедура тривиальная. Например, для OCTET STRING длина совпадает с количеством байтов содержания, для BOOLEAN — она всегда равна одному байту. Однако для целочисленных типов ситуация усложняется, поскольку DER использует переменную длину кодирования целых чисел.

Это обусловлено спецификой представления чисел в DER: кодирование должно быть минимальным и учитывать знак числа, избегая избыточных ведущих нулей или единиц. Проблема усложняется, когда объём данных большой и различные поля имеют переменную длину. Стандартный подход к сериализации заключается в резервировании места для поля длины в буфере, записи значения, и затем вычислении фактической длины, чтобы затем обновить информацию о длине в поле TLV. Такой процесс порождает избыточные операции копирования и перестановки данных, что негативно отражается на производительности в системах с интенсивной сериализацией. В качестве примера можно рассмотреть реализацию популярной библиотеки rust-asn1, где эта проблема была решена с помощью контроля длины через предварительную оценку размера данных, предоставляемую суммарным интерфейсом для типов.

Эта оптимизация позволила отказаться от многократных операций копирования путем передачи в сериализующий код заранее вычисленной длины поля, что частично снимает накладные расходы и упрощает управление буфером. При этом вычисление длины для целочисленных типов в DER — задача нетривиальная. Традиционная реализация использовала цикл по байтам числа для определения фактического количества значимых байт. Несмотря на свою простоту, этот подход был не слишком эффективен и создавал впечатление неуклюжести. В поисках более эффективного решения была предложена другая методика, основанная на анализе битов числа, подсчёте ведущих нулей или единиц и вычислении минимального количества байтов, необходимых для корректного представления числа в DER.

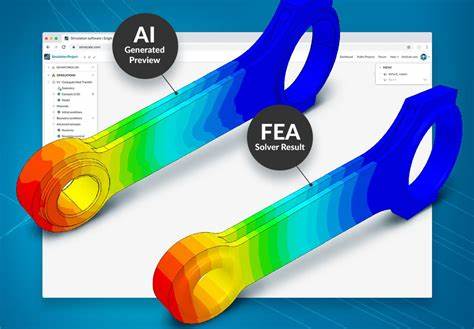

Такой подход избегает циклов и сводится к простым битовым операциям, что позволяет оптимизировать вычисление длины и уменьшить количество ветвлений, улучшая работу на уровне микропроцессорных инструкций. Однако даже этот подход далеко не идеален с точки зрения оптимизации компилятора LLVM, который иногда генерирует излишне сложный ассемблерный код для подобных битовых вычислений. Возникла идея поиска способа представить вычисление длины целого числа в более компактной и эффективной форме, которая позволила бы компилятору генерировать более быстрый и компактный машинный код. Для решения этой задачи был использован комплексный подход с применением современных инструментов, включая формальный верификатор Alive2, который позволяет гарантировать корректность и эквивалентность оптимизированного кода по сравнению с исходным. Такой метод верификации обеспечивает уверенность, что новая оптимизация не нарушит поведение программы.

Дальнейший шаг — внедрение новой оптимизации в LLVM, которая заменяет менее эффективный последовательный процесс вычисления длины более оптимальным блоком кода. Для этого была написана серия тест-кейсов, обеспечивающих проверку корректности работы новой реализации в рамках существующих тестов оптимизаций LLVM. Интересно, что в разработке значительную роль сыграли современные модели искусственного интеллекта — в частности, Claude. Использование ИИ для разработки низкоуровневых оптимизаций показало удивительно хорошие результаты, включая генерацию корректного и эффективного кода, а также поддержку в составлении тестов. Этот опыт продемонстрировал потенциал сочетания формальной верификации и генеративного ИИ как перспективного инструмента для разработки компиляторов и оптимизирующих технологий.

Результаты внедрения новой оптимизации в LLVM оказались впечатляющими: уменьшилось количество инструкций ассемблера, улучшилась производительность и снизилась избыточность кода. Более того, процесс разработки показал важность тщательного код-ревью и комплексного тестирования, особенно при использовании автоматизированных помощников. В итоге повышение эффективности сериализации DER имеет непосредственное влияние на производительность приложений, работающих с криптографическими протоколами, инфраструктурой публичных ключей и другими системами, основанными на ASN.1. Малейшие улучшения на уровне кодирования данных могут оказывать заметное влияние на скорость и надежность крупных систем.

Этот кейс также подчёркивает, что пространство для оптимизаций компиляторов и низкоуровневых библиотек всё ещё широко открыто, даже в 2025 году. Внимательное изучение и постоянный поиск узких мест способны привести к существенному повышению качества и эффективности программного обеспечения. Таким образом, понимание принципов сериализации в DER, а также современных методов оптимизации и автоматизации разработки, является важным аспектом профессиональной работы разработчиков программного обеспечения, стремящихся создавать быстрые, устойчивые и корректные решения. В совокупности, эти знания открывают новые возможности для оптимального взаимодействия между высокоуровневыми абстракциями и аппаратными ресурсами, что является ключевым фактором успеха в программной инженерии.