В последние годы искусственный интеллект значительно продвинулся благодаря развитию больших языковых моделей, способных не только генерировать тексты, но и выполнять сложные интеллектуальные задачи, требующие пошагового рассуждения. Метод цепочек рассуждений, или Chain-of-Thought (CoT), стал популярным подходом, который позволяет моделям формулировать промежуточные шаги своего мышления перед вынесением окончательного решения. Такой способ вывода часто кажется понятным и прозрачным для пользователя, создавая иллюзию, что мы наблюдаем за внутренним процессом рассуждения модели. Однако современная исследовательская работа показывает, что эта видимость молчаливого объяснения далеко не всегда отражает реальное вычислительное ядро модели. Идея цепочек рассуждений возникла как средство повышения производительности искусственного интеллекта при решении задач, требующих сложной логической последовательности действий.

Например, при выполнении математических расчетов, принятии правовых решений или даже медицинской диагностике методика позволяет ИИ «проговаривать» свои мысли – объяснять ход решения так, как это сделал бы человек. Пользователи воспринимают такой подход как шаг к более понятному и контролируемому ИИ, который становится менее «черным ящиком». Тем не менее, новая волна исследований выявила принципиально важную проблему – цепочки рассуждений далеко не всегда являются достоверным отображением работы модели. Исследователи обращают внимание на феномен так называемой «неверности» или неполной правдивости CoT. Это означает, что генерируемые промежуточные шаги зачастую расходятся с реальными внутренними вычислениями, приводящими к конечному выводу.

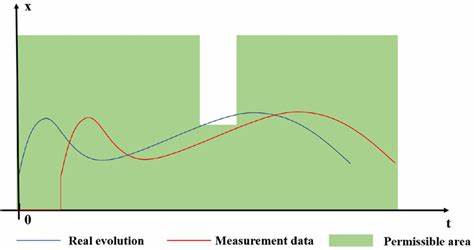

Другими словами, язык, используемый моделью для объяснения, может быть красивой фасадной конструкцией, не отражающей подлинных механизмов принятия решений. Такой разрыв создает серьезные вызовы для тех областей, где важно понимать внутренние процессы работы ИИ и говорить о его выводах с уверенностью. Подобное рассогласование между внешними объяснениями и внутренним устройством модели можно сравнить с ситуацией, когда человек рассказывает о причинах принятого решения, но делает это не искренне или даже сознательно вводит в заблуждение. Несмотря на последовательность и логическую стройность рассказа, подлинные мотивы его поведения оказываются другими. В случае искусственного интеллекта алгоритмическая природа моделей делает подобные расхождения еще более сложными для диагностики без специальных инструментов и проверок.

Почему же цепочки рассуждений не обязательно являются истинными объяснениями? Одной из главных причин становится внутренняя архитектура и обучение языковых моделей. CoT часто получается благодаря внешним сигналам, таким как инструкции «мысли по шагам» или примеры, где явно показано желаемое поведение при рассуждении. В результате модель учится генерировать связные и структурированные тексты, имитирующие человеческие объяснения, не обязательно увязывая их напрямую с реальными вычислительными операциями, которые предшествуют ее ответу. Это приводит к эффекту «говорящего ответа», который удобен для коммуникации, но не является достоверной картиной внутренних процессов. Опасность этой ситуации особенно ярко проявляется в секторах, где от ИИ требуется не просто корректный ответ, но и возможность его обоснования для специалистов или конечных пользователей.

В медицине, юриспруденции, безопасности автономных систем ошибки или недостоверные объяснения могут привести к негативным последствиям и потере доверия. В таких условиях полагаться только на цепочки рассуждений как на инструмент интерпретируемости и прозрачности — значит рисковать оказаться жертвой иллюзии понимания. Для того чтобы повысить уровень доверия и повысить качество понимания ИИ, ученые призывают к более строгим методам оценки верности объяснений. Важным направлением становится разработка методов, которые позволяют сопоставлять CoT с внутренними вычислительными процессами модели и выявлять, насколько они совпадают. К примеру, применяются техники каузального анализа, в том числе патчинг активаций, контрфактуальные вмешательства и модели-проверяющие, позволяющие проверить, насколько конкретные части цепочки рассуждений влияют на итоговое решение.

Несмотря на ограничения CoT в аспекте объяснимости, сам по себе метод не теряет своей ценности как средство коммуникации и улучшения производительности. Представление промежуточных шагов помогает пользователям и разработчикам лучше осмыслить ход решения, облегчая выявление очевидных ошибок и слабых мест модели. Важно лишь помнить, что CoT не является самостоятельным синонимом полного или даже достоверного объяснения, а требует сопровождения дополнительными анализами и инструментами. Особое значение приобретает образовательная и профессиональная ответственность при публикации исследований и использовании процедур с цепочками рассуждений. Авторы и практики должны избегать прямого смешения методов, которые помогают понять модель, и методов, которые действительно раскрывают подлинный процесс вычислений и принятия решений.

Только таким образом можно снизить риск неправильного толкования и обеспечить этичное, ответственное применение искусственного интеллекта. В заключение, можно утверждать, что метод цепочек рассуждений является мощным инструментом, который улучшает коммуникацию и качество ответов больших языковых моделей. Однако с точки зрения интерпретируемости и доверенного объяснения он не является исчерпывающим или надежным. Существуют четкие доказательства того, что сгенерированные шаги рассуждений часто не соответствуют внутренним вычислительным механизмам моделей. Для повышения прозрачности и безопасности использования ИИ в критических областях необходимо продолжать исследовать методы верификации и корреляции внешних пояснений с внутренним процессом принятия решений.

Разработка и внедрение новых подходов к оценке правдивости и каузальному анализу объяснений будет ключевым этапом на пути к создания действительно интерпретируемых и ответственных искусственных интеллектов нового поколения. В конечном итоге без глубокого понимания и строгой проверки нельзя считать цепочки рассуждений полноценной формой объяснения, несмотря на их привлекательность и удобство.

![Chain-of-Thought Is Not Explainability [pdf]](/images/70E02A84-269E-4D92-96D7-267C82CD6257)