Искусственный интеллект быстро становится неотъемлемой частью нашей жизни, проникая во все сферы — от медицины и финансов до образования и креативной индустрии. Однако вместе с этим стремительным развитием технологий возникает тревожное ощущение, что человечество начинает терять контроль и понимание процессов, лежащих в основе ИИ. Крупнейшие игроки на рынке искусственного интеллекта, такие как OpenAI, DeepMind и Anthropic, публично обсуждают эту проблему, подчеркивая важность сохранения способности управлять и интерпретировать поведение сложных моделей ИИ. В чем же суть этой проблемы и почему она становится все более актуальной? Современные системы ИИ строятся на глубоком машинном обучении и нейронных сетях, которые функционируют как черные ящики. Они могут демонстрировать впечатляющие результаты, предсказывать поведение, принимать решения и генерировать тексты, изображения и музыку, но при этом механизм их работы зачастую остается непонятным даже для разработчиков.

Каждая новая версия моделей становится все сложнее, обрабатывая устрашающие массивы данных и создавая внутренние представления, которые трудно интерпретировать традиционными методами. Представители OpenAI, DeepMind и Anthropic указывают, что современные архитектуры и алгоритмы, несмотря на их эффективность, создают новый вызов — мы рискуем потерять возможность полностью разобраться в том, как именно работает тренировка ИИ, почему он выдает такие, а не другие ответы, и какие потенциальные риски это несет. Особое беспокойство вызывает то, что непреднамеренные и необъяснимые решения подобных систем могут привести к ошибкам в критически важных областях, таких как здравоохранение или автономный транспорт. Дополнительным усложняющим фактором является масштаб и скорость развития технологий. Масштабные языковые модели, которые в состоянии анализировать и генерировать тексты на сотнях языков с удивительной точностью, растут как в размере, так и в вычислительной мощности.

В то же время исследования в области систем с общим интеллектом и агентах, способных к обучению и адаптации в реальном времени, требуют все более тонкого контроля и понимания. Anthropic, компания, основанная бывшими участниками OpenAI, делает акцент на разработке более безопасных и интерпретируемых моделей ИИ. Их подход заключается в создании архитектур, которые можно лучше объяснить и прогнозировать их поведение. Они стремятся разработать методики, позволяющие не только обучать модели, но и понимать, каким образом они принимают решения, выявлять потенциальные слабые места и управлять рисками. OpenAI, в свою очередь, подчеркивает важность прозрачности и этики в развитии ИИ.

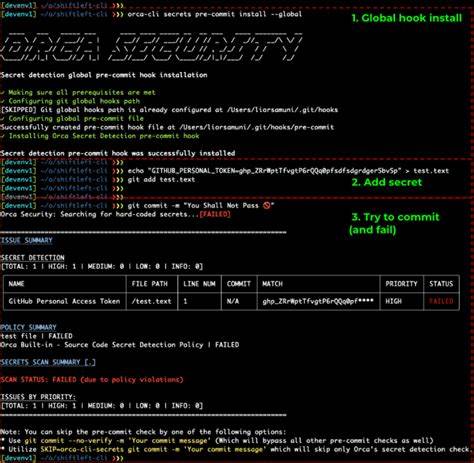

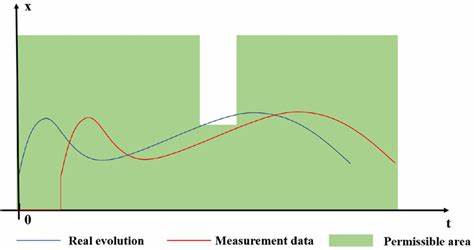

Они инвестируют значительные ресурсы в создание инструментов для интерпретации моделей и коммуникации с пользователями на понятном языке, что помогает снизить недопонимание и увеличить доверие к технологиям. DeepMind, как лидер научных исследований в области ИИ, уделяет большое внимание не только развитию алгоритмов, но и изучению прагматических вопросов, связанных с объяснимостью и безопасностью. Их эксперты исследуют закономерности в поведении нейросетей и пытаются найти способы, как сделать модели более предсказуемыми и управляемыми. На сегодняшний день главная сложность заключается в том, что традиционные методы анализа и интерпретации ИИ начинают показывать свои ограничения. Новые модели зачастую дают ответы, основанные на сложных внутренний представлениях и комбинациях параметров, которые не поддаются простому логическому разбору.

Это приводит к тому, что даже специалисты нередко оказываются в затруднении при выявлении причин тех или иных решений или возникновении непредвиденных ошибок. Важным аспектом является и то, что общество в целом должно понимать эти технологии. Если ИИ становится частью повседневной жизни, но при этом широко используется без достаточной информированности и понимания его ограничений, это может привести к серьезным социальным и этическим проблемам. Разработка новых стандартов, обучение и просвещение пользователей ИИ — это ключевые задачи, которые стоят перед всем научным и технологическим сообществом. Кроме того, философский вопрос о влиянии искусственного интеллекта на человеческое мышление и способность к критическому осмыслению становится всё более актуальным.

Некоторые эксперты предупреждают, что чрезмерная зависимость от ИИ может снижать навыки анализа и принятия решений у людей, что в долгосрочной перспективе приведет к новому типу уязвимости. Финансовые компании, государственные учреждения и технологические корпорации уже начинают внедрять специальные программы для мониторинга и анализа ИИ-систем, чтобы избежать неожиданных сбоев и неправильных интерпретаций. Однако для достижения действительно надежной и безопасной интеграции искусственного интеллекта необходимо совместное усилие исследователей, инженеров, юристов и общественности. Таким образом, сегодня мы стоим на пороге новой эры, когда искусственный интеллект достигает невиданных высот, но при этом создает уникальные вызовы для понимания и контроля. OpenAI, DeepMind и Anthropic открыто говорят о том, что сохранять способность ясно видеть, как функционируют современные ИИ-системы — не просто полезно, а жизненно важно.

Только сбалансированный подход, в котором технологии идут рука об руку с прозрачностью, безопасностью и просвещением, способен обеспечить гармоничное развитие искусственного интеллекта и его эффективную интеграцию в наше общество. В будущем задача человечества — не только создавать все более совершенные модели ИИ, но и развивать инструменты, которые помогут нам не терять способность понимать и управлять этими мощными технологиями.