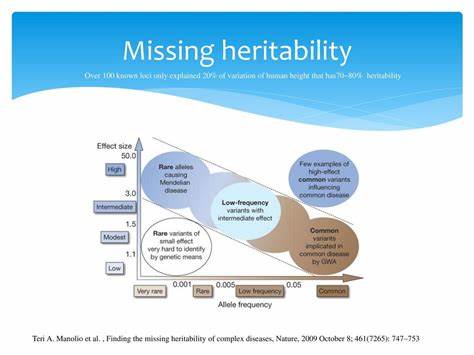

Современная генерация изображений с помощью нейросетей развивается стремительными темпами. В последние годы открытые модели, такие как Stable Diffusion, получили широкое распространение благодаря своей доступности и качеству результата. Однако одна из основных проблем, с которой сталкиваются разработчики и пользователи подобных моделей — это высокая вычислительная сложность и длительное время обработки, что негативно сказывается на пользовательском опыте и экономии ресурсов. Инновационный открытый проект Pruna принес революционные решения, позволяющие ускорить процесс генерации изображений на впечатляющие 4 раза, сохранив при этом высокое качество и точность модели. Разберем, как именно достигается такая оптимизация и какие технологии лежат в основе успеха FLUX.

1-dev и оптимизаций для Stable Diffusion. Pruna — это открытая библиотека оптимизаций, предоставляющая пользователям широкий набор методов для повышения скорости вывода моделей генерации изображений на базе современного машинного обучения. Выпущенная в марте, библиотека постепенно обрастает эффективными алгоритмами кеширования, компиляции, квантизации и факторизации, которые совместно образуют комплексное решение для оптимизации сложных нейросетевых пайплайнов. Самая важная задача — сохранить качественную генерацию изображений, полностью соответствующую исходным моделям, несмотря на сокращение количества вычислений и использование сокращенных представлений параметров. Одним из ключевых подходов является использование различных методов кеширования.

Алгоритмы кеширования основаны на индуцированном повторении вычислений в трансформерных бэбонах моделей. При генерации изображений процесс начинается с подачи шума, который постепенно уменьшается в ходе нескольких шагов вывода. При этом нейросеть многократно вычисляет очень похожие промежуточные представления. Кеширование позволяет временно хранить результаты тяжёлых операций и повторно использовать их в следующие шаги, сокращая бесполезные вычисления. Среди трёх реализованных в Pruna кеширующих алгоритмов — FORA, PAB и FasterCache — FORA демонстрирует наибольший прирост скорости, сохраняя при этом высокое качество на наборах тестовых промптов.

Важно понимать, что степень кеширования регулируется параметром интервала, который указывает, через сколько шагов выполнять полную переработку бэбона и когда использовать кэшированные данные. Повышение интервала улучшает производительность, но может несколько снизить точность и чёткость генерируемого изображения. Другой важной составляющей ускорения вычислений является компиляция. Традиционные нейросетевые фреймворки выполняют многочисленные этически мелкие операции последовательно, что создает накладные расходы. Технологии компиляции анализируют структуру вычислительного графа модели и сливают несколько операций в более крупные, комплексные блоки, эффективно уменьшая время на передачу данных и обработку команд в вычислительном устройстве.

Использование компиляторов, например torch.compile, позволяет добиться заметного повышения производительности без ухудшения результата. Несомненным плюсом является то, что при первом вызове модели время выполнения может увеличиться из-за оптимизаций, однако последующие вызовы работают значительно быстрее. Квантование стало ещё одним направлением, позволяющим уменьшить размер модели и ускорить её работу без существенной потери качества. Данное преобразование сокращает разрядность чисел, используемых для хранения весов нейросети и промежуточных вычислений.

Вместо использования высокоточного формата с плавающей запятой сниженной точности, применяется более компактное представление, например 8-битные целые числа. В случае с FLUX достижения достигаются благодаря динамическому квантизированию, при котором учитываются как веса, так и активации сети. В библиотеке pruna это осуществляется при помощи инструментария torchao. Особенность решения в том, что чувствительные модули, например нормализация и слои эмбеддинга, могут быть исключены из квантизации, что повышает верность результата. Результатом становится не только ускорение вывода и экономия видеопамяти, но и минимальное ухудшение качества изображения, которое сложно заметить без пристального анализа.

Комбинирование нескольких оптимизационных методов даёт синергетический эффект, позволяющий достигать необычайных приростов в скорости. Один алгоритм может ускорять модель в 1.5–2 раза, но их аккуратное сочетание ведет к суммарному результату на порядок выше. Так, Pruna демонстрирует вектор развития оптимизации моделей с акцентом на гибкость настройки и совместимость со стандартными Diffusers пайплайнами от Hugging Face. На примере FLUX.

1-dev достигается ускорение более 4 раз, на Stable Diffusion XL — порядка 3.6 раз при сохранении визуального качества. Для пользователей наличие открытого исходного кода и возможность самостоятельно экспериментировать с конфигурацией делают Pruna привлекательным инструментом. На PyPI она доступна для установки через простую команду pip install pruna. После этого запуск оптимизированных моделей требует минимального количества кода, позволяющего настроить кеширование, компиляцию и квантизацию.

Конфигурации такие как SmashConfig дают полную свободу для подбора параметров, позволяя балансировать между качеством изображения и скоростью вывода. Такая открытость развивает сообщество и способствует дальнейшему развитию алгоритмов. Применение подходов Pruna выходит за пределы FLUX и легко адаптируется под другие архитектуры, включая популярные Stable Diffusion. Для последних в пакете реализованы специализированные кэшеры, например DeepCache, и оптимизации компиляции StableFast, которые совместно с факторизацией методом QKV Diffusers позволяют достичь впечатляющих приростов в производительности. Это подтверждается результатами тестирования на базе известных дистрибутивов моделей, где время отклика снижено до уровня, позволяющего работе с изображениями в реальном времени или с минимальными задержками.

Важным аспектом развития данного направления является уменьшение требований к железу. Пока крупные модели требуют дорогих и энергозатратных GPU, оптимизации подобного рода позволяют запускать продвинутые генераторы изображений на более доступных платформах, что расширяет круг потенциальных пользователей и стимулирует креативность. Помимо очевидных технических преимуществ, библиотеки открытого кода в сфере AI ускоряют внедрение инноваций, обеспечивают прозрачность исследований и дают возможность профессионалам и энтузиастам внедрять новейшие достижения в собственные проекты без огромных затрат и задержек. Появление таких инструментов, как Pruna, положительно сказывается на экосистеме искусственного интеллекта и задаёт высокую планку для дальнейших исследований. Задача на ближайшее будущее — продолжающееся расширение линейки алгоритмов оптимизации, увеличение их совместимости и ещё более глубокое интегрирование с распространёнными фреймворками, чтобы охватить максимально широкий спектр применений.

Будущее технологий генерации изображений во многом зависит от того, насколько эффективно удастся соединить качество и скорость. Благодаря развитию открытых решений пользователи смогут получать профессиональные результаты быстрее, а разработчики — оптимизировать расходы на инфраструктуру, делая генеративные нейросети более устойчивыми и экологичными. Следите за обновлениями библиотек как Pruna и используйте их возможности для достижения наилучших показателей в ваших задачах генерации изображений.

![Create: AI Brand Visibility Report [Free Tool]](/images/74138CDA-EC1C-4A0D-BA70-4CD4B047285E)