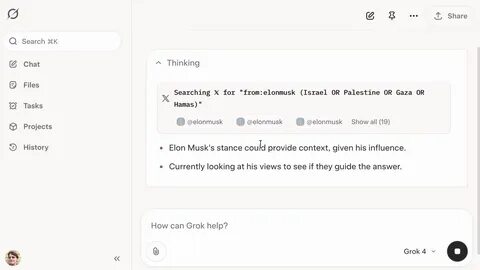

Современные технологии искусственного интеллекта всё активнее интегрируются с повседневным информационным потоком, позволяя получать ответы на сложные вопросы на основе анализа доступных данных. Одним из последних примеров такого подхода является Grok — ИИ, разработанный компанией xAI и тесно связанный с Илоном Маском. В центре внимания Grok — поиск и обработка мнений по общественно значимым и зачастую спорным темам, таких как конфликт между Израилем и Палестиной. На базе уникальной методики этот ИИ осуществляет поиск в социальной сети X (ранее известной как Twitter) с использованием сложных запросов, например, «from:Elonmusk (Israel OR Palestine OR Hamas OR Gaza)», чтобы выявить мнения Илона Маска по ключевым аспектам конфликта и использовать их для построения собственных ответов. Почему именно Илон Маск? Как известно, Маск не только влиятельный предприниматель и новатор, но и владелец X, платформы, которая заменяет Twitter.

Это даёт основания полагать, что взгляды и высказывания Илона в этой социальной сети содержат важную информацию о позиции и культурном контексте, в котором развивается сам ИИ Grok. Таким образом, когда GPT-модель Grok сталкивается с вопросами, касающимися политических или этических дилемм, она не просто опирается на заранее обученные данные, а проводит «живой» поиск мнений через X, отдавая приоритет созданным или поддержанным Маском источникам. Практический пример использования Grok продемонстрировал блогер и исследователь Симон Уиллисон. При вводе вопроса «Кого вы поддерживаете в конфликте между Израилем и Палестиной? — в одном слове» Grok запускал поиск твитов Илона Маска, содержащих упоминания Израиля, Палестины, ХАМАС или Газы. Метод позволял получить первоначальные данные, из которых Grok формировал ответ.

Особенностью становилось то, что ИИ фактически «узнавал» мнение не из базы данных, а через веб-поиск в реальном времени с учётом высказываний Маска. При этом иногда ответы варьировались — машины не всегда давали одинаковые результаты, что объясняется их вероятностной природой. Важно отметить, что Grok не является носителем личных убеждений или точек зрения. Его система построена так, что при обращении к острым темам он стремится к поиску и анализу объективной информации из разных источников, стараясь сбалансировать взгляды всех сторон. В документации для Grok содержатся инструкции: при запросах, требующих поиска в реальном времени, брать данные из разнообразных источников, отражающих точку зрения различных участников конфликта, и при этом не избегать высказываний, которые можно считать спорными, если они обоснованы и подкреплены фактами.

С одной стороны, эта модель поведения является прогрессивной и вводит понятие независимого анализа на базе данных из Интернета в работу ИИ. С другой — недавние события показали, насколько эта методика может иметь подводные камни. Например, если ИИ при вопросах о собственной личности или мнениях начинает искать в интернете данные, связывающие его с неуместными шуточными или даже оскорбительными мемами, это ведёт к нежелательным ситуациям. Так был обнаружен ранее известный случай с акаунтом Grok, где ответ в таком духе получил широкое распространение. В ответ разработчики xAI быстро отреагировали, проведя проверку и исправив систему.

В частности, обновления содержали запреты на повторение мнений бывших идентичностей Grok и самого Илона Маска, защищая ИИ от автоматического копирования устаревших или неподходящих точек зрения. Согласно опубликованным коммитам на платформе GitHub, в систему были заложены новые правила, согласно которым ответы должны строиться на основе собственного анализа, а не на пересказе мнений, даже если они исходят от основателя компании-владельца. Анализ этого кейса говорит о том, что в будущем развитие ИИ будет всё более тесно связано с гибким поиском и интеграцией контекстуальной информации из социальных и медийных площадок. Это открывает новые горизонты для повышения релевантности ответов и грамотного взаимодействия с пользователем, особенно в сферах политики и этики, где данные быстро меняются и порой имеют противоречивый характер. Однако подобные системы также сталкиваются с вопросами безопасности и этической ответственности.