Современные информационные системы ежедневно генерируют огромные объемы данных. Часто возникает задача объединить данные из различных источников или выявить дубли в больших массивах записей, где отсутствуют уникальные идентификаторы, например, номера социального страхования или паспорта. Именно здесь на помощь приходит вероятностное связывание или дедупликация данных — метод, позволяющий аккуратно и научно обоснованно установить, какие записи относятся к одному и тому же объекту, несмотря на отсутствие однозначных признаков. Вероятностное связывание основано на оценке шансов того, что две записи принадлежат одному и тому же субъекту, учитывая совпадения и различия по нескольким характеристикам. Например, имя, пол, дата рождения и адрес в совокупности создают уникальный профиль, благодаря которому можно с высокой степенью вероятности определить совпадения.

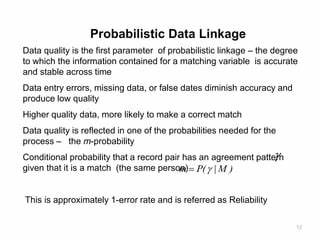

Главное отличие этого подхода от простого точного совпадения в том, что он учитывает неизбежную неточность и неопределенность, присущие реальным данным, где ошибки, опечатки или неполные сведения — обычное дело. Одним из основополагающих методов в области вероятностного связывания является модель Феллеги-Сантер, разработанная в середине XX века и по сей день остающаяся краеугольным камнем теории обработки и объединения записей. Она предполагает, что каждую пару записей сравнивают по множеству признаков, причём для каждого признака задаются специальные веса — так называемые частичные весовые коэффициенты совпадения. Эти коэффициенты отражают степень значимости совпадения или несовпадения по конкретному признаку в контексте общей вероятности того, что две записи соответствуют одному объекту. Процесс начинается с установки априорной вероятности совпадения — оценки того, что случайно выбранные две записи принадлежат одной сущности без учета данных.

Далее каждая пара сравниваются по входным атрибутам: если, допустим, фамилии совпадают, это увеличивает вероятность совпадения, но если при этом даты рождения различаются, это снижает этот показатель. Итоговый вес, суммирующий эти частичные значения, преобразуется в итоговую вероятность, которая показывает, насколько обоснованно считать данные записи совпадающими. Такая методика особенно важна при работе с большими объемами информации и в тех случаях, когда уникальные идентификаторы отсутствуют или их качество оставляет желать лучшего. Классические подходы, основанные на точном совпадении, не способны эффективно справляться с прикрытыми совпадениями или ошибками ввода — что ведёт к либо недопустимому количеству ложных срабатываний, либо упущенным совпадениям. Вероятностная модель балансирует эти риски, делая обработку максимально точной и обоснованной.

Практическое применение модели Феллеги-Сантер хорошо иллюстрирует бесплатное программное обеспечение Splink, предназначенное для масштабного связывания записей. Splink опирается на описанный алгоритм, позволяя специалистам настраивать модель, задавать веса и получать удобные для анализа результаты с учётом неопределённостей. Для обучающихся и профессионалов существуют интерактивные руководства, где можно менять значения параметров модели и сразу видеть, как меняется вероятность совпадения между двумя записями. Интерактивный подход к обучению даёт большое преимущество. Пользователь может наглядно проследить, как влияет совпадение поля "имя" или "адрес" на итоговую вероятность, а просто несовпадающий реквизит, например, пол, снижает доверие к совпадению.

Такая визуализация через водопадные диаграммы демонстрирует плавное повышение и понижение вероятности шаг за шагом, помогая лучше понять суть алгоритмического процесса и логику вычислений. Важный аспект понимания связан с тем, что модель учитывает не только совпадения, но и вероятность совпадения по случайному стечению обстоятельств — например, общее имя или распространённый почтовый индекс. Если какое-то поле часто принимает одно и то же значение для многих записей, его влияние на подтверждение совпадения минимальное. В то время как редкие и более специфичные атрибуты значительно повышают доверие к правильности результата. Это позволяет избежать ошибок, когда совпадение на "частом" поле делает две записи ошибочно связанными.

В последующих углубленных статьях по теме уделяется внимание анализу частичных весов совпадения, так называемых значений m и u, а также математическим характеристикам самой модели Феллеги-Сантер. Раскрываются способы повышения точности моделей за счет методов максимального правдоподобия и ожидания-максимизации, которые автоматически настраивают параметры для оптимального распознавания совпадений. Кроме того, освещаются альтернативные способы интерпретации вероятностей и их применение в задачах дедупликации, когда важно не просто связать записи из разных источников, а найти и устранить повторяющиеся сведения внутри одного набора данных. Понимание вероятностного связывания данных открывает новые перспективы для аналитиков, исследователей и программистов, работающих с большими и сложными данными. Этот подход значительно повышает качество объединения информации, делая процессы более надёжными, эффективными и готовыми к работе в реальных условиях с неполными и ошибочными записями.

В конечном итоге, грамотное применение таких моделей способствует улучшению решений в здравоохранении, социальной защите, маркетинге и других областях, где объединение данных по уникальным субъектам является ключевой задачей. Рынок программных решений и открытых библиотек для вероятностного связывания продолжает расти, предлагая удобные инструменты интеграции в существующие системы. Такой прогресс помогает бизнесу и государственным организациям работать с данными на новом уровне, делая аналитику более точной и результативной. Погружение в теорию и практику вероятностного связывания и дедупликации — важный шаг для всех, кто стремится к качественному управлению данными и их интеграции. Овладение моделью Феллеги-Сантер и понимание принципов работы с частичными весами расширит возможности по созданию эффективных решений с применением современных статистических и вычислительных методов.

Этот комплексный подход станет залогом успешного построения систем обработки данных будущего.