Современный мир становится все более цифровым, и с этим растет важность надежной кибербезопасности. Традиционные методы защиты уже не всегда справляются с новыми, все более сложными угрозами. На смену приходит искусственный интеллект, который выступает не просто инструментом автоматизации, а интеллектуальным партнером в борьбе с киберпреступностью. Эксперименты с применением ИИ как напарника в области кибербезопасности открывают новые горизонты в анализе, обнаружении и реагировании на угрозы. Роль искусственного интеллекта в кибербезопасности многогранна.

Во-первых, ИИ способен обрабатывать огромные объемы данных с невероятной скоростью, выявляя аномалии и подозрительные паттерны, которые были бы незаметны для человека. Во-вторых, с помощью машинного обучения системы становятся способными адаптироваться к новым формам атак, постоянно совершенствуя свои модели на основе свежих данных. Это необходимо, учитывая динамику развития вредоносного программного обеспечения и методов взлома. Эксперименты с ИИ в кибербезопасности часто базируются на его способности выступать как «мышление партнер». Это значит, что искусственный интеллект не просто выполняет указания, а вместе с человеком анализирует ситуацию, предлагает гипотезы и варианты решений.

Такой подход значительно повышает эффективность защитных мер и снижает вероятность человеческих ошибок. Одним из важных аспектов использования ИИ является способность прогнозировать возможные векторы атак. На основе анализа исторических данных и текущих событий искусственный интеллект моделирует потенциальные сценарии угроз. Это позволяет специалистам заранее подготовиться и укрепить уязвимые места. Благодаря этому сокращается время реакции на инциденты и минимизируется ущерб от взломов.

Однако экспериментирование с ИИ в кибербезопасности сопровождается рядом вызовов. Прежде всего, это вопросы доверия к решениям, принимаемым алгоритмами. Для многих организаций важно понимать логику работы ИИ, особенно когда речь идет о критических системах. Недостаточная прозрачность моделей может вызвать опасения и замедлить внедрение технологий. Еще одна сложность заключается в борьбе с противодействием со стороны злоумышленников.

Киберпреступники также используют ИИ для сложных атак, создания сложных вредоносных программ и обхода защитных фильтров. В результате возникает своеобразная гонка вооружений в цифровой сфере, где обе стороны используют передовые технологии. Этика и приватность являются неотъемлемой частью экспериментов с ИИ в кибербезопасности. Сбор и анализ больших объемов личных данных требуют строгого соблюдения норм и правил. Компаниям приходится балансировать между обеспечением безопасности и защитой конфиденциальности пользователей, что требует продуманных стратегий и инструментов.

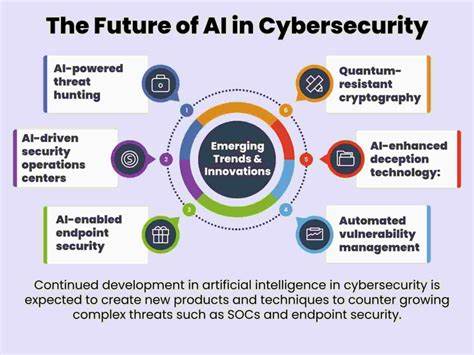

Перспективы развития ИИ как интеллектуального партнера в кибербезопасности очень обнадеживают. Современные тренды свидетельствуют о все большем внедрении технологий искусственного интеллекта на уровне протоколов безопасности, автоматизации рутинных процессов и поддержки специалистов в принятии решений. В долгосрочной перспективе ИИ может стать неотъемлемой частью комплексной стратегии защиты информации. Кроме того, развитие гибридных систем, где человек и ИИ работают в тесном взаимодействии, позволяет улучшить качество анализа и реакции на угрозы. Машины берут на себя обработку рутинных и обширных данных, а человек концентрируется на творческих и стратегических задачах.

Такой синергетический подход делает защиту более эффективной и адаптивной к быстро меняющимся условиям. Важным направлением является обучение специалистов, способных работать с системами на базе искусственного интеллекта. Без грамотной подготовки сотрудников внедрение новых технологий останется поверхностным и малоэффективным. Поэтому центры кибербезопасности вкладывают значительные ресурсы в повышение квалификации и развитие навыков взаимодействия с ИИ. Неотъемлемой частью экспериментов является тестирование новых алгоритмов в реальных условиях.