В последние годы использование искусственного интеллекта в программировании стало одним из ключевых трендов развития технологий. Одной из наиболее амбициозных инициатив в этой области является создание и внедрение кода-асистентов, таких как GitHub Copilot, поддерживаемого OpenAI. Microsoft, которая владеет GitHub, активно продвигает этот инструмент, интегрируя его во множество своих продуктов и рабочих процессов. Однако недавний опыт применения Copilot внутри самой компании, в частности в разработке .NET, выявил значительные сложности, связанные с качеством генерируемого кода.

Copilot представляет собой AI-модель, способную генерировать блоки кода на основе запросов и контекста. Идея состоит в том, чтобы облегчить жизнь разработчикам, ускорить написание программ и снизить количество рутины. Тем не менее, опыт команды Microsoft показал, что не всегда можно полагаться на сгенерированный вывод. В ряде попыток Copilot предложил решения, которые содержали ошибки, неправильные предположения или даже полностью выдуманный функционал — явление, получившее название «галлюцинации» ИИ. Галлюцинации искусственного интеллекта – это ситуация, когда модель генерирует логически связный, но фактически неверный или бессмысленный текст либо код.

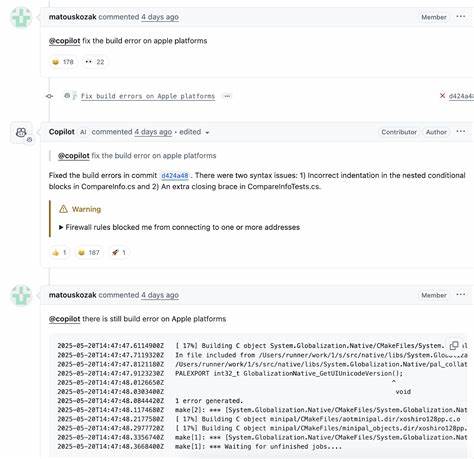

В случае программирования это особенно опасно, поскольку даже малейшая ошибка может привести к сбою приложения, уязвимостям безопасности или нарушению производственного процесса. Внутренние обсуждения и результаты публичных репозиториев .NET показали, что примерно одна четвертая часть предложенных Copilot изменений требовала значительной доработки или вовсе отклонялась из-за некорректности. Несмотря на то, что были и удачные pull request, которые успешно интегрировались, основной опыт оказал сомнительным. Это породило активное обсуждение внутри сообщества разработчиков и экспертов по ИИ, вызвав пересмотр и более критичный подход к использованию Copilot.

Одной из ключевых причин появления галлюцинаций является природа самой технологии – модель обучена на огромном количестве открытого кода и текстов, из которых она учится предсказывать наиболее вероятный следующий фрагмент. Это не означает, что она истинно понимает логику или семантику кода, а лишь пытается повторить паттерны. При работе с критически важными или сложными задачами это становится серьезным препятствием. Microsoft, осознавая эти проблемы, начала вводить обязательное использование AI-инструментов в своих процессах кода-ревью и разработке, что логично с точки зрения повышения эффективности и внедрения инноваций. Однако вместе с этим компания вынуждена усиливать контроль качества и закреплять роль человека в проверке результатов работы AI, чтобы минимизировать риски ошибок и сохранить стабильность продуктов.

Опыт Microsoft с Copilot в .NET подчеркивает, что современные AI-инструменты пока не могут полностью заменить человека, особенно в таких сферах, как разработка программного обеспечения. Вместо этого инструменты следует рассматривать как вспомогательные, которые помогают генерировать идеи, ускорять рутинные процессы и снижать нагрузку, но при этом требуют тщательного контроля и верификации. С точки зрения индустрии программного обеспечения, ситуация демонстрирует важность критической оценки AI и необходимость дальнейших исследований для повышения его надежности. Халлюцинации – это не просто случайные ошибки, а системная проблема, связанная с тем, как создаются и обучаются модели.

В будущем разработчики ИИ должны стремиться к более глубокому пониманию контекста, способности к самопроверке и интерпретации получаемой информации. Для конечных пользователей и организаций это значит, что хотя технологии искусственного интеллекта стремительно развиваются и уже демонстрируют впечатляющие возможности, использовать их необходимо осознанно. Внедрение ИИ должно сопровождаться созданием надежных процедур контроля качества, тестирования и обратной связи, чтобы исключить возможные сбои и обеспечить безопасность. В итоге опыт Microsoft с Copilot в масштабе одного из крупнейших корпоративных проектов – .NET – стал весомым уроком для всей отрасли.

Он показывает, что несмотря на значительные успехи и перспективы, борьба с галлюцинациями ИИ остаётся открытой задачей. Только совместные усилия инженеров, исследователей и пользователей смогут сделать инструменты искусственного интеллекта надежными помощниками разработчиков и не только.