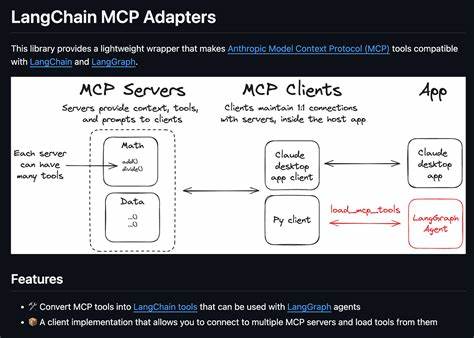

В современном мире искусственный интеллект активно трансформирует процессы разработки программного обеспечения, открывая новые возможности для автоматизации и оптимизации рабочих задач. Однако несмотря на впечатляющие достижения в области генерации кода, полноценная интеграция AI с внешними системами остается сложной и многогранной задачей. В центре внимания оказывается не столько создание первичных алгоритмов, сколько умение связать между собой изменяющиеся инструменты, API и модели с учетом особенностей их взаимодействия. Пример интеграции LangChain с популярным мессенджером Slack через MCP (Managed Control Plane) наглядно демонстрирует, насколько тонкой и требовательной к деталям может быть такая работа. Эта история иллюстрирует, почему простой AI-сгенерированный код — лишь стартовая точка, а решать возникающие на практике проблемы приходится инженерам.

Перед командой стояла задача создать конвейер, который бы позволял с помощью LangChain вызывать инструменты асинхронно, связываться с удаленным MCP-сервером и отправлять структурированные сообщения в канал Slack под управлением агента LLM, который переводит естественный язык в вызовы функций. На первый взгляд, задача звучит просто: заставить искусственный интеллект написать код, который вызовет нужную функцию и отправит сообщение. Но на практике все оказалось покрытоя плотным слоем сложностей, каждая из которых могла привести к сбоям и затруднениям разработки. Одна из первых проблем возникла из-за неправильного использования асинхронной функции. В LangChain разница между синхронными и асинхронными реализациями инструментов строго регламентирована: параметр func должен содержать синхронную функцию, а для асинхронных предусмотрен отдельный параметр coroutine.

Неправильная передача асинхронной функции в func приводила к непредсказуемым ошибкам во время исполнения агентов. Быстрая корректировка с использованием coroutine вместо func помогла избежать этой ошибки, однако вскоре возникла другая — несовпадение схемы, получаемой от модели LLM. Вместо ожидаемого JSON с отдельными параметрами каналов и текста бот получал сериализованную внутри строки структуру, что вызывало ошибки валидации при использовании Pydantic и приводило к необходимости вводить дополнительную логику очистки и корректировки данных. Такие самодельные «латки» быстро увеличивали технический долг и ухудшали читаемость. Настоящий прорыв пришел с применением функции bind_tools, которая связывает инструменты прямо с моделью LLM, обеспечивая ей контекст о правильной схеме и структуре входных данных.

Благодаря этому LLM самостоятельно вырабатывала корректные вызовы функций, соблюдая формат и типы, а инструментальная цепочка MCP → Slack стала работать надежно даже в условиях сетевых взаимодействий и частых изменений интерфейсов. Полученный опыт указывает на важные уроки для разработчиков, работающих на стыке искусственного интеллекта и интеграционных платформ. Во-первых, нельзя слепо доверять первому варианту, сгенерированному AI: без внимательного анализа и ручной проверки он может быть синтаксически корректным, но семантически неверным. Во-вторых, использование асинхронности требует точного разграничения между синхронными и асинхронными компонентами, чтобы избежать трудноуловимых сбоев в рантайме. В-третьих, попытки исправить ошибки схем данных эпизодическими правками лишь усложняют систему, тогда как правильное решение — повысить грамотность модели через привязку инструментов, позволяющую модели создавать корректные вызовы.

Эти принципы применимы далеко за пределами конкретного кейса с Slack и MCP: любой проект, включающий AI-агентов и внешний API, выигрывает от четкого определения контрактов взаимодействия и использования возможностей фреймворков для обеспечения совместимости. Интеграция AI с реальными сервисами — это не просто написание кода с использованием моделей, а создание устойчивых, масштабируемых архитектур, способных сопротивляться изменениям и непредвиденным нагрузкам. Понимание того, как работают модели, API и среда исполнения, помогает снизить количество итераций и ошибок при запуске новых функций. Итоговая ценность этого процесса — не только возможность отправлять сообщения в Slack с помощью LangChain, но и построение гибкой системы, которая останется актуальной при обновлениях LangChain, MCP или Slack API. В эпоху стремительных изменений именно такая устойчивость становится конкурентным преимуществом.

Для специалистов, занимающихся интеграцией AI-инструментов, ключевым становится фокус не на способности модели быстро генерировать код, а на том, насколько эффективно можно адаптировать этот код к реальным условиям эксплуатации. Разработка надежных пайплайнов, тщательное проектирование схем данных, использование возможностей фреймворков и постоянное внимание к аспектам асинхронности и валидации помогают избежать множества проблем в будущем. История интеграции LangChain с Slack через MCP служит отличным учебным примером с современной инженерной практики, подчеркивающим, что взаимодействие человека и машинного интеллекта должно быть глубоко продуманным и гибким, а не сводиться к механической генерации строк кода. Этот опыт подчеркивает важность профессионального подхода, который объединяет в себе знания о программировании, архитектуре систем и особенностях работы AI, обеспечивая качество и устойчивость решений в динамичной цифровой среде. Для тех, кто планирует строить сложные интеграции с участием больших языковых моделей и разнообразных внешних сервисов, уроки из этой истории станут ценным ориентиром, позволяющим избежать типичных ошибок и создавать действительно работающие продукты.

В конечном итоге, успешная интеграция — это не только автоматизация, но и искусство тонкой настройки связей между системами и людской экспертизой, формирующее будущее программной инженерии во взаимодействии с искусственным интеллектом.