Искусственный интеллект (ИИ) продолжает оставаться одной из самых обсуждаемых и перспективных технологий нашего времени. Вокруг ИИ сформировано множество ожиданий и гипотез, особенно связанных с возможностью его самостоятельного улучшения через механизм рекурсивного самосовершенствования. Многие эксперты полагают, что ИИ сможет оптимизировать сам себя, что приведет к экспоненциальному росту его возможностей и развитию сверхразвитых систем. Однако подобные прогнозы зачастую упускают из виду ряд технических, теоретических и практических ограничений, которые могут помешать реализации идеи рекурсивного самосовершенствования. Эта статья посвящена подробному анализу причин, по которым ИИ может не обрести такую способность, а также последствиям этого для науки, технологий и общества в целом.

Прежде всего, стоит понять сущность рекурсивного самосовершенствования. Речь идет о процессе, в котором искусственный интеллект не просто учится или адаптируется, а самостоятельно разрабатывает и внедряет улучшения в свой собственный алгоритм и архитектуру. Это должно привести к быстрому, часто экспоненциальному, росту интеллекта машины без прямого участия человека. Несмотря на привлекательность такой концепции, ряд факторов указывают на то, что реализация этого сценария сопряжена с серьезными препятствиями. Одна из ключевых проблем заключается в ограничениях ресурсов.

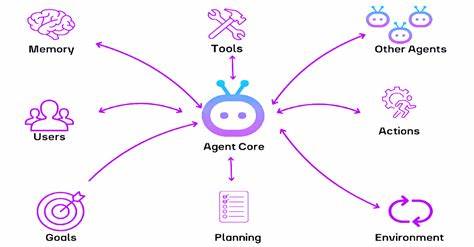

Даже при наличии продвинутых вычислительных мощностей и доступа к обширным данным, каждый шаг улучшения алгоритма требует значительных затрат времени, энергии и специалистов для контроля и анализа. Рекурсивное улучшение подразумевает, что каждый новый улучшенный ИИ должен быть способен самостоятельно создавать улучшения без внешней поддержки, что на практике может оказаться весьма труднодостижимым ввиду необходимости постоянного внешнего контроля и вмешательства, чтобы избежать ошибок и неправильной интерпретации данных. Технические ограничения архитектуры ИИ также играют важную роль. Современные системы, основанные на нейросетевых технологиях и машинном обучении, зачастую функционируют как "черные ящики", где внутренние процессы сложно проследить и интерпретировать. Это затрудняет процесс самосовершенствования, поскольку ИИ может не обладать необходимым уровнем самосознания или понимания своей собственной архитектуры, чтобы вносить глубокие и осмысленные изменения.

Без развернутого понимания своих механизмов интеллектуальная система просто не сможет эффективно оптимизировать себя в рекурсивном формате. Стоит также учитывать теоретические ограничения, связанные с фундаментальными принципами информатики и математическими законами. Известные теоремы, например, теорема Гёделя о неполноте, указывают на наличие свойств систем, которые невозможно ни полностью формализовать, ни доказать. В контексте ИИ это значит, что система не сможет полностью проверить и подтвердить оптимальность или безопасность своих собственных обновлений без внешнего вмешательства. Это накладывает жесткие рамки на возможность бесконтрольного и бесконечного самосовершенствования без риска возникновения непредсказуемых эффектов или ошибок.

Еще одним важным аспектом является человеческий фактор и социальный контекст развития ИИ. Создание и внедрение технологий всегда связано с этическими, юридическими и культурными нормами, которые регулируют и ограничивают действия разработчиков и пользователей. Использование ИИ, способного к автономному улучшению, вызывает серьезные опасения относительно безопасности, контроля и потенциала к вредным последствиям. Учитывая эти факторы, маловероятно, что подобные технологии будут выпущены в открытый доступ без значительных ограничений, что еще больше замедлит или вовсе сделает невозможным процесс рекурсивного самосовершенствования в полном объеме. Необходимо также учитывать, что развитие ИИ идет не по линейному или экспоненциальному пути в рамках одного аспекта, а зависит от множества переменных.

Это включает в себя прогресс в аппаратном обеспечении, алгоритмах, обработке данных и научных открытиях. Рекурсивное самосовершенствование требует, чтобы все эти элементы были синхронизированы и развивались параллельно, что крайне сложно реализовать в условиях реального мира с его неопределенностью и множеством внешних факторов. В итоге, представление о том, что ИИ сможет самостоятельно без ограничений улучшать свои возможности до бесконечности, является скорее теоретической концепцией, нежели практически достижимой реальностью. Ограничения ресурсов, технические и теоретические барьеры, а также факторы безопасности и контроля делают процесс рекурсивного самосовершенствования в ближайшем будущем маловероятным. Тем не менее, это не означает, что развитие ИИ остановится или пойдет по другому пути.

Современные методы машинного обучения, гибридные модели и развитие человеческого взаимодействия с ИИ продолжают открывать новые горизонты и возможности. Важно переосмыслить подход к развитию ИИ с учетом реальных ограничений и сосредоточиться на обеспечении этичности, безопасности и пользы для общества. Понимание того, почему ИИ может не стать рекурсивно самосовершенствующимся, помогает формировать реалистичные ожидания и направлять исследования в наиболее перспективные и безопасные направления. Это также способствует информированному диалогу между учеными, разработчиками, регуляторами и общественностью, что особенно важно в эпоху стремительного технологического прогресса. Таким образом, рассуждая о будущем искусственного интеллекта и его возможностях, необходимо учитывать комплексный набор факторов, которые ограничивают способность ИИ к рекурсивному самосовершенствованию.

Осознание этих ограничений не препятствует инновациям, но помогает выработать более взвешенную и ответственную стратегию развития технологий, которая принесет максимальную пользу человечеству, минимизируя риски.