Современное развитие искусственного интеллекта и глубинного обучения тесно связано с совершенствованием архитектур нейронных сетей и их базовых операций. Традиционно операция свёртки и механизмы внимания рассматривались как отдельные и специфические техники, применяемые в разных контекстах: свёртки - в основном в компьютерном зрении, а внимание - в обработке последовательностей и естественном языке. Однако последние исследования показывают, что эти операции можно обобщить и унифицировать в рамках единого теоретического подхода, что существенно расширяет возможности создания более эффективных и адаптивных нейросетевых архитектур. Основой такой унификации стала концепция обобщённой оконной операции, или Generalized Windowed Operation (GWO). Данный подход предлагает представить нейронные операции как взаимодействие трёх основных компонент: пути, формы и весов.

Путь определяет пространственную или временную локальность операции, формируя контекст выборки данных. Форма отвечает за геометрическую структуру и симметричные свойства фильтра или окна, что критически важно для сохранения инвариантности и устойчивости к трансформациям данных. Весы же символизируют значимость каждого элемента в операции, влияя на приоритет обработки и учитывая значимость признаков. Главное преимущество такого подхода заключается в его универсальности и предсказательной силе. Ведь как свёртка, так и внимание оперируют с выборками элементов данных, но различаются механизмами формирования локальности и вычисления важности.

GWO объединяет эти аспекты, формализуя их через понятия структурального выравнивания и сложности операций. Принцип структурального выравнивания гласит, что архитектура модели достигнет наилучшей способности к обобщению, когда конфигурация операции точно отражает внутреннюю структуру данных. Такой подход позволяет создавать операции, которые не просто обрабатывают информацию, а адаптивно подстраиваются под её особенности. Важным теоретическим основанием выступает связь с принципом информационного искажения (Information Bottleneck). Этот принцип утверждает, что модель должна улавливать только существенную информацию для задачи, минимизируя влияние шума и избыточных деталей.

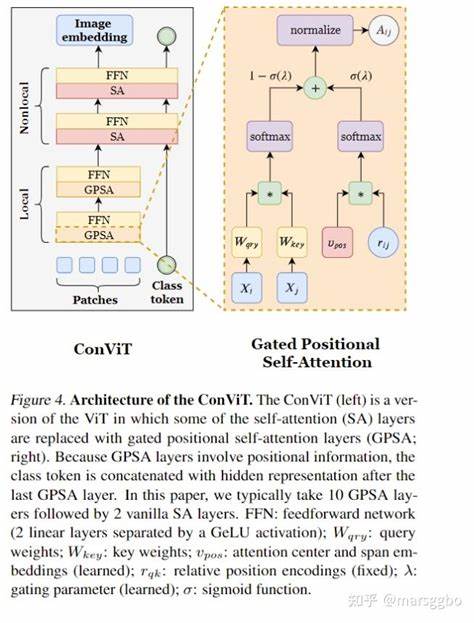

В контексте GWO это означает, что оптимальная операция балансирует между сложностью и качеством представления, фокусируясь на адаптивном регуляризующем эффекте, а не на простом увеличении вычислительной мощности. Визуализируя свёртку и внимание как частные случаи обобщённого окна, становится очевидным, почему данные техники весьма эффективны, но при этом имеют ограниченную универсальность по отдельности. Свёртки именно локальны в пространстве, строятся на фиксированной геометрии и используют универсальные фильтры. Механизмы внимания, в свою очередь, опираются на динамическое распределение весов по всей последовательности, часто без четкой геометрической привязки. Объединение этих свойств в одной операции открывает двери к созданию нейросетей с гибридными возможностями: они могут использовать локальную структуру и динамическое перераспределение внимания одновременно.

Практическое значение такой унификации сложно переоценить. Во-первых, это позволяет разрабатывать более компактные и эффективные модели, которые не ограничиваются неповоротливостью свёрток или универсальностью классического внимания. Во-вторых, GWO обогащает арсенал исследователей инструментами для гибкого конструирования новых архитектур, способных лучше учиться на сложных и разнородных данных. Реализация в рамках современного глубокого обучения показывает, что модели построенные на базе GWO демонстрируют улучшенную производительность и обобщающие способности. С точки зрения инженерии, такой подход помогает упростить программную реализацию и оптимизацию, поскольку все операции сводятся к единому функциональному шаблону.

Это облегчает интеграцию новых типов слоёв и расширений без необходимости полностью переписывать архитектуру или подстраивать параметры вручную. В итоге появляется возможность разрабатывать настраиваемые "грамматики" нейронных операций, которые автоматически подбираются под конкретную задачу и данные. Теория обобщённых оконных операций также вносит вклад в понимание природы и роли сложности моделей. Вместо старой точки зрения, что максимальное упрощение ведёт к лучшему обобщению, новое исследование показывает, что важнее качество и тип сложности. Сложность, которая ведёт к адаптивному структурному выравниванию, усиливает способность модели к пониманию данных и снижению переобучения.

В этом контексте традиционные свёртки и внимание рассматриваются как оптимальные решения, возникающие из IB-принципа для различных классов данных. Дальнейшее развитие данного подхода обещает радикально изменить парадигмы проектирования нейронных сетей. Становится возможным интегрировать идеи из теории информации, адаптивной геометрии и алгоритмической сложности в практические архитектурные решения. Такие модели смогут лучше справляться с вариативностью данных, учиться более эффективно и демонстрировать большую устойчивость к изменениям среды и типов задач. Таким образом, концепция объединения свёрточных операций и механизмов внимания через призму Generalized Windowed Operation задаёт новый стандарт в области глубинного обучения.

Она открывает перспективы для создания универсальных, гибких и устойчивых архитектур, которые лучше соответствуют сложностям реального мира и требованиям современных приложений. В центре внимания оказываются не просто технологии обработки данных, а фундаментальные принципы построения нейронных систем, основанные на глубоком понимании информации и структуры данных. .