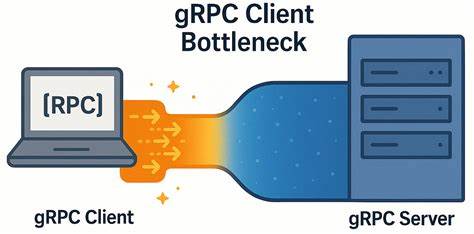

В современном мире высокопроизводительных распределённых систем протокол gRPC занимает важное место благодаря своей эффективности и надёжности при обмене данными между сервисами. Он построен на базе HTTP/2 и широко используется для взаимодействия между микросервисами, включая базы данных, такие как YDB — распределённую SQL-базу с поддержкой ACID-транзакций и строгой консистентности. Несмотря на всё распространение и успех gRPC, практика показывает, что в условиях сетей с низкой задержкой может возникнуть неожиданный узкий момент именно на стороне клиента, способный существенно ограничить производительность даже при оптимальной серверной конфигурации. В настоящей статье рассматривается суть этой проблемы, механизмы её выявления, а также предлагает проверенные решения, позволяющие повысить скорость отклика и общее быстродействие систем, опирающихся на gRPC. Основы gRPC и его архитектура Для глубокого понимания природы узкого места необходимо представить, как устроена архитектура gRPC.

По сути, gRPC обеспечивает клиент-серверное взаимодействие через соединения HTTP/2, где каждый gRPC поток соответствует HTTP/2 стриму. Клиент может использовать несколько каналов, каждый из которых ведёт отдельное TCP-соединение. Важно отметить, что все RPC-запросы могут передаваться по одному TCP-соединению, а HTTP/2 обеспечивает мультиплексирование стримов. На практике это означает, что большой поток запросов от клиента может обрабатываться через ограниченное количество TCP-соединений. Официальная документация gRPC подчёркивает, что у одного TCP-соединения существует лимит на количество параллельных стримов (обычно 100), после достижения которого новые вызовы блокируются в очереди до освобождения ресурсов.

Чтобы бороться с этой проблемой, рекомендуются два подхода: создание отдельных каналов для областей с высокой нагрузкой и использование пула каналов, где каждый канала имеет уникальные параметры конфигурации, чтобы гарантировать собственное TCP-соединение. Реальные проблемы с производительностью в низколатентных сетях В проектах YDB команда разработчиков столкнулась с парадоксальной ситуацией: при уменьшении числа узлов кластера нагрузка с клиента на сервер снижалась менее эффективно, и клиентская сторона испытывала рост задержек. Иными словами, производительность системы ухудшалась, даже хотя серверный потенциал оставался высоким, а сеть обеспечивала минимальные задержки. Для выявления причины разработчики создали простой микробенчмарк, проверяющий обмен пустыми ping-сообщениями на gRPC. Эксперимент велся на современных серверных машинах с двухузловой NUMA архитектурой, соединёнными скоростной сетью 50 Гбит/с и с задержкой RTT менее 0,05 мс.

Клиент запускался с разным числом параллельных запросов «in-flight», где каждый поток работал со своей gRPC-каналом или с пулом каналов. Анализ tcpdump показал, что вместо ожидания проблем в сети или сервере, задержки накапливались именно на стороне клиента. Прослеживалась типичная схема: клиент отправлял пакет запросов, сервер быстро отвечал, TCP-соединение освобождалось, но следующее сообщение уходило с огромной паузой в 150–200 микросекунд. Такая задержка, хоть и незначительная на первый взгляд, критична для систем с тысячами запросов в секунду, создавая узкое место на стороне клиента. Причина ограничения — использование одного TCP соединения и, как следствие, лимит на число одновременных стримов HTTP/2.

При увеличении числа параллельных запросов очереди на стороне gRPC клиента становились узким местом, вызывая увеличение латентности и снижение пропускной способности. Влияние архитектуры соединений gRPC на производительность Один TCP-соединение с HTTP/2 основано на мультиплексировании стримов для повышения эффективности использования канала. В теории это уменьшает накладные расходы на установление соединений и повышает пропускную способность. Однако по факту ограничение числа параллельных соединений и активных стримов становится доминирующим фактором пробуксовки. При работе с одним каналом gRPC, вне зависимости от количества сделанных через него вызовов, нагрузка распределяется по одним и тем же TCP-записям, в результате чего создаётся очередь активных RPC, которая заметно влияет на задержку в обработке запросов и ответов.

Если даже увеличивать число активных запросов, реальной масштабируемости не происходит из-за внутреннего ограничения гRPC, что демонстрируют результаты микробенчмарка. Решения: разделение каналов и локальный пул Для устранения клиентского узкого места команда YDB опробовала оба рекомендованных подхода и выявила, что они дополняют друг друга и образуют единое эффективное решение. Создание отдельного канала gRPC для каждого рабочего потока снижает конкуренцию за ресурсы TCP-соединения. Однако важно, чтобы каждый канал имел уникальные параметры конфигурации, например, использовать специальный аргумент GRPC_ARG_USE_LOCAL_SUBCHANNEL_POOL, чтобы гарантировать создание отдельного TCP-соединения для каждого канала. В комбинации с использованием пула каналов, когда каждый запрос направляется на разное TCP-соединение, достигается существенный рост пропускной способности и снижение латентности.

В тестах такой подход позволял увеличить скорость обработки запросов почти в 6 раз, а задержка росла значительно медленнее с увеличением числа запросов в полёте. Сравнение результатов показывает, что в сетях с низкой задержкой преимущества мультиканального подхода сильно заметны. В то же время при сетях с высокой задержкой (около 5 мс в экспериментах) эффект стал менее выраженным, что объясняется преобладанием сетевых ограничений над клиентскими внутричастыми узкими местами. Практические рекомендации и влияние на проектирование систем Данный кейс демонстрирует, что в системах с низкой сетевой задержкой и высокими требованиями к throughput стоит внимательно оценивать архитектуру клиентского взаимодействия с gRPC и не ограничиваться рекомендациями, предполагающими один канал на множество запросов. Продуманное разделение каналов с конфигурацией, обеспечивающей отдельные TCP-соединения, позволяет реализовать распределение нагрузки и избежать внутренней блокировки.

Для профессионалов, разрабатывающих высокочастотные и масштабируемые решения, использование уникальных параметров каналов и настройка локальных пулов могут стать критически значимыми мерами для достижения оптимальной производительности. Также важно оптимизировать использование CPU, закреплять потоки и процессы за ядрами и NUMA-узлами, что дополнительно снижает латентность. Итоги и перспективы развития Проблема узкого места клиента gRPC в низколатентных сетях служит полезным напоминанием, что повышение производительности требует комплексного подхода и выявления реальных бутылочных горлышек. Даже при идеальной сетевой инфраструктуре оптимизации на клиентской стороне могут стать решающими для достижения целевых показателей. Опыт YDB показывает, что тщательное тестирование, микробенчмаркинг и изучение поведения протокола на уровне TCP-соединений раскрывают скрытые проблемы производительности.

Инструменты анализа, такие как tcpdump и Wireshark, играют ключевую роль в диагностике и поиске узких мест. В перспективе оптимизация gRPC и развитие новых механизмов управления потоками, улучшение масштабируемости каналов и балансировка нагрузки на клиентской стороне обещают сделать взаимодействие микросервисов ещё более быстрым и надёжным. Активное участие сообщества в разработке и совершенствовании открытых проектов, подобных YDB, гарантирует постоянный рост качества и возможностей распределённых баз данных и связанных платформ. Таким образом, глубокое понимание внутренней архитектуры gRPC, осознание особенностей транспортного уровня и продуманное масштабирование клиентских соединений являются обязательными условиями для построения эффективных, масштабируемых и быстродействующих распределённых систем.