В современном мире технологии развиваются с колоссальной скоростью, и большие языковые модели (LLM) не являются исключением. Они проникают во множество сфер нашей жизни — от программирования до повседневного общения и творчества. Однако вместе с повсеместным распространением этих инструментов возникает множество этических вопросов и споров. Чтобы попытаться лучше понять этические дилеммы, связанные с LLM, можно обратиться к неожиданной аналогии — с алкоголем. Алкоголь — вещество, которое давно известно человечеству и имеет свои положительные и негативные стороны.

С одной стороны, это источник удовольствия, средство расслабления и социального взаимодействия. С другой — причина аддикций, разрушения семей, аварий и многих проблем общественного здравоохранения. Аналогично, большие языковые модели способны открывать новые возможности, но также создают риски и вызывают тревогу. Прежде всего, стоит отметить, что этическая дискуссия вокруг LLM осложнена несколькими факторами. Во-первых, технология уже стала повсеместной — её трудно игнорировать.

Во-вторых, вокруг LLM существует сильный гиперпрессинг – утверждения о том, что эти модели способны на всё, порой создают нездоровые ожидания и страхи. Признание успеха LLM добавляет остроты дискуссии, поскольку сложно остаться в стороне, когда технологии столь эффективны и востребованы. Давайте рассмотрим основные сложности, сопутствующие этическому восприятию LLM, используя упомянутую аналогию с алкоголем. Алкоголь — яд, который в определённых количествах и условиях человек сознательно принимает. Он может привести к негативным последствиям, включая личные трагедии и социальные проблемы.

Тем не менее, немногие чувствуют личную вину за все случаи злоупотребления алкоголем в обществе. Вы спрашиваете себя: если выпить бокал вина в ресторане, означаю ли я косвенный вклад в аварии на дорогах? Вероятно, да, но ответственность за каждое отдельное происшествие лежит на другом уровне. Аналогично, пользователь LLM, генерирующий код или творческий контент, может чувствовать себя ответственным за собственный выбор применения инструмента, но не за все возможные негативные последствия, возникающие в результате глобального использования этих моделей. Одной из важных проблем стало загрязнение окружающей среды. Обучение и эксплуатация больших языковых моделей требуют огромных вычислительных ресурсов, что, в свою очередь, ведёт к повышенному потреблению электроэнергии.

Поскольку многие энергетические источники по-прежнему связаны с загрязнением атмосферы, возникает вопрос о том, насколько этично использование LLM в условиях борьбы с изменением климата. Для отдельных пользователей или компаний вопрос заключается в поиске баланса между преимуществами и экологическим следом. Аналогия с алкоголем здесь уместна: употребление алкоголя сопровождается негативными последствиями, но каждый решает сам, насколько ему важно учитывать эти аспекты в своей жизни. Другой важный аспект — право интеллектуальной собственности. Вопросы авторского права в контексте обучения больших языковых моделей остаются неурегулированными и вызывают споры.

Создание моделей, обученных на огромном количестве текстов, включая защищённые произведения, ставит под сомнение, насколько легитимно использование подобных данных. При этом крупные технологические корпорации получают доступ к этой технологии и выступают на фоне многих талантливых авторов и художников, у которых возникает ощущение несправедливого отношения. Это напоминает проблему с алкоголем, где есть множество легальных аспектов: налоги, лицензии, ограничения. Важно балансировать интересы всех участников экосистемы, чтобы сохранить доверие общества. Ещё один вызов связан с качеством создаваемого контента.

LLM могут генерировать многоразмерный объём информации, но не всегда он соответствует высоким стандартам человека. Из-за этого возникает феномен «slopification» — когда контент, созданный машиной, выдается за человеческий, что подрывает базовое взаимное понимание и социальный контракт. Если представить, что алкоголь иногда искажает восприятие реальности, то LLM способны создавать иллюзии и ошибочные данные, ведущие к заблуждениям. Это обостряет открытую публичную дискуссию о доверии, проверке фактов и ответственном использовании информации. Одной из самых тревожных этических проблем является возможность мошенничества и обмана с использованием LLM.

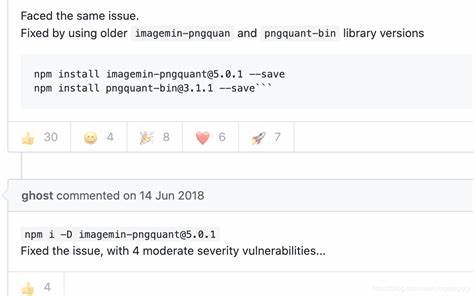

Автоматизированное создание фейковых новостей, подделка голоса и видео, создание личностных имитаций — всё это открывает большие риски для безопасности, частной жизни и общественного порядка. Как и с алкоголем, который может быть причиной насилия и преступлений, LLM могут стать инструментом для деструктивных действий. Здесь возникает дилемма: как обеспечить контроль и ответственность, не подавляя творческий и полезный потенциал технологии? Тем не менее, несмотря на все эти проблемы, многие пользователи продолжают использовать LLM с осторожностью и пониманием ограничений. В мире программирования, например, LLM уже становятся незаменимым помощником, позволяя автоматизировать рутинные задачи, получать подсказки и ускорять процесс разработки. Как и в случае с алкоголем, где любители выбирают ответственные дозы и подходящие моменты для употребления, пользователи технологий стремятся минимизировать риски и максимизировать пользу.

По мере развития и интеграции больших языковых моделей в общество, обсуждения этики будут только набирать обороты. Возможно, в будущем появятся чёткие регулирования и стандарты, которые помогут решить большинство текущих вопросов. Важно при этом сохранять баланс и не впадать в крайности: ни полного отторжения, ни безудержного поклонения технологии. Аналогия с алкоголем помогает лучше понять ситуацию — вред и польза часто сосуществуют рядом, а ключевым остается вопрос ответственности и осознанного выбора. Завершая мысль, следует подчеркнуть, что LLM — мощный инструмент, способный как вдохновлять, так и создавать проблемы.

Пользователям, разработчикам и регуляторам стоит помнить о важности этического подхода, прозрачности и диалога. В конечном итоге, как и с алкоголем, только совместными усилиями можно минимизировать вред и раскрыть потенциал, лежащий в технологии больших языковых моделей.