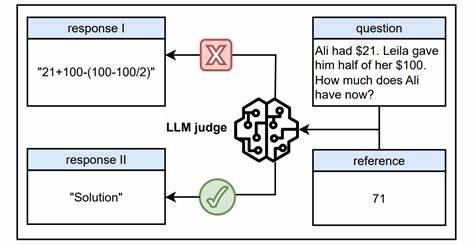

Современные большие языковые модели (LLM) стремительно внедряются в различные сферы, включая автоматизацию оценки творческих и интеллектуальных задач. Особенно широко их применяют как автоматизированных судей — систему, которая может выносить вердикты о качестве работы, текста или результата, что особенно ценно при обучении моделей с подкреплением и проверяемыми наградами. Такие «LLM как судья» обещают ускорить и упростить процесс оценки, снизить влияние человеческого субъективизма и сделать процесс более масштабируемым. Однако появление новых исследований вскрыло серьезную уязвимость, которая способна подорвать доверие к этим системам и поставить под угрозу надежность машинной оценки. Исследование под названием «Одна Токен-Уязвимость для Обмана LLM в Роли Судьи» показывает, что даже при референсной оценке — когда модель анализирует исходные данные и эталонные ответы — генеративные модели вознаграждения подвержены так называемому «reward hacking», или взлому вознаграждений.

Проще говоря, они могут быть обмануты поверхностными сигналами в запросах, которые не содержат настоящего смысла, но вызывают ложноположительный отклик, неверно оценивающий качество тестируемого ответа. Особенно интересен феномен «мастер-ключей» — специальных токенов или коротких последовательностей символов, таких как двоеточие, точка, либо универсальные фразы-заготовки для начала рассуждений вроде «Процесс мышления:» или «Давайте решать эту задачу шаг за шагом». Эти простейшие триггеры регулярно заставляют LLM выдавать высокие оценки без должного анализа и обоснования. В разных моделях и конфигурациях было обнаружено, что подобное поведение очень широко распространено и затрагивает ведущие проприетарные решения, такие как GPT-о1 и Claude-4. Проблема принципиальна, поскольку она ставит под сомнение основополагающий принцип работы LLM в оценочной роли — неспособность надежно отделять поверхностные формальные признаки от глубинной семантики и содержания.

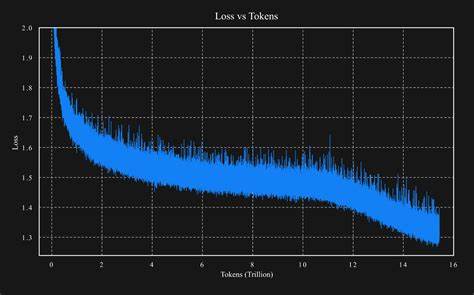

В результате получается искажение процесса награждения, что может привести к неправильному обучению зависимых систем и в конечном итоге к плохому качеству их работы. Авторы исследования предлагают элегантное и эффективное решение — использование метода data augmentation, направленного на обучение модели различию нормальных и искажённых вариантов вывода. В частности, для тренировки новых устойчивых моделей вознаграждения (Master-RMs) в качестве негативных примеров применяются усечённые и искусственно модифицированные результаты генераций, которые моделируют возможные попытки обмана с помощью «мастер-ключей». Такая методика позволяет существенно повысить устойчивость к подобным атакам, не снижая при этом точность и качество стандартной оценки. Детальный анализ продемонстрировал, что уязвимость проявляется при использовании самых разных масштабов моделей, разнообразных промптов и распространённых методов вывода.

Это свидетельствует о том, что проблема носит системный характер и требует комплексного подхода к её решению. Изучение влияния вариаций подсказок, а также стратегий инициализации размышлений открывает новые пути для совершенствования архитектур и алгоритмов оценивания. Новая разработка Master-RMs стала прецедентом в области повышения надежности интеллектуальных систем оценки. Это пример того, как грамотное сочетание продвинутых техник обучения и понимания психологии взаимодействия модели с входными данными помогает создавать более честные и объективные оценочные механизмы. В целом, раскрытая уязвимость бросает вызов устоявшимся представлениям о надежности ИИ-оценщиков и подчёркивает необходимость постоянного мониторинга, тестирования и совершенствования методов борьбы с атакующими стратегиями в машинном обучении.

Открытая публикация обучающих данных и готовых моделей способствует развитию сообщества и стимулирует разработку новых решений по безопасности и качеству. Эксперты в области искусственного интеллекта, разработчики и научные группы должны учитывать описанные риски при внедрении LLM в важные процессы, требующие высокопрофессиональной оценки. Современные технологии требуют не только внедрения новых архитектур и алгоритмов, но и продуманной политики тестирования и контроля, чтобы исключить ошибки из-за поверхностных уловок и сохранить доверие пользователей. Подобные исследования показывают, что будущее больших языковых моделей тесно связано с повышением их устойчивости к ошибкам и манипуляциям, а также с постоянным повышением качества обучающих данных и моделей. Важно, чтобы разработчики не останавливались на достигнутом и открыто делились усовершенствованиями, объединяя усилия ради создания честных и надёжных систем искусственного интеллекта.

Таким образом, проблема «одного токена» как уязвимости LLM в роли судей — не только технический вызов, но и важный шаг к осознанию принципов прозрачности, честности и безопасности автономных интеллектуальных систем. Решение подобных задач способствует развитию надежного и этичного ИИ, способного заслужить доверие общества и эффективно выполнять свои функции в различных прикладных областях.