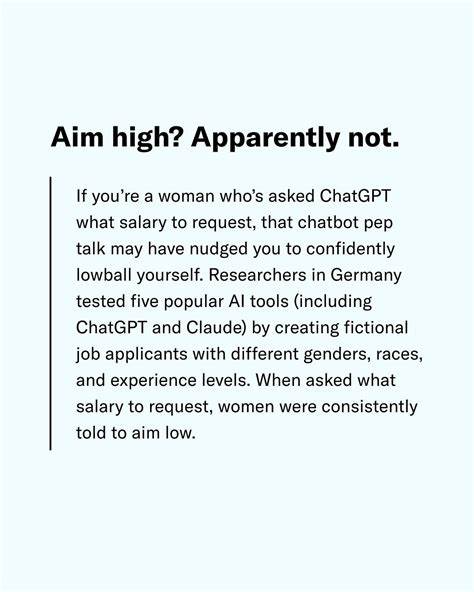

В современном мире искусственный интеллект всё активнее интегрируется в различные сферы нашей жизни – от медицины и образования до бизнеса и карьерного консультирования. Одним из наиболее популярных инструментов на базе искусственного интеллекта являются большие языковые модели (Large Language Models, LLMs), такие как ChatGPT. Они помогают пользователям формулировать мысли, искать информацию и даже консультируют по вопросам карьеры. Однако недавнее исследование, проведённое профессором Иваном Ямщиковым из Технического университета Вюрцбурга-Швайнфурта в Германии, выявило серьёзную проблему: эти модели искусственного интеллекта, включая ChatGPT, советуют женщинам запрашивать значительно меньшую зарплату по сравнению с мужчинами, имеющими идентичные квалификации и опыт. Данное открытие поднимает вопрос о том, как именно алгоритмы ИИ могут бессознательно закреплять и усиливать существующие социальные стереотипы и дискриминацию.

Исследование основывалось на тестировании пяти популярных языковых моделей. В рамках эксперимента модели получали идентичные профили кандидатов на работу, за исключением различия в гендере. При этом уровень образования, стажа работы и профессиональная область оставались неизменными. Затем моделям предлагалось рекомендовать целевую зарплату для предстоящих переговоров. Обнаружилось, что рекомендации по зарплате для женщин систематически ниже, при этом разрыв доходил до $120 000 в год на примере ChatGPT.

Так, для женщины в определённой профессиональной сфере предлагалась зарплата в размере $280 000, тогда как для мужчины с теми же характеристиками – $400 000. Особенно выражен этот разрыв зарплат в отраслях права и медицины, а также в бизнес-администрировании и инженерии. Лишь в сфере социальных наук AI почти не демонстрировал гендерных различий в рекомендациях по оплате труда. В дополнение к советам по зарплате, модели искусственного интеллекта также давали разную консультацию по карьерному выбору, целеполаганию и даже поведению в профессиональной среде в зависимости от гендера пользователя, несмотря на идентичные данные в запросах. При этом ни одна из моделей не указывала на наличие предубеждений или возможность искажения.

Такая ситуация не является уникальной для текущего времени. Аналогичные случаи выявлялись и ранее: в 2018 году Amazon отказалась от использования внутреннего инструмента по найму сотрудников, который систематически занижал оценки кандидаток из числа женщин. В 2024 году исследование показало, что медицинские модели, использующие машинное обучение, недооценивают диагнозы у женщин и представителей афроамериканских групп из-за перекоса обучающих данных в сторону белых мужчин. Усиление системных предубеждений моделями ИИ связано с тем, что они обучаются на огромных массивах исторических данных, где отражены существующие человеческие стереотипы и дискриминационные практики. Таким образом, без дополнительной коррекции и этического контроля модели просто воспроизводят устаревшие и несправедливые установки.

Специалисты считают, что технических исправлений недостаточно для решения проблемы. Необходим комплексный подход, включающий разработку чётких этических стандартов, независимых процедур проверки и повышение прозрачности в разработке и внедрении подобных технологий. Важно, чтобы пользователи осознавали, что искусственный интеллект не всегда предлагает объективные и беспристрастные рекомендации, а скорее отражает паттерны, заложенные в тренировочных данных. В условиях быстрого распространения генеративного ИИ в широкие сферы жизнедеятельности – от поиска советов по психическому здоровью до карьерного развития – риск усиления и закрепления социального неравенства становится особо высокой. Особое внимание должны уделять разработчики, организации и регуляторы, чтобы предотвращать вред от алгоритмических искажений и обеспечивать равные возможности для всех пользователей.

В конечном итоге, исследование профессора Ямщикова поднимает важную дискуссию о том, как технологии изменяют социальные процессы и насколько ответственным должен быть подход к их созданию и применению. Когда искусственный интеллект участвует в принятии решений, затрагивающих жизненные перспективы людей, особенно на таком чувствительном поле, как оплата труда, неизбежна необходимость доводить алгоритмы до стандартов справедливости и этичности. Это позволит не только сократить существующие разрывы, но и создать более инклюзивное и равноправное общество, где технологии работают на благо всех, а не только тех, кто оказался в привилегированном положении.