В последние годы тема больших языковых моделей (LLM) стала одной из самых обсуждаемых в индустрии искусственного интеллекта. На волне популярности ChatGPT и прочих продвинутых чат-ботов возник термин «prompt engineering» — якобы новая дисциплина, которая позволяет «инженерно» создавать команды и подсказки для максимальной эффективности работы ИИ. Однако, при более глубоком внимании к сути вопроса выясняется, что «prompting» — это далеко не инженерия в классическом понимании. Важно понять, почему попытки считать создание подсказок с помощью специально подобранных фраз и конструкций настоящей инженерной деятельностью являются, по сути, заблуждением. Разберёмся подробно в этом вопросе, чтобы отделить реальные методы от иллюзий и понять, что же происходит на самом деле при работе с современными языковыми моделями.

Современные языковые модели — это по сути огромные не детерминированные системы, построенные на многомиллиардных параметрах, обученных на астрономических объемах текстов. Внутренние механизмы таких моделей закрыты для конечного пользователя. Мы не знаем точно, какие именно данные попадали в обучающие выборки, какова точная конфигурация слоев, какие веса конкретно задействуются при генерации ответа. Помимо этого, существует множество дополнительных факторов, которые могут существенно влиять на поведение модели на запросы. Это и динамическая оптимизация вычислительных ресурсов, и дополнительные промежуточные слои, которые обрабатывают как входные данные пользователя, так и выходные текстовые ответы модели.

Эти параметры могут меняться с течением времени, а их точное состояние зачастую неизвестно даже разработчикам. Всё это превращает задачу работы с языковыми моделями в нечто похожее на попытку управления сложнейшей туманной машиной, внутренние процессы которой скрыты от глаз и изменяются без предупреждения. В таких условиях попытки «инженерно» оптимизировать подсказки для получения идеального результата сродни шаманским практикам, основанным скорее на вере, чем на техническом понимании устройства. Понимание «лучшего результата» вообще остается в значительной мере субъективным и неопределённым. Какие критерии использовать для оценки качества? Ответы языковых моделей зависят от множества факторов, включая случайность в генерации, состояние инфраструктуры, загруженность вычислительных мощностей.

Пользователи часто замечают, как «утром ответы модель кажется более осмысленными, а вечером — менее», несмотря на идентичные пробные подсказки. Это иллюстрация того, что даже идеальное составление фразы опирается на зыбкие условия исполнения. Популярность цепочек рассуждений (chain-of-thought) как один из методов улучшения качества ответов до недавнего времени воспринимались как прорыв. Представлялось, что моделям можно помочь логически «мыслить», направляя их через сложные конструкции подсказок. Однако исследования и практика показывают, что такие методы имеют узкую область эффективности и ограничены в практическом применении.

Они работают лишь для очень специфичных задач и требуют значительного ручного тюнинга. На более широких задачах влияние таких подходов либо минимально, либо вовсе отсутствует. Это подтверждается научными публикациями, где отмечается, что успех chain-of-thought в значительной степени зависит от узкой сферы задач и тщательно подобранных примеров. То есть, наиболее «эффективные» подсказки, как правило, требуют значительных затрат человеческой работы и экспертного знания именно области проблемы, а не простого шаблонного подхода. С развитием моделей и появлением больших контекстных окон, таких как у OpenAI GPT-4 и Google Gemini 2 Pro, терминология в «prompt engineering» эволюционировала в «context engineering» или «context manipulation».

Суть же осталась прежней — попытка улучшить ответы путём более глубокого и продуманного взаимодействия с контекстом. Но ни одна из этих техник не превращает процесс в настоящий инженерный труд в классическом понимании. Настоящая инженерия требует точных данных, воспроизводимости и контроля над системой. В случае языковых моделей эти условия отсутствуют. Таким образом, «prompt engineering» — скорее искусство, гибкий лишь частично формализуемый навык, чем строгая наука или методика.

Это скорее практика, близкая к экспериментированию, основанная на эмпирике, доходящая до уровня «магии» или «шаманства», где некоторые методики работают подчас больше благодаря вере в их эффективность, чем из-за их объективного технического превосходства. Поэтому специалистов, которые позиционируют себя как «prompt engineers», необходимо воспринимать с определённой долей скептицизма. Многие заявления, сделанные на этом рынке, зачастую напоминают свойства гомеопатии — заявления без научных доказательств и подлинной воспроизводимости. Подобные подходы не выдерживают даже малыми усилиями по проверке. По сути, работа с подсказками — это взаимодействие с черным ящиком с непредсказуемым поведением, и любые советы по «улучшению» могут быть либо случайным совпадением, либо чистым маркетингом.

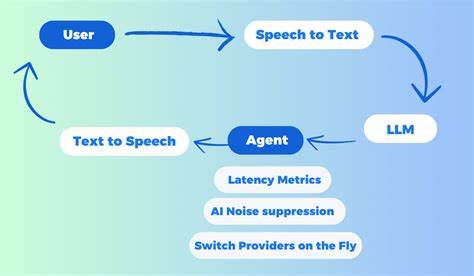

Важно сформировать правильное восприятие и ожидания от этих технологий. Вместо того чтобы сводить работу с ИИ к религии «правильных подсказок», стоит понимать, что ИИ — это инструмент, а не решение конкретных задач сам по себе. Его поведение подвержено множеству факторов вне контроля конечного пользователя. Для эффективного применения языковых моделей нужно больше внимания уделять интеграции, проверке, монтажу надёжных систем с обратной связью и гибким подходам к взаимодействию, чем бесконечному совершенствованию «идеального» запроса. Главное — не пытаться создавать из подсказок инженерный канон, а признавать их экспериментальную природу и ограниченность их влияния.

![Aardvark'd: 12 Weeks With Geeks [video]](/images/B9251125-7858-4D2C-B49F-637C1265B0B0)