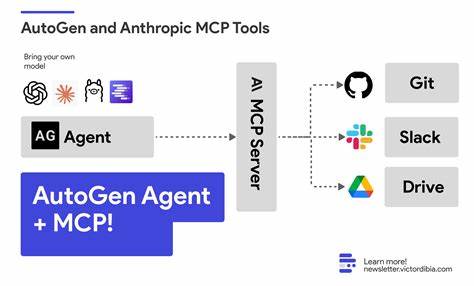

Современные технологии искусственного интеллекта продолжают стремительно развиваться, предоставляя разработчикам уникальные возможности для создания интеллектуальных агентов, способных решать разнообразные задачи. Одним из революционных подходов в этой области стал Model Context Protocol, или MCP — стандартный API, который позволяет подключать к большим языковым моделям (Large Language Models, LLM) наборы инструментов. Использование MCP значительно упрощает интеграцию внешних сервисов, позволяя выводить взаимодействие с ИИ на новый уровень. Tiny Agent, созданный с помощью MCP, демонстрирует уникальную легкость реализации мощных агентов: всего 50 строк кода хватает, чтобы построить полноценного помощника, который умеет взывать к различным инструментам и выполнять сложные команды. MCP работает как универсальный интерфейс между языковой моделью и множеством внешних инструментов.

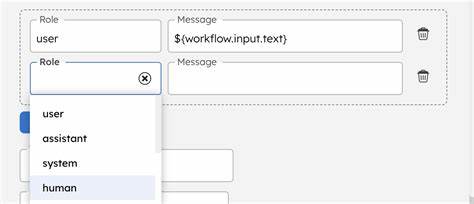

Каждое средство в контексте MCP описывается как функция с именем, описание и JSON-схемой параметров. Это позволяет LLM понимать, когда и какие инструменты использовать, независимо от внутренней реализации самих функций. Такая концепция задана в стандартах OpenAI для моделей с функцией вызова — инструменты объявляются в виде формальных контрактов, с которыми может работать модель напрямую. Реализация MCP-клиента основывается на расширении стандартных SDK для работы с моделями. В случае Hugging Face существует две официальные SDK: @huggingface/inference для JavaScript и huggingface_hub на Python.

На их базе создается MCP-клиент, который коннектится к MCP-серверам, извлекает из них набор инструментов и предоставляет их языковой модели для использования в процессе создания текста. Эта архитектура поддерживает подключение сразу к нескольким MCP-серверам, каждый из которых может предоставлять свой уникальный набор функций. Важно, что MCP-серверы в текущей реализации работают локально как процессы, однако в будущем ожидается появление и удаленных серверов, что расширит возможности масштабирования и интеграции. Tiny Agent — это на самом деле достаточно простая конструкция, служащая демонстрацией силы MCP. Главная идея заключается в том, что агент — это просто бесконечный цикл, в котором LLM генерирует текст, при необходимости вызывает инструменты для выполнения задач, получает результаты и продолжает диалог.

Вся логика посредничества сводится к загрузке инструментов с MCP-серверов и настройке общения с моделью через API, способное обрабатывать вызовы функций, встроенные в ответы LLM. Для запуска Tiny Agent достаточно установить пакет @huggingface/mcp-client через npx или pnpm и запустить скрипт. По умолчанию агент подключается к двум MCP-серверам: файловой системе и инструменту управления браузером Playwright, что дает мощь как для локальной работы с файлами, так и для автоматизированного веб-серфинга. Это позволяет Tiny Agent выполнять задачи, которые ранее требовали отдельной реализации и сложного кода: от генерации стихов с последующим сохранением их в файл до поиска в интернете и анализа первых результатов. В основе Tiny Agent лежит код на TypeScript, использующий современные возможности языка, включая асинхронные генераторы, что упрощает обработку потоковых данных и событий.

Такой подход позволяет поддерживать интерактивное, эффективное взаимодействие между пользователем и ИИ без заметных задержек. Важно, что Tiny Agent грамотно управляет вызовами инструментов, обрабатывая аргументы в формате JSON и используя готовые интерфейсы MCP для запуска соответствующих функций. Выделяется простая, но эффективная архитектура Tiny Agent — класс Agent, расширяющий McpClient, где при инициализации загружаются все доступные инструменты. Помимо инструментов MCP, в Agent добавлены две особые функции — task_complete и ask_question. Они служат для управления ходом диалога с пользователем, позволяя агенту своевременно завершать текущую задачу или запрашивать дополнительную информацию для уточнения цели.

Это снижает сложность диалогового управления в коде и делает агента гибким и адаптивным. Основной цикл работы агента — это циклическая обработка пользовательских запросов и ответов модели. Логика построена так, что агент последовательно обрабатывает ответы LLM, проверяет наличие вызовов инструментов и исполняет их, после чего возвращает результат модели. Цикл завершается, если происходят вызовы специальных управляющих функций или если количество обменов превышает лимит. Такая структура гарантирует стабильность оказания услуг и контролируемое взаимодействие с ИИ.

Использовать Tiny Agent можно с различными провайдерами и моделями. По умолчанию применяется связка Qwen/Qwen2.5-72B-Instruct на Nebius, но архитектура оставляет возможность выбора других LLM из множества доступных поставщиков, таких как Cohere, Replicate, Together и др. Следует заметить, что производительность и качество работы зависят от выбранной модели и её поддержки функций вызова. Некоторые модели требуют дополнительной настройки парсинга, но с развитием MCP и стандартов взаимодействия этих ограничений становится все меньше.

Перспективы развития Tiny Agent и самого протокола MCP впечатляют. С продолжающимся ростом числа доступных инструментов и расширением набора моделей становится возможным создавать более сложных агентов с широким спектром возможностей. Поддержка локальных LLM, таких как те, что работают на llama.cpp или LM Studio, дополнительно усилит автономность и конфиденциальность подобных решений. В будущем ожидается появление удаленных MCP-серверов, что сделает интеграцию удаленных сервисов и облачных вычислений более простой и надежной.

Сообщество открытого программного обеспечения уже активно использует Tiny Agent как базу для экспериментов и интеграций. Например, реализованы переносы его концепции на Python с целью сравнения производительности и удобства использования другими инструментами. Этот опыт демонстрирует универсальность идеи и основной архитектуры MCP-агентов. Многие разработчики отмечают, что доступность стандартизированного API для инструментов в сочетании с мощными LLM упрощает создание агентских систем, которые раньше требовали масштабных усилий. Tiny Agent выступает своего рода базовым эталоном, с которого можно быстро начать, а затем по мере необходимости развивать и адаптировать функционал под конкретные задачи и потребности пользователей.

Использование MCP и Tiny Agent способствует продвижению концепции агентного ИИ как открытой и доступной платформы, позволяющей легко подключать самые разные сервисы и инструменты. Это открывает дорогу к созданию гибких мультиагентных систем, способных координировать свои действия и решать комплексные задачи в различных сферах — от автоматизации рутинных процессов до поддержки принятия решений. В итоге, Tiny Agent — это наглядный пример того, как можно с минимальными ресурсами и усилиями построить умного помощника, способного работать с множеством инструментов и моделей. Благодаря MCP разработчикам становится доступен мощный инструмент для расширения возможностей их приложений и сервисов, а конечным пользователям — инструмент, который легко подстроится под их потребности без лишних сложностей.