Искусственный интеллект стремительно развивается, внедряясь в различные сферы жизни и бизнеса. Однако успех любых решений на базе ИИ напрямую зависит от правильной оценки моделей и систем, которые в них задействованы. Только комплексный подход к оценке позволяет создавать масштабируемые, надежные и безопасные решения, удовлетворяющие требованиям конечных пользователей и компаний. В основе оценки систем ИИ лежат три фундаментальных компонента – критерии оценки, процесс выбора модели и построение конвейера оценки. Понимание и глубокое внедрение каждого из этих аспектов жизненно необходимо для инженеров и специалистов, занимающихся разработкой ИИ-продуктов.

Эффективное развитие ИИ-приложений невозможно без четкого понимания того, какие критерии оценки применимы к конкретной задаче. Компании зачастую сталкиваются с необходимостью адаптировать стратегии оценки в соответствии со сферой применения. Например, модель, предназначенная для суммирования текста, должна оцениваться по иным параметрам, чем модель, классифицирующая отзывы клиентов. Основной узкий момент внедрения ИИ в производственные процессы – это именно процесс оценки эффективности и качества. Традиционные методы, такие как тестирование с выбором правильного варианта, часто оказываются недостаточными и непригодными, особенно когда речь идет о генерации контента, перевода или написания эссе.

При оценке генеративных моделей необходимо учитывать множество новых аспектов. Ранее главным считались такие параметры, как грамматическая правильность и логическая связность ответа. Сегодня этого недостаточно, поскольку современные крупные языковые модели (LLM) создают тексты, практически неотличимые от человеческих. Важной метрикой становится фактическая достоверность ответов: насколько предоставленная моделью информация соответствует контексту или общим знаниям. При этом существует различие между локальной и глобальной фактической согласованностью: первая проверяет корректность фактов относительно конкретного запроса или документа, а вторая ориентируется на общеизвестные истины.

Большая сложность при проверке заключается в том, что данные для обучения моделей часто содержат недостоверную или субъективную информацию. Вопросы с множеством возможных ответов, такие как "какая еда самая важная в течение дня?" или "как лучше завести нового друга?", требуют от моделей умения отделять факты, мнения и гипотезы. Современные подходы включают автоматическую само-проверку и использование вспомогательных инструментов, основанных на поиске и проверке по внешним источникам, чтобы улучшить качество и достоверность выдачи. Безопасность — еще один фундаментальный аспект при разработке клиентских решений на базе ИИ. Контент, содержащий ненормативную лексику, вредоносные советы или проявления дискриминации, вредит репутации компании и может вызвать юридические проблемы.

Постоянный мониторинг безопасности контента должен соответствовать внутренним политикам и законодательным требованиям, обеспечивая при этом положительный опыт пользователей. Качество следования инструкциям модели существенно влияет на конечные результаты. Если модель плохо понимает или игнорирует ключевые указания, то даже самые тщательно составленные запросы не смогут гарантировать желаемый ответ. Здесь стоит отметить, что автоматическая оценка таких критериев, как стилистические или лингвистические параметры, пока затруднена из-за их субъективности. При проектировании ИИ-систем значительную роль играют вопросы стоимости и задержки в обработке запросов.

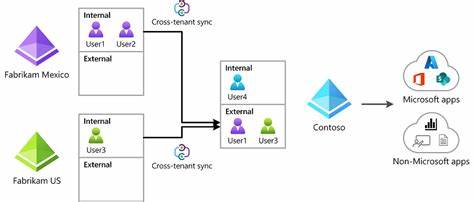

Баланс между качеством модели, временем отклика и финансовыми затратами нередко становится ключевым в выборе подходящей модели. На практике компании часто вынуждены предпочитать менее точные, но более быстрые и дешёвые решения, особенно если речь идет о масштабных системах с большим числом пользователей. Выбор модели – процесс тонкий и многогранный, требующий разделения факторов на жесткие технико-бизнесовые требования и гибкие параметры, которые можно корректировать и оптимизировать через настройки и инженеринг запросов. В ходе комплексного анализа сначала исключаются модели, не соответствующие критериям безопасности, конфиденциальности и техническим ограничениям. Далее с использованием наборов стандартных и собственных тестов и метрик выявляются кандидаты, подходящие под нужды компании.

Финальным шагом становится мониторинг выбранной модели в реальных условиях с применением как автоматических eval-методов, так и обратной связи от клиентов. Решение о построении собственной модели или приобретении коммерческого решения требует оценки затрат, нужд в контроле и специфических требований. Собственные модели обычно позволяют более детально настраивать поведение и адаптировать данные обучения, что особенно ценно в узкоспециализированных областях. Однако затраты на разработку, поддержку и масштабирование довольно велики, что делает подобный подход оправданным только для крупных или очень специфичных проектов. Использование внутренних моделей открывает возможности создавать уникальные функции и интегрировать надежные механизмы защиты и фильтрации контента.

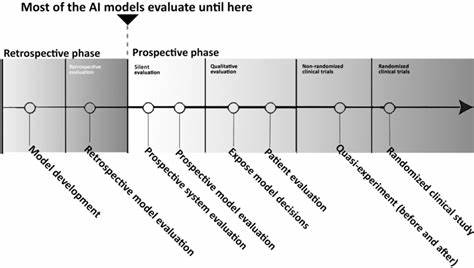

При этом риски зависимости от внешних провайдеров существенно снижаются, что особенно важно при изменениях в политике и функциональности сервисов поставщиков. Современный рынок уже очень насыщен различными эталонными тестами и бенчмарками для оценки моделей. Однако их эффективность уменьшается по мере внедрения все более мощных систем, поскольку баллы на лидирующих досках становятся почти идентичными. Возникает необходимость регулярно обновлять и усложнять тестовые наборы, чтобы они оставались релевантными и объективными. Также существует проблема «загрязнения» данных, когда обучающие наборы и тесты используют схожие источники, приводя к завышенным результатам.

Различные технологии, такие как фильтрация повторяющихся последовательностей токенов и анализ перплексии, применяются для противодействия этим эффектам. Проектирование конвейера оценки — комплексная задача, начинающаяся с глубокого анализа всех компонентов системы и определения ключевых параметров для контроля. Основой успешного конвейера являются чёткие и полные методические указания, включая примеры правильного и неправильного поведения моделей. Чем явнее и прозрачнее критерии, тем выше надёжность результатов и небольшая чувствительность к вариациям интерпретации. Методы оценки надо подбирать с учетом специфики задач: например, токсикологические классификаторы необходимы для ботов, общающихся с конфликтными клиентами, а логарифмы вероятностей помогают определять степень уверенности модели в сгенерированном токене.

Не менее важно регулярно тестировать сами eval-процессы, сопоставлять объективные показатели с пользовательской удовлетворённостью и на этой основе своевременно обновлять подходы к оценке. В конечном счёте, оценка ИИ-систем — это не просто набор технических метрик, а процесс постоянного согласования моделей с бизнес-целями, обеспечением безопасности и удобства пользователя. Независимо от того, выбирается ли коммерческое решение или создаётся собственный продукт, выстроенный и адаптируемый конвейер оценки является краеугольным камнем для создания высококачественных, надежных и эффективных ИИ-приложений.