Современные технологии искусственного интеллекта требуют максимально эффективных решений для обработки и анализа данных, особенно на этапе инференса — когда обученная модель применяет знания для выполнения конкретных задач. Оптимизация в этом направлении стала ключевой задачей для разработчиков и инженеров, стремящихся повысить производительность и снизить энергопотребление. Одним из революционных достижений в этой области стала поддержка нового формата NVFP4 архитектурой NVIDIA Blackwell — прорыв технологии 4-битных плавающих точек, который сохраняет высокую точность при значительном снижении объема вычислений и памяти. Проблема оптимизации AI-моделей традиционно связывается с методами компрессии, среди которых выделяется квантование — переход от 32-битных форматов с плавающей точкой (FP32) к низкоразрядным представлениям. Хотя это уменьшает нагрузку на аппаратные ресурсы, часто сопровождается потерей точности модели, что усложняет применение в сложных задачах.

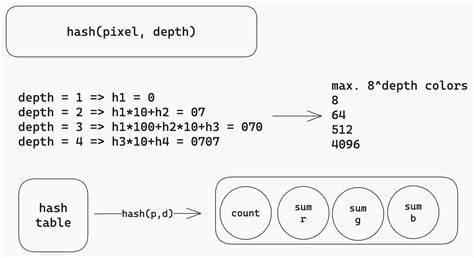

NVFP4, появившийся вместе с архитектурой Blackwell, призван решить эту дилемму, предлагая новый баланс между малым размером данных и сохранением интеллектуальной силы модели. Формат NVFP4 представляет собой 4-битное представление чисел с плавающей точкой, используя структуру E2M1 — один знак, два экспонента и одну мантиссу. Благодаря уникальному подходу в организации масштабирования данный формат покрывает диапазон значений примерно от -6 до 6, что уже достаточно для большинства параметров и активаций современных нейросетей. Однако основное отличие NVFP4 от предыдущих форматов FP4 и MXFP4 заключается в инновационной двухуровневой системе масштабирования, обеспечивающей точное представление значений даже в условиях очень низкой разрядности. Двухуровневая микро-блочная стратегия масштабирования NVFP4 состоит в применении высокоточного масштабного фактора FP8 формата E4M3 к каждой группе из 16 значений, а также дополнительного глобального масштабирования FP32 для всего тензора.

Такая архитектура позволяет локально оптимизировать представление данных, эффективно уменьшая ошибку квантования, оказывающую негативное влияние на точность модели. Визуально это напоминает деление огромного потока данных на маленькие подгруппы с индивидуально подобранными коэффициентами масштабирования, что повышает точность даже самых мелких и нестабильных элементов. Для понимания значимости подхода NVFP4 важно сравнить его с предыдущими форматами. FP4 и MXFP4 также используют 4-битное кодирование с плавающей точкой, но их масштабные факторы были либо фиксированными, либо применяемыми к более крупным блокам по 32 значения. Это приводило к возникновению большей квантовой ошибки при обработке разнообразных данных, особенно в глубоких и масштабных моделях.

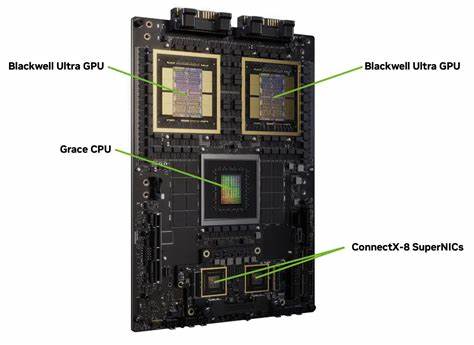

NVFP4, напротив, применяя более мелкую разбивку блоков и более точные нецелочисленные коэффициенты масштабирования, значительно снижает общее квадратическое отклонение, тем самым «сохраняя интеллект» модели на высоком уровне даже при агрессивной компрессии. Многочисленные испытания и бенчмарки, проведённые с использованием современных NLP-моделей, подтверждают, что точность, достигаемая при переходе от FP8 к NVFP4, снижается менее чем на 1%, что является замечательным результатом в контексте оптимизации. Особенно интересен пример DeepSeek-R1-0528, где при использовании NVFP4 точность иногда даже превосходит версию в FP8, достигая улучшения до 2%. Это демонстрирует способность формата не только снижать затраты на память и вычисления, но и иногда за счёт лучшего кодирования масштабов повышать качество инференса. С точки зрения аппаратной реализации архитектура NVIDIA Blackwell пятого поколения Tensor Cores полностью интегрирует поддержку NVFP4.

Она автоматически обрабатывает группировку, динамическое масштабирование и 4-битные матричные операции с высокой скоростью и энергоэффективностью. За счет этого, несмотря на уменьшенную разрядность чисел, достигается впечатляющий прирост производительности и снижение энергопотребления — в некоторых случаях до 25-50 раз по сравнению с предшествующими поколениями, что особенно важно для масштабируемых дата-центров и облачных вычислений. Память также получает значительную выгоду: NVFP4 позволяет уменьшить объём необходимой памяти на модель примерно в 3,5 раза относительно традиционного FP16 и почти в два раза по сравнению с FP8. Такой компресс позволяет хранить более крупные модели или обрабатывать больше данных одновременно, что важно для сложных задач генеративного ИИ и больших языковых моделей. В сочетании с аппаратными ресурсами типа NVIDIA GB300 NVL72 и кастомной памятью Grace, Blackwell создает комплексное решение для серьёзных вычислительных нагрузок.

Век низкопроводных и масштабируемых AI-систем вызывает также внимание к энергопотреблению — важнейшему критерию усточивого развития технологий. Тут NVFP4 проявляет себя блестяще, минимизируя энергозатраты за счёт 4-битной арифметики и современных систем охлаждения. Комбинация этих факторов делает внедрение формата особенно привлекательным для коммерческой и научной сферы. Экосистема программных инструментов активно адаптируется под NVFP4. NVIDIA предоставляет удобные средства для преобразования моделей — TensorRT Model Optimizer и LLM Compressor позволяют применять и тонко настраивать квантование, включая PTQ (Post-Training Quantization) и QAT (Quantization-Aware Training), что значительно упрощает интеграцию формата в существующие пайплайны.

Преобразованные модели легко экспортируются в широко используемый формат ONNX или встроенные чекпоинты для платформ Hugging Face, TensorRT-LLM и vLLM, что укрепляет позиции NVFP4 в индустрии и способствует его быстрому распространению. В будущем NVFP4 обещает расширяться не только в рамках LLM и NLP приложений, но и в других областях глубокого обучения, включая компьютерное зрение, рекомендательные системы и генеративные модели. Помимо повышения эффективности и уменьшения затрат, внедрение формата будет способствовать развитию новых алгоритмов, оптимизированных под низкоразрядные вычисления. Таким образом, NVFP4 от NVIDIA Blackwell — это шаг к следующему поколению AI-инфраструктуры, где скорость, точность и энергоэффективность объединяются в одном решении. Новая архитектура и прорывная технология квантования позволяют создавать модели меньшего размера без заметной потери качества, что крайне важно для практических задач и коммерческого успеха искусственного интеллекта.

Внедрение NVFP4 означает не просто новую ступень в развитии вычислительных платформ, а фундаментальное переосмысление подходов к оптимизации и масштабированию AI на современном этапе.