В последнее время технологии больших языковых моделей (LLM) стремительно развиваются, открывая новые возможности для обработки больших объемов текста и сложных задач в области искусственного интеллекта. Современные модели, такие как GPT-4.1, Claude 4, Gemini 2.5 и Qwen3, обладают контекстными окнами, которые позволяют работать с сотнями тысяч и даже миллионами токенов. Это дает пользователям и разработчикам мощный инструмент для анализа больших объемов информации.

Однако столь революционные возможности таят в себе новые вызовы, связанные с качеством и надежностью обработки данных при увеличении длины входных последовательностей. Традиционно многие предполагали, что большие языковые модели равномерно хорошо справляются с обработкой любого количества входных токенов — от сотого до десятитысячного — одинаково эффективно. На практике же оказалось, что с увеличением длины входного контекста производительность моделей снижается, и этот процесс не является линейным или равномерным. По мере роста входных данных появляется феномен, который специалисты называют «контекстная ротация» (context rot), когда качество работы модели постепенно деградирует, несмотря на теоретическую возможность обработки большого объема информации. Исследование, проведенное экспертами компании Chroma, проливает свет на причины и проявления данного явления.

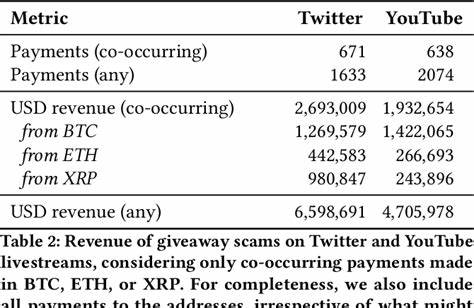

Специалисты протестировали 18 популярных моделей с разными архитектурами и размерами, включая самые современные представители индустрии. Их цель состояла в том, чтобы тщательно проанализировать влияние длины контекста на разные типы задач, сопровождая тесты контролируемыми и воспроизводимыми экспериментами. Особое внимание уделялось задачам, которые часто используются в качестве бенчмарков, например, знаменитому тесту Needle in a Haystack (NIAH), где модель должна найти «иголку» — конкретную фразу или факт — в огромном «копне сена» текста. Несмотря на популярность и масштабность этого теста, он в первую очередь оценивает способность моделей к простой лексической поисковой задаче — по сути сравнение и поиск совпадений по ключевым словам. В реальных приложениях, особенно когда требуется семантическое понимание или многозначное толкование, такие задачи оказываются значительно сложнее.

Авторы отчета расширили классические методы, включив задачи, где требуется не просто лексический поиск, но и семантическая обработка, выявление связей и контекстов, а также выделение релевантной информации в окружении многочисленных отвлекающих или нерелевантных данных. В частности, они исследовали, как различные уровни семантического сходства между вопросами и ищущими фразами влияют на результативность моделей при изменении длины входного текста. Наблюдения показали, что чем ниже степень семантической близости между запросом и искомым фрагментом, тем быстрее ухудшается точность ответа с ростом объема данных. Это особенно важно для практических приложений, где пользователи часто не формулируют поисковые запросы точно и ожидают, что система поможет выявить релевантную тему по смыслу, а не по прямому совпадению слов. Кроме того, значительное влияние на результаты оказывает присутствие в тексте отвлекающих элементов — так называемых дистракторов.

Они тематически близки к искомому объекту, но не отвечают на поставленный в вопросе запрос. Исследования показали, что однократное вхождение таких дистракторов уже снижает производительность модели, а их накопление существенно усугубляет проблему. При этом влияние каждого дистрактора различается в зависимости от конкретной модели и семантических нюансов, а с увеличением контекста эффект становится все более заметным. Удивительно, но эксперименты продемонстрировали, что логическая структура и последовательность текста — обычно считающиеся преимуществом — в некоторых случаях ухудшают качество ответов. Перестановка предложений и потеря связности в «копне сена» приводила к улучшению результатов.

Возможно, такой эффект связан с алгоритмами внимания, применяемыми внутри моделей, которые при сохранении строгой логики воспринимают даже небольшие несоответствия как сигнал для снижения уверенности или вызывают путаницу в процессе обработки длинных текста. Еще один важный аспект исследований — анализ постановки задач, когда длина выходного текста растет пропорционально длине входных данных, например, в тестах на повторение и точное копирование длинных последовательностей слов. Несмотря на относительную простоту задачи, модели показывают снижение точности с увеличением длины, а некоторые из них даже отказываются выполнять задание, ссылаясь на ограничения этического или правового характера. Такие явления подчеркивают актуальность обсуждения надежности крупных языковых моделей вне зависимости от длины и сложности задачи. Немаловажным элементом исследования является сравнительный анализ поведения разных архитектур и семейств моделей.

Например, модели Claude демонстрируют тенденцию к осторожному поведению: они часто предпочитают отказаться от ответа при недостаточной уверенности, что снижает риск ошибочных или вымышленных ответов (галлюцинаций). Напротив, представители GPT чаще генерируют уверенные, но порой неверные результаты, особенно в присутствии дистракторов и при увеличении контекста. Использование длинных контекстов уже давно стало трендом в индустрии ИИ. Однако результаты отчета подчеркивают, что простое увеличение объема обрабатываемого текста не гарантирует пропорционального повышения качества решений. Наоборот, многие современные задачи требуют продуманного подхода к «инженерии контекста» — грамотной организации, структурированию и подаче информации в модель.

Таким образом, важным становится не только сколько текста подается на вход, но и каким именно образом этот текст преподносится и как внутри него расположены ключевые данные. Перспективы будущих исследований тесно связаны с углубленным изучением внутренних механизмов работы моделей — их внимания, интерпретируемости и адаптации к структурным особенностям текста. Понимание таких процессов позволит создавать более устойчивые и надежные системы, способные эффективно работать с экстремально длинными контекстами без существенной потери качества. Для практиков и разработчиков ИИ важным выводом является необходимость создания сбалансированных и разнообразных тестов для оценки моделей. Множество широко используемых бенчмарков, в частности те, что ориентированы на лексическую проверку, не отражают реальную сложность задач, с которыми сталкиваются модели «в поле», и могут приводить к завышенным ожиданиям от моделей при работе с большими объемами информации.

В заключение можно сказать, что вызовы, связанные с контекстной ротацией и неудовлетворительной устойчивостью больших языковых моделей к увеличению длины входных данных, являются важной и актуальной проблемой. Ее решение будет определять, насколько эффективно и широко будут применяться такие системы в будущем — от поисковых систем и цифровых помощников до сложных аналитических задач и автоматизации творческих процессов. С учетом представленных данных и последних исследований, отрасли рекомендуется уделять повышенное внимание не только архитектурным новшествам, но и глубокой оптимизации способов подачи информации, управлению долгосрочной памятью моделей и разработке современных подходов к борьбе с дистракторной и нерелевантной информацией. Таким образом, будет обеспечена более высокая стабильность и точность работы ИИ в условиях растущего объема и сложности данных.