В современном цифровом мире искусственный интеллект занимает всё более значимое место в нашей повседневной жизни. Он помогает находить ответы, упрощает взаимодействие с технологиями и делает разнообразные процессы эффективнее. Однако, несмотря на очевидные преимущества, ИИ-продукты не лишены ошибок и уязвимостей. Одним из тревожных примеров является ситуация, когда популярные языковые модели, такие как ChatGPT, рекомендуют пользователям неправильные ссылки на официальные сайты крупных компаний. Это создаёт уникальную возможность для мошенников и фишеров использовать доверие пользователей к AI и перенаправлять на поддельные веб-ресурсы, создавая своего рода «фишинговый рай» в интернете.

Проблема неправильных URL, выдаваемых ИИ, не нова, но с ростом популярности языковых моделей её масштаб становится всё более заметным. Исследования компании Netcraft показали, что при запросах на поиск адресов входа в аккаунты популярных брендов ChatGPT и другие модели GPT-4.1 лишь в 66 процентах случаев дают корректный URL. Остальная часть ответов либо предлагает недействующие страницы, либо ссылки на другие, малоизвестные сайты, а около 5% приводят к совершенно посторонним ресурсам. Такая статистика говорит о серьёзных пробелах в понимании и «знаниях» ИИ о реальном состоянии веб-пространства.

Особую опасность представляет тот факт, что многие из неправильно указанных сайтов на момент запроса либо вовсе не зарегистрированы, либо принадлежат третьим лицам, в том числе потенциальным злоумышленникам. Фишеры и киберпреступники могут воспользоваться этими ошибками, регистрируя соответствующие домены и создавая на их основе фальшивые сайты, максимально приближённые по внешнему виду к официальным ресурсам брендов. Пользователи, доверяя рекомендациям искусственного интеллекта, переходят по этим ссылкам и становятся жертвами мошенничества, подвергая риску личные данные, финансовые средства и корпоративную безопасность.Такая смена тактики у злоумышленников связана с ростом популярности AI-чатботов в роли советчиков и помощников. Раньше основным каналом сбора жертв были поисковые системы, где борьба с фишингом и неправомерным SEO занимала значительное место.

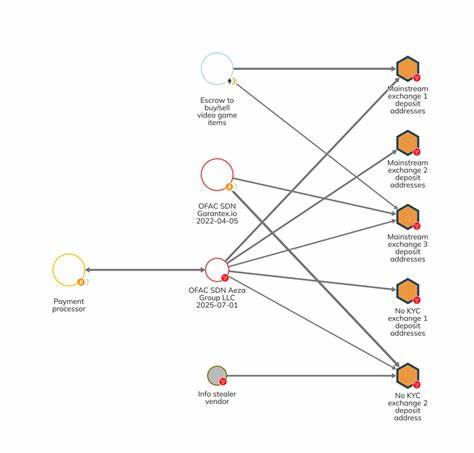

Теперь же преступники всё активнее начинают ориентироваться на рекомендации языковых моделей, которые по своей природе не анализируют репутацию сайтов, а опираются в основном на текстовые связи и частотность употребления ссылок в различных открытых данных. Словно небрежный гид, AI может порекомендовать опасный путь, даже не подозревая об этом.Одним из ярких примеров стал случай с запросом к ChatGPT о входе в банк Wells Fargo. В одном из тестов бот показал ссылку на хорошо оформленный поддельный сайт, который ранее уже использовался в фишинговых кампаниях. Это показывает, что AI-модель не только даёт ошибочные ответы, но и потенциально способствует распространению и усилению мошеннических действий.

Подобные сайты тщательно прорабатываются, чтобы обмануть даже самых внимательных пользователей, и рекомендация ИИ лишь облегчает задачу мошенникам.Особое место в этой цепочке занимает «отравление» данных. Злоумышленники создают большое количество фиктивных аккаунтов, репозиториев на GitHub, фальшивых обучающих материалов и социальных страниц, которые явно ориентированы на оптимизацию для языковых моделей. Например, на блокчейне Solana был выявлен случай, когда мошенники изготовили поддельный API, окружённый множеством ложных ссылок и документации, чтобы повысить вероятность того, что AI будет рекомендовать именно их ресурс. Таким образом создаётся долгосрочная система обмана, которая действует на уровне доверия к ИИ и пользователей, и разработчиков, и тех, кто ищет информацию.

Для конечного пользователя последствия таких ошибок могут быть катастрофическими. Случайный переход на фишинговый сайт может привести к краже паролей, финансовым потерям, утечке личных данных, а в корпоративном мире — компрометации безопасности всей системы. Многие пользователи даже не подозревают, что обращаясь к чатботу, они могут получить рекомендации, которые нельзя считать надёжными. Это ставит под сомнение полностью автоматизированные системы поиска информации и подчёркивает важность осторожности и проверки фактов.В свою очередь, разработчики и поставщики услуг на базе искусственного интеллекта должны внимательно относиться к вопросам безопасности.

Необходимо внедрять механизмы фильтрации и верификации информации о URL, учитывать репутацию сайтов и обновлять базы данных в реальном времени. Более того, следует просвещать пользователей о том, что AI — это инструмент, который не заменяет собственное критическое мышление и тщательно продуманную проверку источников.Есть и позитивные моменты: борьба с этой угрозой уже ведётся. Компании, занимающиеся кибербезопасностью, усиливают мониторинг подозрительных доменов, внедряют системы антиподделок и развивают технологии автоматического обнаружения фишинговых сайтов. В свою очередь, исследователи AI-фронта работают над улучшениями моделей, которые позволяют искусственному интеллекту не только распознавать словесные паттерны, но и анализировать надежность и безопасность веб-ресурсов.

В то же время пользователям стоит помнить, что лучшая защита — это бдительность. Не стоит безоглядно переходить по всем ссылкам, даже если их порекомендовал популярный AI-чатбот. Проверка адреса сайта в адресной строке, использование официальных приложения банков и сервисов, а также внимательность к деталям интерфейса позволят значительно снизить риски попасться на уловки мошенников.Также важным является обучение и повышение цифровой грамотности — как среди рядовых пользователей, так и среди IT-специалистов. Им нужно быть в курсе того, что рекомендации от современных ИИ моделей не всегда стопроцентно надежны и требуют дополнительной проверки.