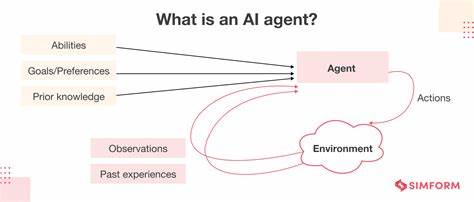

В последние годы искусственный интеллект (ИИ) прочно вошёл в повседневную жизнь, влияя на работу, общение и даже знакомства. Одна из популярных платформ для онлайн-знакомств, Bumble, внедрила функцию AI Icebreakers для упрощения начала общения. Эта опция использует искусственный интеллект на базе OpenAI ChatGPT, чтобы генерировать персонализированные сообщения для пользователей. Несмотря на удобство и инновационность, такая практика привлекла внимание европейских регуляторов и экспертов по защите данных, поскольку Bumble нарушает законодательство Европейского союза в области конфиденциальности, прежде всего общий регламент по защите данных (GDPR). История и суть проблемы Начало использования AI Icebreakers датируется декабрём 2023 года, когда функция была добавлена в раздел «Bumble for Friends», помогающий людям заводить новые знакомства без романтических побуждений.

В основе лежит технология обработки персональных данных пользователей — открытая API OpenAI получает доступ к сведениям из профиля каждого участника, чтобы на основании предоставленной информации создать приветственное сообщение от лица пользователя. При этом Bumble не получает явного согласия на такую обработку, а вместо этого демонстрирует баннер с предложением нажать кнопку «Окей». Такой подход придаёт видимость добровольного согласия, однако, как выяснилось, компания основывает свои действия не на соглаcии, а на юридической формулировке «легитимного интереса» (Article 6(1)(f) GDPR). Это вызывает критику, потому что крупнейшие европейские эксперты и организации по защите прав потребителей считают подобную практику нарушением фундаментальных требований закона. Проблемы с согласием и прозрачностью Согласно законом ЕС, любая обработка личных данных должна иметь законное основание, одно из которых — явное согласие пользователя на обработку конкретных данных.

Функция AI Icebreakers по сути затрагивает не просто базовые сведения, а зачастую чувствительные данные — например, сексуальную ориентацию, которая требует дополнительной защиты (Article 9 GDPR). Вместо полноценного и информированного согласия Bumble демонстрирует баннер, призванный практически навязать пользователю принять условия. Пользователи не имеют реальной возможности отказаться, поскольку уведомление появляется при каждом запуске приложения и отсутствует альтернатива пропустить или отложить согласие. Такая форма «подталкивания» (nudging) вызывает сомнения в добровольности и правомерности соглаcия. Эксперты из организации noyb (None of Your Business), специализирующейся на защите прав в интернете и GDPR, заявили, что Bumble создаёт у пользователей ложное ощущение контроля над своими данными.

По их мнению, компания нарушает статью 5(1)(a) GDPR, связанную с обязанностью обеспечивать прозрачность и добросовестность при обработке. Заявленные «легитимные интересы» не могут служить правовой основой для передачи персональных данных третьему лицу в целях AI-генерации текстов без надлежащего согласия. Жалоба и последствия События получили развитие в начале 2025 года, когда noyb подал официальную жалобу в австрийский орган по защите данных (DSB). Согласно жалобе, Bumble нарушил несколько норм регуляции: отсутствие прозрачной и полной информации о том, как именно и кому передаются персональные данные; использование незаконной правовой основы для обработки; недостаточный ответ на запросы пользователей о доступе к их личным сведениям (Article 15 GDPR). Жалоба акцентирует внимание на том, что данные пользователей, включая чувствительные категории, передаются исключительно на основе несанкционированного доступа OpenAI без законного согласия.

Это поднимает важнейший этический и правовой вопрос о балансе между инновациями в сфере ИИ и защитой базовых прав граждан Евросоюза. С объективной точки зрения, подобные нарушения могут привести к административным штрафам в значительном размере, ведь алгоритмы GDPR предполагают строгое соблюдение правил для компаний, работающих с личной информацией. Почему это важно для пользователей Онлайн-платформы знакомств и социальных сетей являются одними из наиболее уязвимых с точки зрения личной информационной безопасности. Люди делятся данными о своём образе жизни, личных предпочтениях, отношениях и даже информации, которую в «реальной» жизни предпочли бы скрывать. Получая такое количество данных, технологические компании обязаны строго соблюдать законы о защите данных, гарантируя пользователям контроль и понимание, как используются их сведения.

Нарушения правил GDPR, подобные тем, что наблюдаются в случае Bumble, могут привести к злоупотреблениям и компрометации конфиденциальности. Более того, это подрывает доверие к разработчикам ИИ и инновационным технологиям, ведь любой негативный опыт пересекает границы отдельных приложений и влияет на восприятие отрасли в целом. Регулирование ИИ и будущее защиты данных Внедрение искусственного интеллекта в повседневную жизнь ставит новые вызовы для законодательства. Европейский союз уже работает над расширением регулирующей базы, включая предложения по регулированию использования ИИ (AI Act), направленные на то, чтобы сделать технологии прозрачными, этичными и подотчётными. В то же время регуляторы придают особое значение тому, чтобы принципы GDPR оставались главное приоритетом, особенно когда речь идёт о данных, генерируемых и используемых в системах ИИ.

Случай с Bumble демонстрирует необходимость не только жёсткого контроля за соблюдением существующих правил, но и улучшения механизмов информирования пользователей и внедрения новых юридических конструкций, которые смогут адекватно отражать современные реальности цифрового мира. Разумеется, пользователи приложений «знакомств» должны иметь право понимать, на каких условиях их данные обрабатываются, иметь возможность отказаться и не беспокоиться о том, что их профиль «скрытый» или «чувствительный». Советы для пользователей Несмотря на растущий интерес к функциям искусственного интеллекта и их потенциальной пользе, важно проявлять осознанность в плане конфиденциальности. Во-первых, внимательно читать уведомления и условия использования приложений, даже если они кажутся повторяющимися или навязчивыми. Во-вторых, пользоваться возможностями контроля за данными — например, запрашивать копии своих данных или удалять профили, если возникают сомнения.