Google неуклонно развивается, продолжая внедрять инновации и адаптироваться к современным тенденциям цифрового рынка. Одним из последних заметных изменений стало экспериментальное ограничение количества результатов, которые отображаются на одной странице поиска. Многие пользователи и специалисты в области SEO уже заметили, что получить более 10 результатов за один запрос становится сложнее, несмотря на ранее существующую возможность выводить до 100 ссылок на одной странице. Эти изменения начинают влиять не только на рядовых пользователей, но и на профессионалов, для которых быстрый и масштабный анализ данных играет ключевую роль. Исторический контекст показывает, что до недавнего времени Google позволял использовать параметр num в своих API, который регулировал количество результатов на странице.

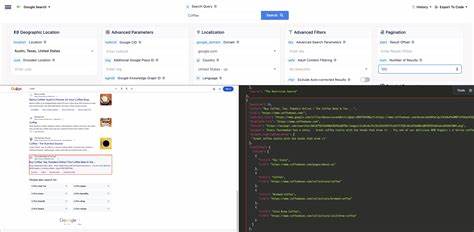

Стандартное число - 10 ссылок, но с помощью num можно было получить до 100 ссылок за один запрос, что значительно упрощало сбор и анализ информации. Однако с начала 2023 года инженеры и специалисты, работающие с Google Search API, отметили первые сбои и несоответствия, когда запросы с параметром num не всегда возвращали ожидаемое количество результатов. Ситуация особенно осложнилась в начале 2025 года, когда ограничение стало более агрессивным и устойчивым, а многие запросы начали игнорировать параметр num, возвращая стандартные 10 ссылок вне зависимости от заданных настроек. Технические специалисты компании SerpApi, занимающейся предоставлением возможностей для сбора и обработки данных из поиска Google, подтверждают эти наблюдения. Они провели многочисленные тесты и бенчмарки, которые показали, что в большинстве случаев невозможно получить сразу 100 результатов с помощью одного запроса.

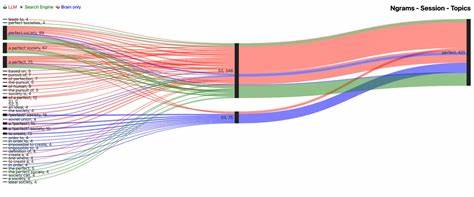

Хотя данные можно собрать, используя пагинацию - переход со страницы на страницу и последовательный сбор 10 результатов на каждом этапе, это создает дополнительные сложности и увеличивает стоимость работы с API. Для обычного пользователя эти изменения могут остаться незамеченными, так как большинство пользователей привыкли просматривать только первые несколько результатов поиска. Тем не менее, для специалистов по поисковой оптимизации (SEO) и разработчиков API перемены ощущаются остро. SEO-эксперты зависят от возможности быстро и масштабно анализировать поисковую выдачу, чтобы выявлять тренды, оценивать конкурентов и оптимизировать контент. Если количество доступных результатов ограничено, поиск становится менее эффективным и требует больше времени, что в конечном счете отражается на качестве работы.

Разработчики, использующие API Google в своих проектах для получения поисковых данных, сталкиваются с возросшими затратами. Раньше один запрос с параметром num, устанавливающим максимальное количество результатов, позволял получить обширный массив информации. Теперь же, чтобы собрать эквивалентный объем данных, приходится делать множество запросов с пагинацией, что увеличивает нагрузку на систему и стоимость обслуживания. С другой стороны, снижение числа возвращаемых результатов могло привести к уменьшению числа появляющихся CAPTCHA, что улучшает стабильность работы API и снижает частоту сбоев. Почему Google идет на этот шаг? Прежде всего, компания продолжает борьбу с автоматизированным сбором данных, или парсингом, который часто используется для создания несанкционированных копий контента и анализа поисковой выдачи с коммерческой целью.

Ограничение количества результатов на странице значительно усложняет жизнь скраперам и требует от них более сложных технических решений для обхода ограничений. Это помогает Google сохранять контроль над своими данными и защищать рекламные интересы, которые составляют основу бизнес-модели компании. Для SEO-специалистов и разработчиков этот тренд требует адаптации и поиска новых подходов. Одним из вариантов является активное использование легитимных инструментов Google, таких как Google Search Console, которая предоставляет подробные отчеты о позициях сайта и аналитике по запросам без необходимости парсить поисковую выдачу. Также стоит рассмотреть использование альтернативных источников данных и сервисов, которые собирают поисковую информацию с соблюдением правил и норм.

Важно не игнорировать эту тенденцию, поскольку подобное ограничение результатов может стать постоянной практикой. Обеспечение прозрачности, этичности и соответствия правилам Google становится ключевым для эффективного ведения SEO и разработки. Кроме того, это отличный повод для перехода на более качественные и менее затратные методы сбора информации. Можно ожидать, что Google продолжит развивать свои инструменты и возможно предложит новые API, которые позволят более удобно и законно получать доступ к поисковым данным в необходимом объёме. Важно оставаться в курсе изменений, следить за обновлениями в документации и подстраиваться под новые реалии рынка.

Нельзя забывать и о том, что сокращение объема данных на странице улучшает пользовательский опыт. Меньшее количество результатов облегчает восприятие информации и позволяет сосредоточиться на самых релевантных ссылках, что соответствует стратегии Google по максимальному удовлетворению потребностей своих пользователей. В заключение следует отметить, что эксперимент Google по ограничению результатов на странице - лишь один из шагов в борьбе с автоматизированным сбором данных и усилении контроля над выдачей. Этот ход требует пересмотра стратегий работы с поисковыми данными как для SEO-специалистов, так и для разработчиков API. Несмотря на вызовы, он открывает новые возможности для развития более эффективных и отвечающих актуальным требованиям инструментов и методов работы с информацией.

Постоянное наблюдение за изменениями и гибкая адаптация останутся ключевыми факторами успеха в этой динамичной среде. .