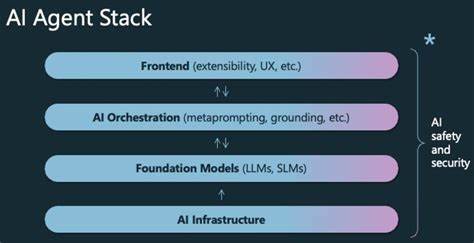

В последние годы искусственный интеллект (ИИ) и автоматизация кардинально изменили подходы к ведению бизнеса, оптимизации производственных процессов и созданию инновационных продуктов. Центральным элементом успешной реализации ИИ-решений становятся data pipelines — системы, обеспечивающие непрерывный поток данных от источников к аналитическим и машинно-обучающим моделям. Data pipelines для ИИ-агентов выступают в роли жизненно важного каркаса, поддерживающего интеллектуальную автоматизацию на всех этапах её функционирования. Одной из ключевых задач при построении data pipelines является обеспечение высокой скорости, надёжности и масштабируемости обработки данных. ИИ-агенты, в отличие от традиционных программ, требуют постоянного обновления информации в реальном времени или с минимальными задержками, чтобы принимать адекватные решения и адаптироваться к изменяющейся среде.

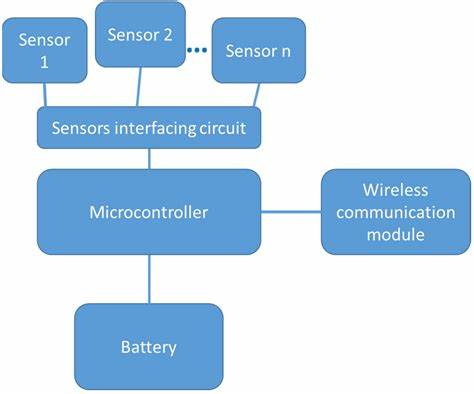

Неэффективные или устаревшие потоки данных могут привести к снижению качества прогнозов, ошибкам в распознавании образов или принятии неправильных решений. Проектирование таких систем начинается с тщательного анализа доступных источников информации. Это могут быть сенсоры IoT, базы данных, веб-сервисы, пользовательские взаимодействия или внешние API. Каждое из этих устройств или ресурсов генерирует большой объём структурированных и неструктурированных данных, которые необходимо корректно извлечь, очистить и привести к единому формату для дальнейшей обработки. Автоматизация данны́х процессов позволяет значительно уменьшить человеческий фактор, ускорить сбор информации и повысить общую эффективность работы ИИ.

Важной составляющей является интеграция технологий потоковой передачи данных, таких как Apache Kafka или Apache Pulsar, которые обеспечивают непрерывное и масштабируемое движение больших объемов данных в реальном времени. Использование подобных систем помогает добиться высокой отзывчивости и минимальных задержек, что критично для ИИ-агентов, работающих в режиме live-аналитики или принимающих решения в условиях динамичного окружения. Хранение данных также играет ключевую роль в построении data pipelines. В зависимости от специфики задачи и типа данных применяются различные решения: от реляционных баз данных до распределенных хранилищ данных и специализированных платформ для хранения больших данных. Эффективная организация кэширования, репликации и резервного копирования обеспечивает устойчивость системы и предотвращает потерю информации, что является важным аспектом для надёжной работы ИИ-систем.

Не менее важным направлением является обработка и трансформация данных. Перед подачей в машинно-обучающие модели данные проходят стадии очистки, нормализации, агрегирования и обогащения дополнительными метаданными. Применение современных библиотек и фреймворков для ETL-процессов (extract, transform, load) значительно упрощает создание таких мощных и гибких pipeline-систем. Это помогает обеспечить высокое качество данных и адаптивность моделей ИИ к различным входным форматам. Контроль качества и мониторинг pipeline-структур является ещё одним фундаментальным элементом успешной архитектуры интеллектуальной автоматизации.

Внедрение средств визуализации, логирования и оповещений позволяет своевременно выявлять узкие места, сбои или аномалии в обработке данных, минимизируя риски остановок или деградации работы ИИ-агентов. Регулярное тестирование и оптимизация процессов способствуют повышению общей эффективности и снижению операционных затрат. Кроме технических аспектов, важной частью создания data pipelines для ИИ-агентов является обеспечение безопасности и конфиденциальности данных. С ростом объемов информации и увеличением числа взаимодействующих компонентов, риск утечек или несанкционированного доступа возрастает. Использование шифрования, многоуровневой аутентификации, управление правами доступа и соответствие стандартам GDPR и другим нормативам становится обязательным условием при проектировании подобных систем.

Современные тенденции показывают, что для повышения гибкости и масштабируемости интеллектуальной автоматизации всё чаще внедряются облачные решения. Платформы AWS, Google Cloud или Microsoft Azure предоставляют мощные инструменты для построения, управления и масштабирования data pipelines с минимальными затратами на инфраструктуру. Облачная архитектура позволяет легко интегрировать новые источники данных, быстро реагировать на изменения в бизнес-процессах и использовать возможности машинного обучения без необходимости развертывания сложных локальных систем. Перспективы развития data pipelines для ИИ-агентов тесно связаны с концепциями edge computing и federated learning, которые позволяют обработку данных выполнять ближе к источнику их появления, уменьшая задержки и повышая приватность. Такое распределённое построение pipeline-систем открывает новые возможности в сфере автономных автомобилей, умных городов, медицины и других областях, где время реакции и безопасность имеют критическое значение.

В итоге, создание и поддержка качественно продуманных data pipelines является неотъемлемой частью успешной реализации ИИ-агентов и интеллектуальной автоматизации в целом. Эти системы обеспечивают непрерывное движение данных, высокую надёжность и оперативность обработки информации, что напрямую влияет на точность, эффективность и адаптивность моделей искусственного интеллекта. Организации, уделяющие должное внимание построению backbone своих data pipelines, получают конкурентное преимущество и возможность быстро внедрять инновации в сложных и динамичных условиях современного рынка.