В последние годы технологии трансформеров значительно изменили ландшафт машинного обучения и искусственного интеллекта, обеспечивая прорывы в обработке естественного языка, компьютерном зрении и других областях. Однако классические архитектуры с прямым распространением сигналов часто сталкиваются с ограничениями в масштабируемости и способности к комплексному мышлению, особенно при работе с разнообразными модальностями и сложными задачами. В этом контексте энергетические трансформеры (Energy-Based Transformers, EBTs) являются революционным решением, позволяющим преодолеть ряд ключевых препятствий и выйти на новый уровень эффективности и универсальности. Суть энергетических трансформеров заключается в принципе энергоориентированной модели, в которой каждому входному сигналу и возможному предсказанию сопоставляется энергетическая величина, отражающая степень их соответствия. Поиск оптимального предсказания рассматривается как задача минимизации энергии, осуществляемая итеративно с помощью методов градиентного спуска.

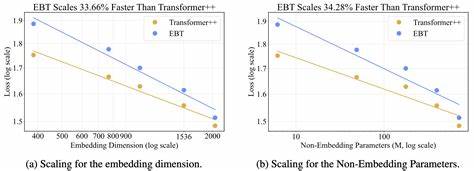

Такая концепция не только имитирует человеческое системное мышление второго уровня, позволяя модели «задумываться» над каждым шагом и проверять свои гипотезы, но и обеспечивает универсальность, поскольку не зависит от конкретного типа данных или направленности задачи. Одним из главных преимуществ энергетических трансформеров является их способность обрабатывать как дискретные (например, текстовые), так и непрерывные данные (например, изображения) с высокой эффективностью. По сравнению с традиционными улучшенными версиями трансформеров, EBTs демонстрируют более высокую скорость масштабирования по разнообразным параметрам, таким как объем данных, размер батча, количество параметров, вычислительные ресурсы и глубина модели. Это подтверждается эмпирическими результатами, где энергетические трансформеры обеспечивают до 35% более быстрый рост производительности при увеличении ресурсов. Особое значение имеет возможность системного мышления во время инференса – во время процесса предсказания модель может многократно пересматривать свои ответы, оптимизируя их по мере снижения энергопотенциала.

Это позволяет энергетическим трансформерам превосходить классические модели на задачах, требующих глубокого анализа, логических рассуждений и генерализации на данные, лежащие вне обучающего распределения. В языковом моделировании такая итеративная оптимизация способствует улучшению точности и последовательности генерации текста, что подтверждается приростом эффективности на 29% по сравнению с аналогами. В визуальных задачах EBTs также демонстрируют впечатляющие результаты. При обработке изображений, например при деноизации, энергетические трансформеры оказываются более ресурсосберегающими, используя на 99% меньше прямых проходов по сравнению с диффузионными трансформерами, сохраняя или улучшая качество выходных данных. Это свидетельствует о потенциале энергетически ориентированных моделей для комплексных задач, где традиционные методы требуют значительных вычислительных затрат.

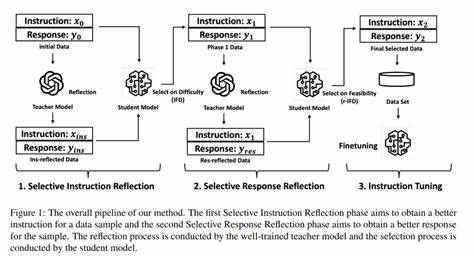

Еще одним важным аспектом является простота и универсальность обучения энергетических трансформеров. В отличие от многих современных методов системного мышления, требующих дополнительного обучения с использованием верифицируемых наград или специальных супервайзерных данных, EBTs обучаются полностью в режиме самообучения. Они учатся проверять совместимость входа и кандидата на предсказание без помощи внешних контролирующих сигналов, что существенно расширяет сферу их применения и упрощает внедрение в самые разные направления науки и техники. Энергетические трансформеры не только показывают высокие результаты по качеству предсказаний, но и обладают уникальной способностью улучшаться на данных, которые значительно отличаются от тех, на которых они обучались. Такая устойчивость к сдвигам распределения данных особенно важна для реальных приложений, где модели сталкиваются с постоянно меняющейся и непредсказуемой информацией.

Это открывает возможности создания надежных и адаптивных систем ИИ, способных работать в условиях повышенной неопределенности. Подводя итог, можно сказать, что энергетические трансформеры представляют собой яркий пример следующего поколения нейросетевых архитектур. Их инновационный подход к обучению и мышлению, основанный на минимизации энергии и итеративной проверке гипотез, позволяет не только масштабировать обучение до выдающихся показателей, но и внедрять мышление системного уровня в задачи любых модальностей без ограничений. Это дает надежду на развитие более интеллектуальных, универсальных и эффективных моделей искусственного интеллекта, способных решать сложные задачи в языковом, визуальном и других пространствах данных. Будущее энергетических трансформеров обещает быть захватывающим, с потенциалом влияния на самые разные отрасли, начиная от автоматизированного анализа текстов и изображений до разработки новых систем поддержки принятия решений и автономных интеллектуальных агентов.

Открытый доступ к исходному коду и активное сообщество разработчиков способны ускорить интеграцию и дальнейшее улучшение этой технологии, делая энергетические трансформеры одним из ключевых инструментов развития искусственного интеллекта в ближайшие годы.

![Saving energy with efficient code [video]](/images/1797BCD3-C8F0-48BA-B5B8-B2DAA083E767)