В мире технологий произошел очередной прорыв: генеральный директор OpenAI Сэм Альтман заявил о грядущем создании искусственного интеллекта, обладающего «суперинтеллектом». В своем последнем блоге Альтман отметил, что человечество находится на пороге «Эпохи интеллекта» и что создание ИИ с такими способностями может произойти всего через несколько тысяч дней. Это заявление стало настоящим разговором недели среди экспертов, ученых и бизнесменов. Что же подразумевает Альтман под «суперинтеллектом»? В его понимании это не просто повторение действий человека или выполнение заданий, а полноценная способность к самообучению и улучшению. Суперинтеллект, по его словам, будет обладать более высокими когнитивными способностями, чем любой человек, и сможет самостоятельно развиваться, анализируя и обрабатывая огромные объемы данных.

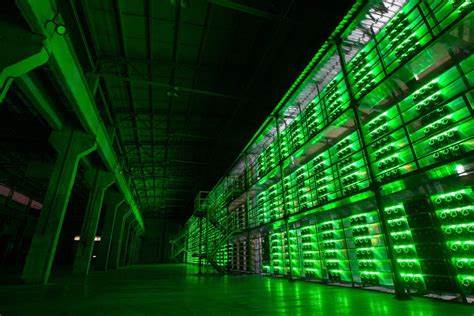

Альтман подчеркивает, что сейчас существует необходимость в значительных инвестициях в вычислительные мощности и инфраструктуру, чтобы сделать такие технологии доступными для большинства людей. «Если мы хотим предоставить ИИ как можно большему числу людей, нам нужно снизить стоимость вычислений и сделать их доступными», — пишет он в своем блоге. По его мнению, отсутствие достаточной инфраструктуры может привести к тому, что ИИ станет ограниченным ресурсом, который будут использовать только богатые. Глобальное развитие технологий всегда связано с опасностями и вызовами. Альтман отмечает, что «Эпоха интеллекта» принесет как положительные, так и отрицательные последствия.

Важной задачей является эффективное управление рисками, связанными с новым уровнем интеллекта, который может существенно изменить нашу жизнь, экономику и общество в целом. «Мы должны действовать мудро, но с убежденностью», — говорит он. «Управление вызовами, с которыми мы столкнемся, ключевое для нашего будущего». Тем временем множество стартапов реагируют на эти вызовы. Недавнее основание компании Safe Superintelligence, кофаундером которой стал бывший главный научный сотрудник OpenAI Илья Сутскевер, свидетельствует о растущем интересе к безопасному развитию ИИ.

Сутскевер и его партнеры собрали $1 миллиард на создание системы безопасного ИИ, ориентированной на длительные исследования и разработки. «Мы начали первую в мире лабораторию, нацеленную на создание безопасного суперинтеллекта», — заявили основатели. Такое внимание к безопасности технологий объясняется не только возможностями, которые они открывают, но и потенциальными угрозами. Продвижение суперинтеллекта несет в себе риски, о которых говорят многие эксперты. В своем недавнем письме бывшие и нынешние разработчики OpenAI выразили обеспокоенность по поводу недостатка регуляций и возможной гонки вооружений в сфере ИИ.

По мере того как компании и учёные погружаются в разработку ИИ более высокого уровня, это поднимает важные этические вопросы. Каковы границы использования таких технологий? Кто будет контролировать их использование и как предотвратить возможные misuses? По мере приближения к созданию суперинтеллекта необходимость в обсуждении этических норм и правил становится критически важной. Некоторые эксперты считают, что создание суперинтеллекта может привести к значительным изменениям в обществе. Экономика, трудовая занятость, образование — все эти сферы могут быть затронуты, и поэтому важно заранее обсудить возможные сценарии и стратегии адаптации. Мы живем в эпоху стремительных технологий, и чтобы не отстать, необходимо готовиться к преодолению изменений.

В заявлении Альтмана также поднимается вопрос доступности технологий. Важно, чтобы ИИ стал инструментом, доступным для всех, а не роскошью для избранных. «Если мы не сможем обеспечить доступность технологий, это может привести к конфликтации, а те, кто уже имеет доступ к этим инструментам, получат еще больше преимуществ», — предупреждает он. Одним из путей обеспечения безопасности и доступности технологий является развитие международного сотрудничества. Альтман подчеркивает: «Мы должны объединять усилия и делиться знаниями, чтобы обеспечить безопасность и надежность».

На фоне всех этих событий инвестиции в технологии ИИ продолжают расти. Традиционные венчурные капитальные фирмы, такие как Andreessen Horowitz и Sequoia Capital, активно финансируют стартапы, работающие над созданием безопасного суперинтеллекта, что подтверждает интерес к данному направлению. Некоторые критики утверждают, что такой быстрый прогресс в разработке ИИ может быть не только благом, но и источником нестабильности. Однако другие эксперты считают, что именно благодаря безопасному развитию ИИ человечество получит возможность решить многие из своих давних проблем, от изменения климата до медицинских исследований. В то время как мир IT-отрасли находится на грани новых открытий, мнение Альтмана о приближающейся «Эпохе интеллекта» напоминает всем нам, что вместе с прогрессом приходит и большая ответственность.

Необходимо заранее подготовиться к вызовам, чтобы лучше понять, как жить в мире, где ИИ играет ключевую роль. Так или иначе, будущее искусственного интеллекта остается более чем захватывающим. И хотя создание суперинтеллекта может быть всего лишь вопросом времени, пути его безопасной интеграции в жизнь человечества еще предстоит исследовать. В какой бы форме он ни появился, принять этот вызов — значит принять ответственность за наше будущее.