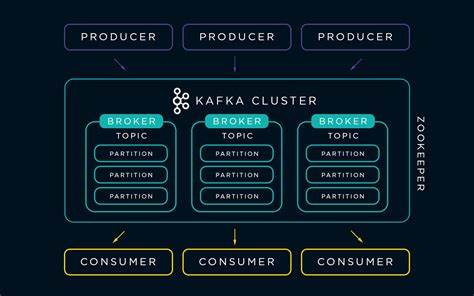

Kafka, как одна из самых популярных платформ для обработки и передачи стриминговых данных, за последние годы претерпела значительные изменения. Одним из самых заметных и долгожданных изменений стало избавление от зависимости от ZooKeeper, который долгое время был обязательным компонентом в кластерах Kafka. К 2025 году Kafka полностью отказалась от ZooKeeper, что значительно упрощает архитектуру и облегчает развертывание системы, особенно в контейнеризированных средах, таких как Docker. Данная трансформация открывает новые горизонты для разработчиков и инженеров, желающих быстро и эффективно работать с Kafka, минимизируя операционные сложности. Современные контейнерные решения позволяют легко и быстро создать локальное тестовое окружение или развёртывать полноценный кластер Kafka в облаке без лишних зависимостей.

Одним из популярных вариантов для запуска Kafka в контейнере является образ от Bitnami, который поддерживает актуальные версии Kafka и настроен с учётом всех современных требований. После отказа от ZooKeeper конфигурация существенно меняется — возникают новые параметры, обеспечивающие работу Kafka в режиме KRaft (Kafka Raft Metadata mode). Docker Compose файл, адаптированный для Kafka 4.0 и выше, теперь включает в себя параметры, которые задают роли узлов, слушатели и репликацию метаданных, что ранее было прерогативой ZooKeeper. Важно понимать, что современные сервисы Kafka требуют точного указания ролей узла — контроллер и брокер теперь могут присутствовать в одном экземпляре, что особенно удобно для локальной разработки и небольших проектов.

Благодаря такому подходу, разворачивание Kafka значительно упрощается: отсутствует необходимость запускать отдельный сервис ZooKeeper, что снижает потребление ресурсов и уменьшает количество компонентов для поддержки. Значение параметра KAFKA_CFG_NODE_ID стало обязательным, он служит уникальным идентификатором узла в кластере. Установка KAFKA_CFG_PROCESS_ROLES позволяет указать, будет ли узел выполнять функции контроллера, брокера или и того, и другого. Переход на новый режим требует также правильной настройки слушателей и объявления адресов для корректного взаимодействия внутри Docker-сети и с внешним окружением — для этого используются параметры KAFKA_CFG_LISTENERS, KAFKA_CFG_ADVERTISED_LISTENERS и KAFKA_CFG_LISTENER_SECURITY_PROTOCOL_MAP. Такой подход обеспечивает стабильное соединение как между контейнерами внутри сети Docker, так и с приложениями, запускаемыми на основной машине гостевой операционной системы.

Практически все современные примеры работы с Kafka внутри контейнеров теперь ориентируются на использование образа Bitnami, так как они оперативно обновляются и с учётом последних улучшений Kafka 4.0+. Это особенно актуально после прекращения поддержки популярного, но теперь устаревшего образа wurstmeister, который долгое время являлся стандартом для запуска Kafka в Docker. Одним из ключевых преимуществ использования Bitnami-образа является возможность быстро запускать и инициализировать Kafka топики через отдельный контейнер, который зависит от основного сервиса. Данный контейнер запускает скрипты, которые ждут готовности Kafka и создают необходимые темы без излишних ручных действий, что ускоряет процесс тестирования и обучения.

Важной особенностью новой конфигурации является возможность использования KAFKA_OFFSETS_TOPIC_REPLICATION_FACTOR с значением 1, что облегчает создание топиков во время локальной разработки без необходимости настройки репликации и высокодоступных кластеров. Это существенно снижает порог входа, особенно для начинающих специалистов и небольших команд. Необходимо обратить внимание на изменение утилит для взаимодействия с Kafka. Классический kafka-console-producer и kafka-console-consumer остаются актуальными, но вместо устаревшего kafkacat теперь используется kcat, новая утилита с улучшенной функциональностью и лучшей совместимостью с современными версиями Kafka. Установить kcat на системах Linux, например на Arch Linux, можно через официальные пакеты, что упрощает интеграцию с CI/CD процессами и локальной разработкой.

Эксплуатация Kafka без ZooKeeper в Docker Compose значительно упрощает построение и поддержку инфраструктуры. Это важно для команд, ориентированных на быструю итерацию и Agile-методы, где скорость развертывания и гибкость важнее избыточной надежности на ранних этапах. Более того, отказ от ZooKeeper снижает потенциальные риски сбоев, связанные с отдельным сервисом, который традиционно был источником проблем и сложностей при масштабировании Kafka. К тому же, новая архитектура Kafka предусматривает встроенное согласование и управление метаданными через протокол Raft, что повышает общую надежность и упрощает администрирование. Современный Docker Compose шаблон для Kafka на 2025 год с использованием Bitnami-образа демонстрирует, как буквально за пару минут можно иметь полностью работоспособный Kafka брокер, готовый к использованию как в локальной среде, так и на стадии первоначального тестирования облачных решений.

Важно понимать, что этот подход ориентирован на разработки и тесты, и для промышленной эксплуатации все еще рекомендуется внимательно проектировать многозадачные кластеры с учетом требований к отказоустойчивости и безопасности. Однако, для обучения, прототипирования и небольших проектов новая конфигурация значительно упрощает жизнь и устраняет многие технические барьеры. Советы для успешного развертывания Kafka 4.0+ в Docker включают точное соблюдение параметров окружения, внимательное отслеживание версий образа Bitnami и использование некоторых новых параметров, таких как KAFKA_CFG_CONTROLLER_QUORUM_VOTERS и KAFKA_CFG_CONTROLLER_LISTENER_NAMES, которые определяют состав контроллеров в новой архитектуре. Такие возможности ранее отсутствовали и теперь служат основой для управления кворумом контроллеров, что позволяет добиться согласованности кластера без необходимости в сторонних сервисах.

Хорошей практикой является также использование переменной ALLOW_PLAINTEXT_LISTENER=yes в локальном окружении, что позволяет упростить коммуникацию без настройки TLS, но для продакшена рекомендуется настроить более надежные протоколы шифрования и аутентификации. Ключевым итогом эволюции Kafka к 2025 году является упрощение развёртывания и поддержания кластера, а также отказ от дополнительного зависимого компонента ZooKeeper. Это снижает порог вхождения для новых пользователей, снижает стоимость эксплуатации и opensource сообщество получает более гибкий и адаптируемый инструмент streaming данных. В условиях растущей важности обработки больших данных и реального времени, такие улучшения делают Kafka ещё более привлекательным выбором для проектов любой сложности. В итоге, переход к «без-ZooKeeper» эпохе в Kafka является значительным шагом вперёд, который уже сегодня позволяет инженерам создавать эффективные, лёгкие в поддержке решения с помощью доступных и понятных инструментов, таких как Docker и Bitnami.

С учетом постоянно меняющегося ландшафта технологий важно следить за обновлениями и использовать современные best practices, чтобы добиться максимальной производительности и стабильности. Kafka 2025 демонстрирует, как технологии могут развиваться, упрощая опыт пользователя, сохраняя при этом высокие стандарты надежности и масштабируемости. Выстраивание DevOps процессов вокруг новых возможностей Kafka позволит командам сосредоточиться на бизнес-логике и аналитике данных, не отвлекаясь на инфраструктурные сложности.