Современные большие языковые модели, такие как GPT-4 и другие передовые искусственные интеллекты, способны генерировать программный код на множестве языков программирования. Многие пользователи и разработчики восхищаются возможностью получать готовые скрипты, функции и фрагменты кода буквально за секунды. Однако несмотря на такую функциональность и заявления некоторых компаний о поддержке инструментов с выполнением кода, зачастую пользователи сталкиваются с тем, что код генерируется только как текст, без предварительного запуска или проверки его работоспособности. Это вызывает множество вопросов: почему LLM не запускают сгенерированные скрипты заранее, не проверяют их правильность и не исправляют ошибки? Для того чтобы понять причины, нужно рассмотреть целый комплекс технических, организационных и этических аспектов, связанных с интеграцией исполнения кода в языковые модели. Во-первых, стоит отметить, что генерация кода и его исполнение – это кардинально разные процессы.

Языковая модель, по сути, является мощным генеративным алгоритмом, который предсказывает следующий символ или токен на основе обучающих данных и контекста запроса. Модель не обладает встроенным «пониманием» логики или результата работы программы, она лишь имитирует структуру и семантику кода, извлекая закономерности из большого количества исходников. Тогда как выполнение кода требует полноценного интерпретатора или компилятора, выделенной среды и ресурсов компьютера для запуска. Это не только добавляет слой сложности, но и накладывает ряд ограничений с точки зрения безопасности и затрат ресурсов. Говоря о безопасности, запуск произвольного сгенерированного кода сопряжён с значительными рисками.

К примеру, даже небольшая функциональная ошибка в коде или потенциально вредоносный скрипт могут привести к повреждению данных, утечке конфиденциальной информации или нарушению работы сервисов. Чтобы снизить эти риски, исполнение кода должно происходить в строго изолированной, надёжной песочнице (sandbox) с ограниченными правами доступа и ресурсами. Создание такой среды требует дополнительного времени и вычислительных мощностей, что не всегда согласуется с требованием быстрого ответа на запрос пользователя. Более того, для многих пользователей и задач запуск кода заранее вовсе не является однозначно полезным: во многих случаях сгенерированный фрагмент является лишь частью большего проекта, требующего интеграции с существующим кодом и средой, и только пользователь может протестировать совместимость и корректность. Кроме того, необходимо учитывать, что многие запросы к LLM связаны со специфическими задачами, разработкой небольших функций или изменений в коде, которые зависят от специфики окружения, библиотек и данных пользователя.

Универсальный запуск и тестирование такого кода на стороне разработчиков модели практически невозможен без точного копирования пользовательской среды, что в реальности сложно или невозможно. Соответственно, запуск кода вне контекста пользователя может выявить лишь синтаксические ошибки, но не логические баги или проблемы совместимости. Ещё одним важным фактором является стоимость вычислений. Исполнение кода требует дополнительного вычислительного времени и ресурсов, которые увеличивают эксплуатационные расходы. В то время как работа с языковой моделью уже сама по себе ресурсоёмкая, особенно при использовании графических процессоров для обработки запросов, интеграция процесса запуска и отладки кода добавляет нагрузку на инфраструктуру сервисов, повышая затраты поставщиков.

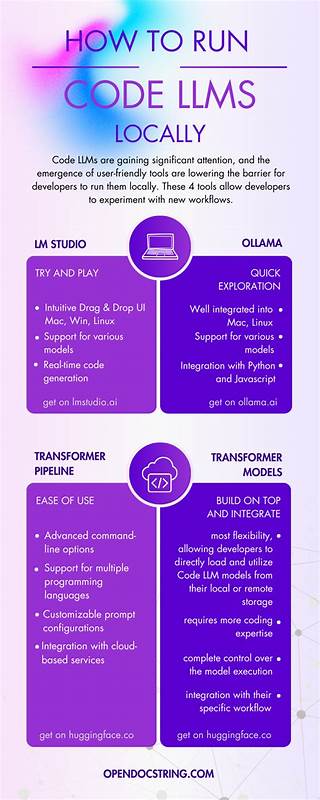

Это особенно ощутимо при масштабных вызовах, когда поток пользователей растёт в геометрической прогрессии. С технологической и методологической стороны появление инструментов, способных выполнять код, активно развивается. Некоторые современные среды и API уже предлагают возможность запуска скриптов внутри песочниц или с помощью различных сервисов. Но такое исполнение часто носит вспомогательный характер и требует управления с нашей стороны. Вопрос в том, как грамотно интегрировать эти возможности непосредственно в процесс генерации текста машиной, чтобы пользователь получал не только код, но и проверенный результат без задержек и с гарантией безопасности.

Пользователи часто ожидают от LLM мгновенного предоставления готового, правильно работающего скрипта, однако это ожидание редко совпадает с реальными техническими возможностями в данном направлении. Отчасти это связано с тем, что языковые модели, несмотря на свою мощь, остаются помощниками, а не «автоматическими программистами» во всех смыслах. Они способны создавать исходный материал для работы, но конечная ответственность за интеграцию, тестирование и исправление кода лежит на человеке. Интересно поднять вопрос и об этических рамках, связанных с автоматическим запуском кода. Представьте, что пользователь вводит запрос с кодом, который может причинить вред инфраструктуре, или содержит цитаты библиотек с лицензиями, запрещающими автоматическое распространение без исполнения.

Полная автоматизация исполнения вызывает дополнительные юридические и этические вопросы, которые компании пока не готовы решать в полном объёме. Разработчики и исследователи в области ИИ продолжают искать баланс между максимально полезными функциями, безопасностью и экономической выгодой. Одним из направлений является создание гибридных систем, где LLM генерируют код, а специализированные сервера проводят его исполнение и возвращают результат, снижая при этом риски за счёт продвинутой песочницы и ограничений на права доступа. Однако многие из таких инициатив остаются в стадии экспериментов или ограниченных тестирований. Наконец, стоит отметить, что для многих профессиональных разработчиков подход, при котором они получают текст кода от модели и затем самостоятельно тестируют и интегрируют его в проект, остаётся наиболее практичным.

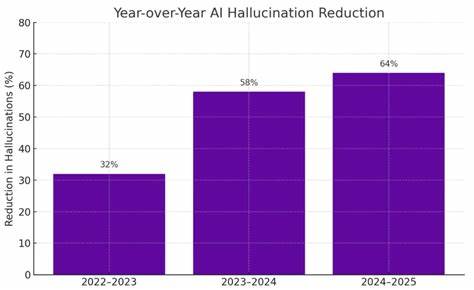

Такой рабочий процесс позволяет не полагаться на автоматическое исполнение, сохраняя контроль и гибкость. В то же время с развитием технологий в будущем возможно появление более продвинутых систем, способных не только писать, но и эффективно тестировать код в режиме реального времени, учитывая особенности пользовательской среды. Подводя итог, можно сказать, что отсутствие выполнения кода перед выдачей в современных больших языковых моделях связано с комплексом причин: технические ограничения, необходимость обеспечения безопасности, высокая стоимость ресурсов, сложность воспроизведения пользовательской среды, а также этические и юридические риски. Однако развитие этой сферы продолжается, и можно ожидать, что в будущем появятся инструменты и методологии, позволяющие сделать процесс генерации, запуска и отладки кода более интегрированным, автоматизированным и удобным для конечного пользователя.

![Karpathy vs. McKinsey: The Truth About AI Agents (Software 3.0) [video]](/images/F68D3459-FD23-4F61-A2CA-6268B8E9AF6E)