В последние годы искусственный интеллект (ИИ) сделал огромный шаг вперёд, особенно в области генеративных моделей, способных создавать текст, изображения и другие формы контента. Однако одной из главных проблем остаётся явление, известное как «галлюцинации» ИИ — когда модели выдают фактически неверную, вымышленную или неожиданно искаженную информацию. Несмотря на значительные успехи, такие ситуации вызывают тревогу и вопросы о надежности и безопасности использования ИИ в масштабах повседневной жизни и бизнеса. Тем не менее, ведущие эксперты в сфере ИИ отмечают: проблема галлюцинаций будет решена в ближайший год, уже в 2024 году. Причём это станет важным этапом в развитии искусственного интеллекта, но не обязательно однозначно хорошим.

Раза Хабиб, сооснователь и генеральный директор компании Humanloop, которая специализируется на оптимизации обучения языковых моделей, утверждает, что феномен галлюцинаций — это проблема, с которой системы ИИ уже справляются и которая «очевидно разрешима». Его опыт работы в Google AI и знания, полученные при разработке и доработке моделей вроде ChatGPT, позволяют ему делать достаточно уверенные прогнозы. Говоря на панельной сессии конференции Fortune Brainstorm AI в Лондоне, Хабиб отметил, что у моделей ИИ есть встроенное чувство уверенности в собственных ответах, которое до обучения с учётом предпочтений человека проявляется достаточно чётко. Однако именно после этапа дообучения модели теряют эту калибровку, что и ведёт к частым ошибкам и галлюцинациям. Процесс обучения крупных языковых моделей состоит из нескольких этапов — предобучения на огромных корпусах данных, последующей тонкой настройки и, наконец, обучения с подкреплением с использованием обратной связи от людей.

Проблема, по словам Хабиба, заключается именно во втором и третьем этапах, когда изначальная калибровка достоверности информации нарушается. Основная задача учёных и разработчиков сегодня — сохранять и развивать у моделей способность точно и верно оценивать свои ответы, особенно при попытке сделать их более управляемыми и адаптивными к запросам пользователей. Тем не менее, несмотря на оптимизм по поводу скорого устранения галлюцинаций, сам эксперт считает, что полного избавления от этого явления не обязательно стоит добиваться во всех случаях. Современные технологии привыкли работать в режиме, допускающем определённое количество ошибок, и люди при этом учатся работать с этими ограничениями. Примером служит привычный электронный поиск информации в Интернете, где алгоритмы подбирают ссылки, а не даю прямой ответ, что позволяет пользователям сверять и оценивать данные самостоятельно.

Так же происходит и в некоторых новых сервисах, например, в Perplexity AI, которые возвращают не просто ответ, а подтверждения и ссылки на источники. Другая важная сторона — творчество и генерация новых идей. Легкая галлюцинация или способность предлагать «странные и новаторские» гипотезы крайне важна, если мы хотим, чтобы ИИ помогал человечеству выходить за рамки устоявшихся знаний и создавать новые концепции. Для этого модель должна уметь оперировать не только жесткими фактами, но и предположениями, которые впоследствии можно проверить и уточнить. Хабиб подчеркивает, что во многих творческих задачах именно такие «выдумки» и акт гибкого мышления становятся залогом прогресса.

Случай с авиакомпанией Air Canada наглядно демонстрирует, насколько опасно использовать ИИ без должной подготовки и контроля. Когда чатбот компании ввёл клиента в заблуждение относительно возможности возврата билета по льготному тарифу, это вызвало целый скандал и судебные последствия. Эксперты отметили, что компания не внедрила необходимые защитные механизмы и «даже позволила боту говорить слишком многое». Этот инцидент стал уроком: технологии ИИ требуют тщательного тестирования и выявления рисков до использования их с реальными людьми и серьёзными финансовыми обязательствами. В то же время важно подчеркнуть, что развитие систем ИИ продолжается быстрыми темпами.

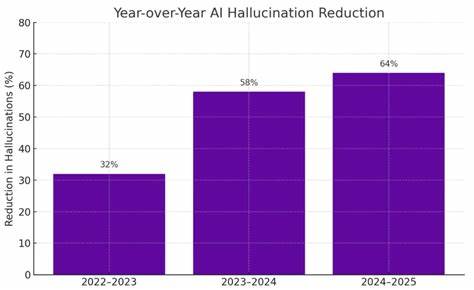

Множество компаний и исследовательских групп сейчас сосредоточены на улучшении калибровки моделей, адекватности их ответов и безопасности. Появляются методы, которые позволяют судить о том, насколько модель уверена в своём ответе и отбраковывать те варианты, которые с высокой вероятностью не соответствуют действительности. Это пагинация и фильтрация генерируемого контента, а также включение вспомогательных систем проверки и источников информации. При этом 2024 год станет поворотным моментом, когда мы увидим резкое уменьшение частоты и серьёзности галлюцинаций. Но вместе с этим перед исследователями появится новая задача — как сохранить гибкость и изобретательность ИИ, не превращая его в сухой и ограниченный набор фактов.

Выработать баланс между достижением безошибочности и сохранением способности к генерированию креативного контента станет приоритетом. Итогом станет появление моделей, которые будут более функциональными, надежными и полезными в самых разных сферах — от медицины и юриспруденции до творчества и научных исследований. Пользователи смогут получать точную и достоверную информацию с возможностью углублённого диалога и объяснений, что укрепит доверие к искусственному интеллекту. В то же время модели смогут выступать катализатором инноваций, предлагая свежие идеи и решения сложных проблем. Таким образом, ожидаемое решение проблемы AI-гулюцинаций к концу 2024 года — это не просто технологический прорыв, а новый этап в интеграции искусственного интеллекта в человеческое общество.

От того, насколько грамотно будет реализован этот переход, зависит дальнейшее развитие ИИ как инструмента, помогающего раскрыть потенциал человечества на качественно новом уровне.

![Karpathy vs. McKinsey: The Truth About AI Agents (Software 3.0) [video]](/images/F68D3459-FD23-4F61-A2CA-6268B8E9AF6E)