Децентрализованные финансы (DeFi) продолжают трансформировать финансовую индустрию, делая рынок более доступным, прозрачным и демократичным. В последние годы на горизонте появились новые технологии, способные еще более ускорить развитие DeFi-протоколов - это интеграция искусственного интеллекта (ИИ). Однако, с появлением DeFi, поддерживаемого интеллектуальными алгоритмами, возникают новые вызовы в области безопасности, требующие повышенного внимания и внедрения прозрачных механизмов аудита и контроля. Эволюция DeFi наступила благодаря внедрению таких инноваций, как децентрализованные обмены (DEX), платформы кредитования и заемов, а также стабильные монеты, функционирующие на блокчейне. Все это способствовало созданию экосистемы, где пользователи получают непосредственный контроль над своими активами без посредников.

Однако традиционные смарт-контракты работали по прозрачным и предсказуемым логикам с четкими правилами выполнения: если случается определенное событие, то выполняется заранее оговоренное действие. Это упрощало аудит и сделало взаимодействие на блокчейне детерминированным. С появлением DeFAI, то есть DeFi с элементами искусственного интеллекта, ситуация меняется кардинально. Теперь на первый план выходят агенты ИИ - программные боты, способные самостоятельно анализировать большие объемы данных, принимать решения на основе вероятностных моделей и динамично адаптироваться под изменяющиеся условия рынка. Использование таких ИИ-агентов открывает новые горизонты: торговля становится более эффективной, управление рисками - проактивным, а участие в управлении протоколами - автоматизированным и интеллектуальным.

Тем не менее, привнесение ИИ в децентрализованные экосистемы обладает не только преимуществами, но и создает новые уязвимости. В отличие от простых смарт-контрактов с прозрачной логикой, ИИ-модели зачастую функционируют как "черные ящики". Даже разработчики не всегда точно знают, как программа принимает конкретное решение - что повышает риски возникновения ошибок и потенциальных эксплойтов. Такой уровень неопределенности открывает побочные пути для злоумышленников, способных применять методы манипуляции, например, подмену входных данных или атаки с помощью вредоносных образцов данных (data poisoning). Рассмотрим на примере AI-агента, обученного выявлять возможности арбитража между разными децентрализованными биржами (DEX).

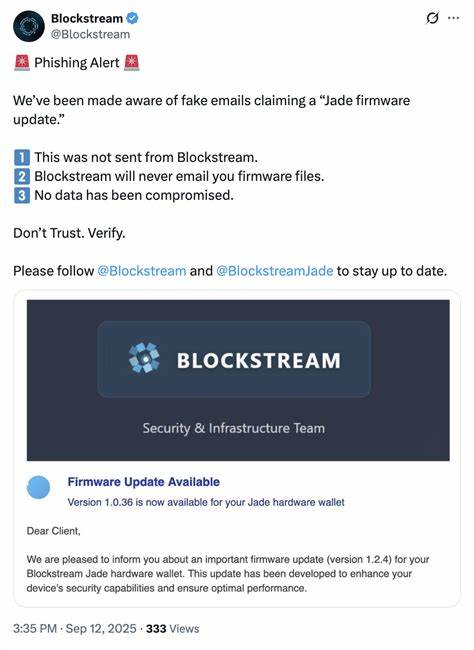

Теоретически такой бот способен быстро находить ценовые различия и заключать выгодные сделки. Однако, если злоумышленник сможет вмешаться в входные данные, бот может начать совершать убыточные операции или даже вывести ликвидность из пула, что ставит под угрозу весь протокол. Подобные ситуации ведут к серьёзным потерям для инвесторов и снижают доверие к DeFAI как инновационной модели. Кроме того, инфраструктура многих ИИ-ботов в DeFi пока еще зависит от Web2-технологий, что подразумевает наличие централизованных элементов. Это противоречит основному принципу Web3 - децентрализации и устойчивости, минимизирующей единую точку отказа.

Тем самым интеграция ИИ вынуждает индустрию заново формулировать подходы к безопасности, которые учитывали бы новые векторы угроз и особенности прозрачности принятия решений. Безопасность в DeFi всегда была коллективной ответственностью, и с появлением DeFAI важно акцентировать эту мысль еще сильнее. Остановить развитие DeFAI из-за опасений по безопасности не представляется разумным решением, так как потенциальные выгоды от синергии искусственного интеллекта и децентрализованных финансов слишком значимы. Вместо этого задача индустрии - адаптировать существующие и разрабатывать новые стандарты безопасности, позволяющие выявлять и устранять уязвимости на ранних этапах. Это требует комплексного подхода: тщательного аудита кода ИИ-агентов, проведения стресс-тестов и моделирования кризисных сценариев.

Ред-команды, занимающиеся поиском слабых мест в системах, должны вовлекаться в тестирование DeFAI-протоколов для выявления потенциальных уязвимостей до того, как их смогут использовать злоумышленники. Увеличение прозрачности также является ключевым элементом - открытое исходное программное обеспечение, подробная документация и стандартизированные методы отчётности позволят повысить доверие пользователей и разработчиков. Важнейшим аспектом, который начинает выходить на первый план, становится не просто проверка логики кода, но и проверка намерений искусственного интеллекта. Поскольку ИИ-агенты в будущем будут не только управлять активами, но и принимать решения в области голосования и участия в управлении протоколами, крайне важно, чтобы цели и действия таких агентов соответствовали как краткосрочным, так и долгосрочным интересам сообщества. Для решения этих задач отрасли необходимы междисциплинарные технологии.

Криптографические методы, такие как доказательства с нулевым разглашением (zero-knowledge proofs), способны подтвердить корректность и честность работы AI-агентов без раскрытия конфиденциальных данных. Активное развитие onchain-аттестационных фреймворков позволит создать прозрачный след происхождения и истории решений, таким образом усиливая ответственность и контроль. Кроме того, сама индустрия должна начать внедрять инструменты на основе искусственного интеллекта для проведения аудитов и обзор кода. Такой подход позволит автоматизировать и масштабировать проверку, делая процессы эффективнее и надежнее. Пока что таких готовых решений недостаточно, но опыт и исследования в данной области активно растут.

Учитывая, что DeFAI только начинает развиваться, а скорости инноваций зачастую опережают развитие систем безопасности, очень важно, чтобы все новые проекты в сфере DeFi внимательно отнеслись к вопросам аудита и прозрачности. Пользователи и инвесторы, в свою очередь, должны выбирать протоколы, демонстрирующие высокий уровень раскрытия информации и подтвержденную безопасность AI-компонентов. В конечном счете, DeFAI сам по себе не является опасным направлением, однако требует фундаментально нового взгляда на безопасность. Каждый фрагмент AI-логики - это строка кода, и каждая строка кода может содержать уязвимости. Без должного внимания и прозрачности риски эксплойтов будут только нарастать, что может свести на нет все преимущества децентрализованных финансов.

Создание и внедрение прозрачных и строгих стандартов безопасности - это не вызов лишь для программистов, но задача всего сообщества. Разработчики, пользователи, исследователи и регуляторы должны совместно способствовать формированию новых правил и инструментов, обеспечивающих доверие к DeFi и AI в их совокупности. Таким образом, следующий этап эволюции финансов свяжет воедино децентрализованные системы и искусственный интеллект. Чтобы этот симбиоз принес настоящие плоды и не стал источником новых угроз, индустрия должна ставить в приоритет прозрачность и надежность. Только так можно сохранить дух децентрализации - свободу, равенство и безопасность - в условиях быстро меняющейся технологической реальности.

.