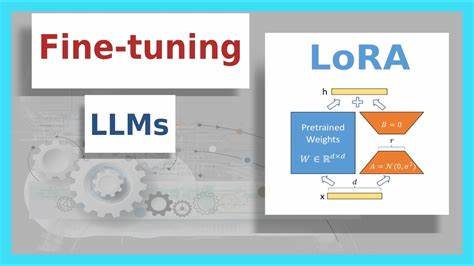

В последние годы область разработки и совершенствования больших языковых моделей стремительно развивается. Большие модели, такие как GPT, LLaMA и другие, оказались крайне эффективными в различных задачах обработки естественного языка. Однако их масштабность приводит к высоким затратам на дообучение и развертывание. Чтобы оптимизировать этот процесс, исследователи активно создают методы, позволяющие тонко настраивать модели с помощью сокращенных параметрических изменений. Одним из таких методов является Low-Rank Adaptation, известный как LoRA.

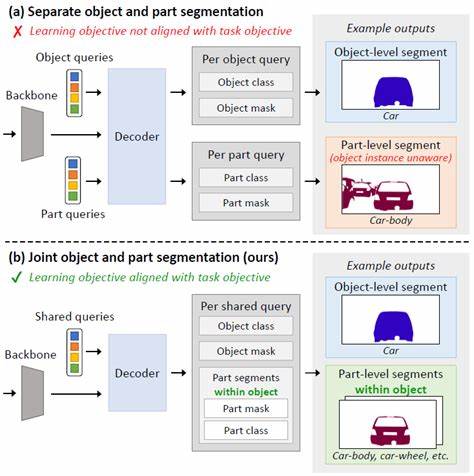

LoRA позволяет добавлять небольшие изменения в веса модели, значительно снижая количество параметров, нуждающихся в дообучении и тем самым уменьшая ресурсы. Тем не менее одна из сложностей заключается в том, что классический подход LoRA дообучает модель целиком, не учитывая, что разные слои и части трансформера оказывают неодинаковое влияние на конечный результат. Для решения этой задачи появился новый метод, известный как целенаправленное дообучение LoRA (Targeted LoRA finetuning), который обеспечивает более точную и избирательную адаптацию модели, повышая ее эффективность и качество. Этот метод основан на тщательном анализе вклада отдельных слоев и параметров в итоговое поведение модели. Базируясь на вычислении метрик согласования (alignment metrics) на различных наборах данных, исследователи могут выявить, какие слои трансформера имеют важнейшее значение для исполнения конкретных заданий.

После этого LoRA-преобразования вводятся именно в эти критические области, что позволяет избежать излишних вычислительных затрат в незначимых частях модели. Благодаря целенаправленному подходу сокращается количество обновляемых параметров, что, в свою очередь, ускоряет дообучение и снижает необходимость в больших вычислительных мощностях. Кроме того, такой метод снижает риск переобучения и может улучшить обобщающую способность модели за счет концентрации на нужных аспектах. Эффективность целенаправленного LoRA была продемонстрирована на множестве тестовых наборов, включая математические задачи, кодогенерацию, исторические тексты и логические рассуждения. Использование различных стратегий агрегации результатов – по типу, по слою или без агрегации – позволяет достичь гибкости в анализе и применении данного подхода.

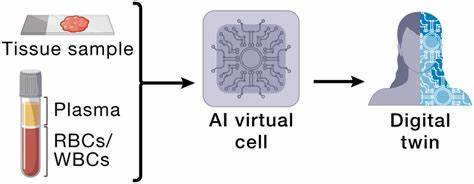

Для практического внедрения данного метода становится доступен набор инструментов и скриптов, облегчающих вычисление необходимых показателей и управление процессом адаптации модели. В частности, программный пакет «PLoP» (Precise LoRA Placement) обеспечивает простую установку и реализацию целенаправленного дообучения на крупных преобразовательных моделях, таких как LLaMA и аналогичных. Его использование требует минимальной настройки: достаточно указать модель, набор данных, количество образцов, длину последовательностей и выбрать способ агрегации результатов. Итоговые метрики сохраняются в удобном формате для последующего анализа и визуализации. С точки зрения бизнеса и разработок, целенаправленный LoRA открывает возможности для более экономного и точного внедрения больших языковых моделей в продуктах и сервисах.

Возможность тонкой настройки без полного переобучения всего набора параметров снижает издержки и позволяет удерживать высокое качество продуктов. Помимо этого, данная методика способствует более быстрому получению релевантных результатов, что особенно важно в областях с ограниченными вычислительными ресурсами или требованиями к скорости отклика систем. Тенденции развития искусственного интеллекта указывают на постоянный рост размеров моделей и усложнение архитектур. Поэтому именно методики, обеспечивающие эффективное распределение и сокращение объема дообучения, будут востребованы все больше. Целенаправленное LoRA финиширует как один из ключевых инструментов для адаптации лучших современных языковых моделей без чрезмерных затрат ресурсов.