GitHub Copilot уже давно стал незаменимым помощником для многих программистов, значительно ускоряя процесс написания кода и предлагая интеллектуальные автодополнения. Однако возможности этой платформы становятся по-настоящему впечатляющими, когда она работает в агентском режиме, позволяя вызывать дополнительные инструменты и функции с помощью специально обученных языковых моделей. Но что делать, если хочется использовать внешние модели, предоставляемые через OpenRouter, и при этом сохранить полноценную функциональность Copilot в агентском режиме? Ответом является создание локального 3-ступенчатого прокси, который обеспечивает обратную совместимость и разностороннюю интеграцию. В этом развернутом материале мы подробно рассмотрим, почему стандартный OpenRouter не подходит напрямую для Agent Mode, как именно работает прокси через copilot-ollama, и как шаг за шагом настроить такую систему для комфортной и эффективной работы. OpenRouter предлагает удобный интерфейс доступа к широкому спектру AI-моделей от различных провайдеров, таких как OpenAI, Anthropic, и другие.

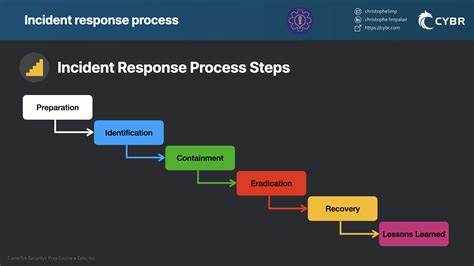

Это дает разработчикам множество вариантов выбора моделей с разными возможностями и производительностью. Однако существует одна проблема — API OpenRouter обычно не поддерживает анонсирование функций с вызовом инструментов, которые необходимы Agent Mode Copilot для корректной работы. Именно поэтому использовать популярные модели вроде Claude от Anthropic или GPT-4 напрямую через OpenRouter в агентском режиме нельзя без потери некоторых ключевых функций. Для решения этой проблемы проект copilot-ollama представляет собой локальную цепочку прокси-серверов. Она работает по принципу преобразования и перенаправления запросов от VSCode Copilot к OpenRouter, обеспечивая сохранение возможностей function calling, или вызова инструментов.

Основная идея — обмануть систему Copilot, заставив ее думать, что она общается с Ollama сервером, который уже полностью поддерживает нужный протокол и API. Внутри цепочки proxy-компонентов oai2ollama работает как транслятор вызовов и ответов между Ollama и OpenAI форматом, а LiteLLM обеспечивает совместимость с OpenAI-протоколом и переправляет запросы к OpenRouter. За счет такой архитектуры становится возможным использовать самые мощные и интересные модели OpenRouter напрямую в агентском режиме GitHub Copilot, не жертвуя комфортом работы и расширенными функциями. Чтобы начать работу с Copilot-Ollama, необходимо создать локальное окружение на своем компьютере. Для этого понадобится пакетный менеджер uv — он отвечает за установку и настройку зависимостей, а также сама установка прокси.

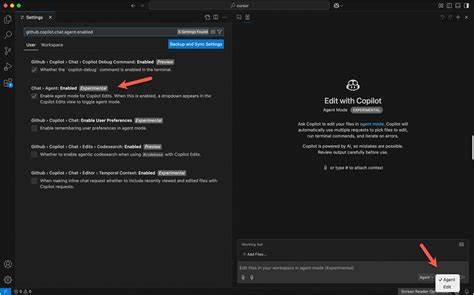

Первым шагом является клонирование репозитория copilot-ollama из GitHub, после чего в терминале нужно экспортировать переменную OPENROUTER_API_KEY, где хранится ваш собственный ключ от OpenRouter для аутентификации и работы с моделями. Запускается сервер с помощью скрипта run.sh, который поднимает все необходимые процессы локального прокси. Далее в настройках VSCode, где установлен Copilot, нужно указать endpoint proxy — локальный адрес, по которому работает Ollama-сервер, в данном случае http://localhost:11434. После этого в интерфейсе Copilot активируется выбор моделей Ollama, где можно выбрать любую добавленную в конфиг.

yaml модель OpenRouter через этот прокси. Конфигурация конфигурационного файла config.yaml представляет собой удобный способ определить список доступных моделей и параметров. Здесь задаются имена моделей, которые будут отображаться в VSCode, а также конкретные модели OpenRouter, к которым будет происходить проксирование запросов. Среди популярных моделей, рекомендуемых к использованию, присутствуют Claude-3-sonnet, отличающийся высокой точностью генерации кода, а также GPT-4-turbo — улучшенный вариант известной GPT-4 с оптимизированной производительностью.

Кроме того, есть опции для использования быстрых и открытых моделей, таких как Mixtral-8x7b и мощного LLaMA-3-70b от Meta. Их гибкое добавление позволяет адаптировать Copilot под самые разные задачи как для персональной разработки, так и для корпоративного использования. Практическая структура работы прокси проста и при этом эффективна. VSCode Copilot отправляет запросы, считая, что обращается к настоящему серверу Ollama. Дальше oai2ollama конвертирует эти запросы в OpenAI-совместимый формат, который обрабатывает LiteLLM и направляет их на OpenRouter.

При этом функции, необходимые Agent Mode Copilot, в том числе вызов инструментов и другие расширенные опции, тщательно сохраняются и корректно обрабатываются. Проект открыт и развивается сообществом. Он принимает предложения по улучшению, исправлению багов и расширению функционала. Это срабатывает как дополнительный стимул к постоянному совершенствованию инструмента и расширению списка поддерживаемых моделей. На фоне растущего спроса на умные помощники разработчика использование OpenRouter моделей становится все более актуальным, а возможность объединить их с Agent Mode GitHub Copilot дает огромные преимущества в автоматизации рутинных задач и ускорении процессов разработки.

Важно отметить, что проект полностью бесплатен и распространяется под лицензией MIT, что позволяет свободно использовать, модифицировать и распространять его без ограничений. Для тех, кто увлечен современными технологиями и хочет повысить производительность своих рабочих процессов, Copilot-Ollama открывает новые горизонты. Интеграция нескольких платформ и подходов в единую цепочку делают возможным использование самых инновационных моделей искусственного интеллекта без ограничений рамками одного API или сервиса. Такой подход отражает дух открытого программного обеспечения и быстро развивающегося рынка AI. В заключение, локальный 3-ступенчатый прокси copilot-ollama — это прорывное решение для разработчиков, желающих использовать модели OpenRouter в агентском режиме GitHub Copilot.

Он объединяет лучшие качества каждого компонента, скрывая их технические ограничения за прозрачным и удобным интерфейсом. Если вы устали от ограничений стандартного API и хотите раскрыть полный потенциал интеллектуального помощника для кодирования, это решение стоит опробовать уже сегодня. Настройка не занимает много времени, а преимущества в виде расширенного выбора моделей и сохранения функции инструментария сделают вашу работу продуктивнее и приятнее.