С развитием искусственного интеллекта и распространением агентных систем, которые способны самостоятельно принимать решения и адаптироваться к изменениям среды, перед разработчиками встала серьезная задача — как качественно и эффективно тестировать такие ИИ-агенты. Традиционные методы тестирования программного обеспечения, построенные на проверке функций и сценариев с предсказуемым поведением, оказываются недостаточными для сложных агентов, обладающих элементами автономии и изменчивости. Более того, многие команды, работающие с ИИ-агентами, упираются в своеобразную стену, когда пытаются масштабировать процесс тестирования, пытаясь вручную проверять и оценивать взаимодействия агентов. Многие разработчики до сих пор полагаются на мануальное проходжение через разговоры с агентом или на субъективную оценку результатов, так называемую "vibe checking". Эти практики невозможно реализовать эффективно при масштабном развертывании и развитии систем.

Проблема более глубока: агенты ведут себя не как статичные функции, а скорее как динамичные процессы, которые принимают решения, ведут диалог в меняющемся контексте, могут эскалировать задачи и адаптироваться к новому окружению. В этом смысле ИИ-агенты напоминают сложные бизнес-процессы, а не простые программные модули. Руководитель технического отдела одной из команд, работающих с ИИ-агентами, описал потребность в коренной пересмотр методик тестирования в блоге, где подробно рассказывалось о будущем подходе к проверке систем. В частности, делался акцент на роли симуляций, которые становятся новым стандартом проверки таких агентов. Вместо того, чтобы жестко кодировать тестовые сценарии, симуляции позволяют моделировать реальные жизненные ситуации и взаимодействия, что дает возможность выявлять регрессии и ошибки на ранних этапах разработки.

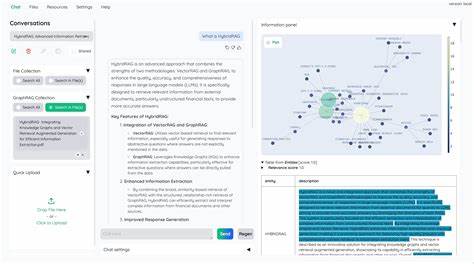

Одна из технологий, получившая распространение, — LangWatch scenario. Этот инструмент помогает создавать сценарии и прогонять множество вариантов взаимодействия с агентами, имитируя реальный пользовательский опыт и реакцию системы в различных ситуациях. Такой подход уже показал свою эффективность и помогает командам ранее находить узкие места и улучшать надежность ИИ-агентов перед публичным запуском. Сложность тестирования еще обусловлена самой природой ИИ-агентов как непредсказуемых и частично непрозрачных систем. Один из разработчиков из сообщества поделился своим опытом, где он предлагал тестировать ИИ-агентов в детерминированной среде с применением внедрения зависимостей (IoC — Inversion of Control).

Такой метод позволяет контролировать и имитировать поведение отдельных компонентов системы, что облегчает создание репродуцируемых тестов. Там, где такой подход невозможен, применяются проверки с использованием эмбеддингов, позволяющие оценивать схожесть ответов ИИ и соответствие ожидаемым результатам. Важно понимать, что агенты, будучи сложными и часто обучающимися системами, меняются со временем, усложняя задачу контроля качества. Обычные юнит-тесты, которые отлично работают с традиционным софтом, не учитывают адаптивность и динамику принятия решений. Именно поэтому симуляции становятся наиболее логичным и действенным вариантом, так как они моделируют поведение агента в различных условиях, позволяют тестировать реакции в пределах реальных сценариев и могут быть автоматизированы для непрерывного контроля качества.

Индустрия постепенно приходит к пониманию, что тестирование ИИ-агентов требует переформатирования установленных процессов. Команды должны учиться создавать гибкие симуляционные среды, нацеленные не на то, чтобы просто убедиться в том, что агент отвечает как ожидалось в конкретной точке, а чтобы исследовать широкий спектр взаимодействий и контекстов, которые могут возникнуть при реальном использовании. Перспективы развития в этой области связаны с более тесным объединением методов машинного обучения и автоматического тестирования, а также с созданием платформ, которые позволят без серьезных инженерных затрат создавать и масштабировать симуляции. Разработчикам необходимо учитывать, что с ростом сложности ИИ-агентов возрастает и значение обеспечения качества на всех этапах жизненного цикла, чтобы избежать чрезмерных ошибок и негативных пользовательских впечатлений. Таким образом, борьба с вызовами тестирования ИИ-агентов указывает на необходимость отхода от классических парадигм и принятия новых стандартов, где на передний план выходят симуляции.

Это не просто тренд, а логичный шаг в развитии индустрии, позволяющий создавать более надежные, адаптивные и полезные ИИ-решения, которые действительно способны выполнять сложные задачи и взаимодействовать с людьми на высоком уровне.