Go - один из самых популярных языков программирования для создания облачных и микросервисных приложений. Он славится своей простотой, высокой производительностью и встроенной поддержкой конкурентности. Одной из ключевых особенностей Go является его эффективный сборщик мусора (GC), который автоматически управляет памятью, освобождая разработчиков от необходимости вручную заниматься этой трудоемкой задачей. Тем не менее, стандартные настройки GC, оптимизированные под разнообразные среды, не всегда идеально подходят для контейнеризированных приложений в Kubernetes. В этой статье мы подробно рассмотрим, почему оптимизация сборщика мусора в Kubernetes имеет решающее значение, а также как динамическое управление параметрами GC позволяет улучшить производительность и уменьшить затраты на инфраструктуру.

Kubernetes как платформа для развертывания контейнеров открывает новые возможности для управления ресурсами. В отличие от традиционных серверных сред, Kubernetes заранее резервирует ограниченные объемы памяти и процессорного времени для каждого контейнера через механизмы запросов и лимитов. Такие жесткие ограничения меняют предпосылки, на которых базируются стандартные алгоритмы сборщика мусора Go. Обычно Go GC должен быть консервативным в вопросе выделения памяти, так как не может предсказать общее доступное количество ресурсов. Однако в Kubernetes, благодаря точному выделению памяти через memory requests и limits, появляется возможность более агрессивного использования выделенной памяти для уменьшения нагрузки на процессор.

Многие корпоративные кластеры Kubernetes, особенно в производственных средах, сталкиваются с ситуацией, когда процессорное время является узким местом, а память остается относительно свободной. Вследствие этого рационально искать оптимизацию, которая позволила бы "потратить" дополнительную память во благо снижения загрузки CPU. Анализ статистики типичных Go-приложений внутри Kubernetes выявил, что на сбор мусора уходит от 10 до 20 процентов всего процессорного времени. Это представляется серьезной площадкой для оптимизации: если удастся снизить нагрузку на процессор без выхода за рамки отведенного объема памяти, можно увеличить плотность развертывания подов, снизить расходы на инфраструктуру и улучшить отзывчивость приложений. Важно понимать, что частые заблуждения касаются связки длительности пауз GC и объема освобождаемой памяти.

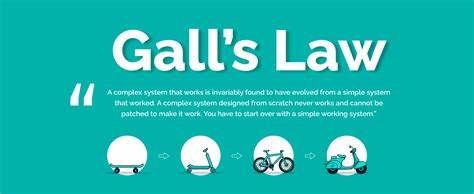

В действительности, время паузы не зависит напрямую от размера кучи, а больше от количества активных горутин. Каждая GC-цикл имеет фиксированные издержки CPU, поэтому частые циклы способны сжигать значительную долю процессорного времени. Это открывает путь для ключевого подхода - уменьшать частоту циклов GC, позволяя куче расти больше, что снижает общую нагрузку на CPU, но увеличивает потребление памяти. Сам язык Go с момента своего появления выстраивал GC с прицелом на непредсказуемые условия работы, где объёмы доступной памяти меняются и требуют консервативного управления выделением. Kubernetes же предоставляет предсказуемый госбюджет памяти для каждого контейнера, что открывает окно для динамической оптимизации на уровне GC.

Важной вехой стало появление версии Go 1.19, где был введен параметр GOMEMLIMIT. Он позволяет задать софт-лимит памяти, который GC использует как ориентир для начала сбора и тем самым контролирует частоту циклов. Однако GOMEMLIMIT учитывает только heap-память, не включая всю остальную память процесса. Это накладывает задачу точного учета и настройки, чтобы суммарное использованное приложение пространство не выходило за предел контейнерного лимита.

Оптимизация на основе обмена CPU на память имеет явные физические ограничения, проявляющиеся через убывающую отдачу. Если уменьшить нагрузку GC в 2 раза, надо удвоить размер доступной heap-памяти. Но последующие уменьшения нагрузки требуют все больше памяти ради все меньшей экономии CPU. Например, для снижения CPU-затрат с 20 до 10 процентов памяти требуется рост с 1 до 2 Гб, что соответствует 5% CPU за каждый гигабайт. Снижение с 5% до 2.

5% будет стоить уже 8 Гб, а отдача упадет до 0.3% CPU за гигабайт. Несмотря на схематичность, такой расчет отражает смещение баланса в сторону рационального компромисса. Чтобы эффективно управлять GC в пограничных условиях контейнеров Kubernetes, статические настройки оказываются недостаточно гибкими. Именно поэтому была разработана динамическая библиотека, которая мониторит реальные показатели использования памяти и CPU в рантайме и корректирует GOMEMLIMIT "на лету".

Алгоритм начинается с установки GOMEMLIMIT на уровне 80% от memory request контейнера и с максимальным GOGC. На основе текущих данных о памяти и нагрузке GC через регулярные интервалы (например, раз в минуту) происходит корректировка. Если потребление памяти выходит за определенный порог, GOMEMLIMIT снижается, чтобы сборщик чаще очищал память и не образовывал излишний оверхед. Если же CPU, затрачиваемый на GC, превышает около 1%, предел GOMEMLIMIT увеличивается, поощряя реже запускать GC и снижая затраты процессорного времени. Такой адаптивный подход позволяет избежать как чрезмерного потребления памяти, так и неоправданного трата CPU на частые циклы GC.

Реализация подобной динамической настройки даст возможность приложениям гибко реагировать на меняющиеся профили нагрузки, оптимально балансируя между скоростью освобождения памяти и эффективностью использования CPU. В практических тестах удавалось добиться значительного снижения нагрузки на процессор, уменьшая затраты на GC с 10-20% до приблизительно 1%. Память при этом естественно увеличивалась, но в пределах установленных контейнером лимитов, что приводит к более эффективному распределению ресурсов внутри кластера. Для Kubernetes с типично CPU-узкими кластерами подобное улучшение означает возможность разместить больше подов на одном узле, снизить общую стоимость эксплуатации и улучшить отклик приложений за счет освобождения процессорных циклов для бизнес-логики. Ключевой вынос из опыта состоит в том, что Go GC при всей своей продуманности и универсальности в Kubernetes-средах может получить заметный выигрыш от контекста динамической настройки.

Используя предоставленные языком механизмы, такие как GOMEMLIMIT, и дополняя их динамическим мониторингом текущих метрик, организации могут получить реальную прибыль в производительности и экономии затрат. Таким образом, динамическая оптимизация сборщика мусора Go становится важным элементом при создании высокоэффективных, масштабируемых облачных приложений в контейнерных оркестраторах вроде Kubernetes. Технологический прогресс в экосистеме Go и Kubernetes открывает перед разработчиками новые горизонты для тонких, но мощных оптимизаций, которые делают приложения не только быстрее, но и экономичнее в плане использования ресурсов. Подводя итог, стоит отметить: оптимизация GC на основе реального мониторинга памяти и CPU внутри четко лимитированных контейнеров Kubernetes позволяет л согласно бизнесу масштабировать приложения с меньшими затратами и без потери стабильности. Внедрение динамического управления параметрами GC является современным, умным и эффективно проверенным способом добиться баланса между памятью и процессорными ресурсами в современных облачных средах.

.