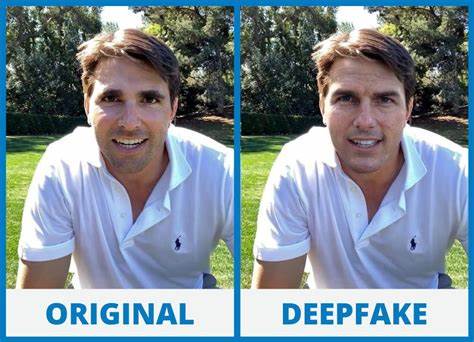

В современном мире технологии развиваются стремительно, и вместе с ними появляются новые угрозы и вызовы кибербезопасности. Одним из самых опасных направлений злоупотребления инновациями стала технология дипфейк — искусственное создание видео и аудио, способное практически идеально имитировать внешность и голос конкретного человека. Недавний случай в Гонконге, где сотрудник финансовой компании перевел $25 миллионов мошенникам, которые использовали дипфейк, наглядно демонстрирует опасность подобных методов и подчеркивает необходимость повышения киберграмотности и защиты в корпоративном секторе. Этот инцидент стал одним из самых резонансных примеров применения ИИ в финансовом мошенничестве и вскрыл ряд уязвимостей даже в крупных международных корпорациях. Суть происшествия заключалась в том, что сотрудник финансового отдела получил приглашение принять участие в видеоконференции, на которой присутствовал, как ему казалось, главный финансовый директор (CFO) его компании из Великобритании, а также другие сотрудники.

Однако все участники видеозвонка оказались искусственно создаными образами — дипфейками, сгенерированными на основе публичных видео и аудиозаписей. Используя подобную технологию, мошенники смогли добиться такого уровня достоверности, что жертва не заподозрила подмену и согласилась на перевод крупной суммы денег в размере 200 миллионов гонконгских долларов — около 25,6 миллиона долларов США. Как объяснили представители полиции Гонконга, рабочий изначально отнесся с подозрением к электронному письму с предложением провести секретную операцию, однако на видео-конференции, где, казалось, присутствовали знакомые лица и знакомые голоса коллег, он отказался от своих сомнений. Такие факторы доверия, подкрепленные визуальными и аудиовоспроизведениями, убедили его провести транзакцию. Обнаружение обмана произошло уже после того, как сотрудник напрямую связался с головным офисом компании, убедившись, что никто из реальных сотрудников не инициировал данную сделку.

Это преступление стало частью более широкой тенденции роста случаев применения дипфейков в финансовом мошенничестве по всему миру. Злоумышленники активно используют искусственный интеллект не только для имитации внешности и голоса руководителей, но и для обхода систем безопасности, включая технологии распознавания лиц, что делает ситуацию особенно тревожной. Гонконгская полиция сообщила, что за последний год было зафиксировано как минимум шесть случаев, где преступники рассылали фальшивые видеозаписи и аудиосообщения, а также использовали поддельные документы и украденные удостоверения личности для совершения преступлений. Практически в каждом случае формат мошенничества был схожим: преступники изучали поведение и речь своих целей, создавали маски из похищенных персональных данных и публично доступных материалов, а после – проводили тщательно спланированные операции, которые выглядели естественно и вызывающе доверие. В одном из эпизодов были задействованы восемь украденных удостоверений личности, что позволило злоумышленникам оформить десятки кредитных заявок и открыть десятки банковских счетов.

На практике это подчеркивает, насколько глубока интеграция искусственного интеллекта в преступный мир и насколько сложно защититься обычными методами. Образцы дипфейков, созданных для мошенничества, отличаются высоким качеством. Они позволяют не только имитировать внешность, но и воспроизводить мимику, жесты, тембр голоса и даже интонации, что затрудняет обнаружение подделки даже для специалистов. Вместе с тем, появление таких технологий также вызывает серьезные корпоративные риски, ведь доверие к видео- и аудиоматериалам, которые традиционно считались надежными средствами подтверждения информации, начинает снижаться. Случай в Гонконге послужил своеобразным предупреждением для многих компаний по всему миру.

Он показывает, что внутренние процессы проверки, особенно в области финансовых операций, должны подвергаться пересмотру и усилению. Применение многофакторной аутентификации, прямое подтверждение сделок с помощью нескольких независимых каналов коммуникации и обязательные проверки личных встреч с высшим руководством становятся необходимыми мерами для предотвращения подобных инцидентов. Помимо корпоративных мер, инциденты с дипфейками поднимают вопрос о необходимости регулирования и законодательного контроля применения технологий искусственного интеллекта. В настоящее время большинство стран не имеют четких норм, регулирующих использование дипфейков, что создает серьезные риски для безопасности и прав граждан. Инциденты с мошенничеством требуют совместных усилий властей и разработчиков ИИ для разработки стандартов и создания инструментов, позволяющих надежно выявлять подделки.

Проблема не ограничивается только корпоративной сферой. В 2024 году широкое обсуждение получил случай с порно-дипфейками, где подделывались изображения известной американской певицы Тейлор Свифт. Эти фотографии, созданные также с использованием искусственного интеллекта, распространились в социальных сетях и были просмотрены десятки миллионов раз, прежде чем социальные платформы начали их удалять. Этот пример вновь доказал, как быстро новые технологии могут быть использованы во вред, особенно для создания вредоносного контента и клеветы. В условиях стремительного распространения дипфейков и других видов киберпреступлений важно каждому сотруднику, особенно связанного с финансами и управлением, обладать пониманием особенностей новых угроз.