С развитием технологий искусственного интеллекта (ИИ) стремительно растет и спектр угроз, связанных с их безопасностью. Недавний инцидент с компанией Microsoft, одной из ключевых игроков в области облачных AI-решений, продемонстрировал новый тип кибератак, направленных на обход систем защиты и разработку вредоносного контента с помощью ИИ. Этот случай поставил перед экспертами новый вызов — как обеспечить безопасность хранящихся в облаке данных и самих AI-моделей в эпоху, когда злоумышленники используют все более изощренные методы взлома. В данной статье мы подробно рассмотрим, что именно произошло, почему подобные атаки опасны и каким образом компании и пользователи могут защитить свои системы и данные. Недавно Microsoft подала в суд на группу хакеров, обвиняемых в создании программного обеспечения, способного отключать защитные механизмы некоторых AI-продуктов компании, функционирующих на базе облачной платформы Azure.

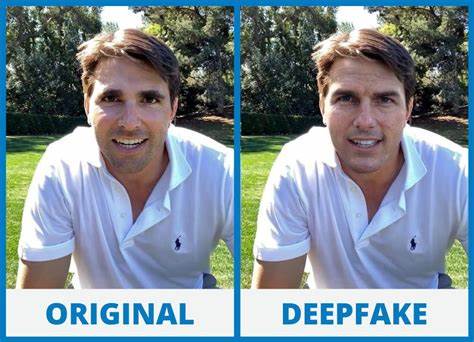

По заявлению Microsoft, злоумышленники смогли получить доступ к законным учетным записям клиентов Azure, используя похищенные логины, а затем запустили специализированный код, который обходил встроенные ограничения. В частности, выражаются опасения, что этим способом злоумышленники попытались генерировать нежелательный и возможный вредоносный контент с помощью моделей типа DALL-E, созданной OpenAI. Подобные действия представляют собой совершенно новый уровень киберугроз, направленных на технологии ИИ. В случае с Microsoft речь идет не просто о взломе традиционных серверов или кражи данных, а о манипуляции алгоритмами, которые способны создавать изображения и другие виды мультимедийного контента. Возможные злоупотребления включают создание экстремистских или непристойных изображений, фальсификацию политических или социальных посланий и дезинформацию с помощью глубоко реалистичных фейков.

Это открывает двери для моральных, этических и правовых проблем, заставляя крупные компании и органы власти уделять особое внимание контролю над такими системами. Происшествие с Microsoft напоминает и про схожие проблемы, с которыми столкнулись и другие гиганты индустрии. Например, летний инцидент с Google и их AI-системой Gemini, когда из-за ошибки в алгоритмах генерации изображений возникли образцы, содержащие расово или культурно неприемлемый контент. Случай вызвал необходимость временного отката системы и публичных извинений со стороны руководства. Эти события подчеркивают не только технические сложности разработки и эксплуатации искусственного интеллекта, но и важность жесткого мониторинга и внедрения многоуровневых мер безопасности.

Одной из важнейших причин успешной атаки на Microsoft стало использование похищенных учетных данных клиентов Azure. Это указывает на необходимость более строгой защиты доступа и аутентификации, поскольку в современных условиях даже самая совершенная архитектура системы может быть скомпрометирована при утере логинов и паролей. Поэтому практика усиления многофакторной аутентификации, регулярной смены паролей и мониторинга подозрительных действий становится обязательным элементом защиты, особенно для организаций, использующих облачные сервисы ИИ. Microsoft в ответ на произошедшие события быстро реализовала целый комплекс контрмер, включая судебное вмешательство и технические обновления платформы Azure, что позволило изъять один из ключевых веб-сайтов, использованных хакерами. Тем не менее, крупная компания с богатой технической базой и большим числом экспертов в области кибербезопасности может эффективно реагировать на подобные угрозы, а вот для средних и малых предприятий проблемы выглядят более угрожающе.

У них зачастую нет ресурсов и опыта, необходимого для своевременного обнаружения атак или внедрения сложных защитных механизмов. В такой ситуации особую роль начинает играть сам искусственный интеллект, используемый для кибербезопасности. Современные AI-решения могут анализировать огромные объемы данных, выявлять аномалии поведения, прогнозировать потенциальные угрозы и автоматически реагировать на них, снижая нагрузку на человеческие ресурсы. Таким образом, даже небольшие компании, которые продают или применяют AI-сервисы для сторонних пользователей, получают возможность повысить уровень защиты своих систем и клиентов. Тем не менее, основной уязвимостью остается человеческий фактор.

Простые ошибки в обращении с учетными данными, недостаточная бдительность и непонимание рисков могут привести к компрометации критически важных систем. Именно поэтому эксперты настоятельно рекомендуют выстроить комплексную политику информационной безопасности, включающую не только технические, но и организационные меры — регулярное обучение сотрудников, внедрение протоколов реагирования на инциденты и постоянный аудит систем. Кроме того, этические аспекты использования ИИ оказываются в центре глобальных дискуссий по всему миру. Способность AI генерировать всевозможные виды контента, включая и провокационные или опасные изображения, влияет на законодательное регулирование, требования к прозрачности и контролю, а также на ответственность разработчиков и пользователей. Инциденты с Microsoft и другими компаниями стали сигналом, что игнорировать проблемы безопасности в сфере ИИ нельзя — они влияют не только на бизнес, но и на широту общественных последствий.

Значительную роль в формировании безопасной и ответственной среды для искусственного интеллекта могут сыграть международные нормы и соглашения, поддержка которых должна исходить от ведущих технологических компаний и правительств. Совместные усилия по созданию стандартов, как по технической части безопасности, так и по этическим нормам, помогут снизить риски злоупотреблений и способствовать доверию пользователей к инновационным системам. Таким образом, новый кейс Microsoft — не просто эпизод из мира технологических новостей. Это наглядный пример того, как стремительное развитие технологий меняет подходы к кибербезопасности и стимулирует переход на качественно новый уровень защиты. Он напоминает компаниям и пользователям о необходимости постоянного совершенствования своих стратегий, обучения и внедрения современных систем защиты, учитывая специфику именно AI-технологий, облачных платформ и глобальной цифровой экономики.

Для бизнеса, планирующего использование или разработку AI-сервисов, актуальной остается задача интеграции механизмов контроля доступа, мониторинга активности и быстрой реакции на подозрительные события. Важно также строить партнерские отношения с экспертами по безопасности и тщательно выбирать провайдеров облачных услуг с проверенной репутацией. Это позволит не только минимизировать риски, но и обеспечить долгосрочную устойчивость решений, основанных на искусственном интеллекте. Подводя итог, можно сказать, что история с атакой на ИИ-модель Microsoft открывает новую главу в понимании киберугроз и подчеркивает необходимость развивать многоуровневую безопасность. В будущем возможно появление и других способов эксплуатации ИИ в злонамеренных целях, поэтому подготовленность и проактивные меры остаются ключевыми факторами защиты как крупных корпораций, так и малых и средних предприятий.

Технологии искусственного интеллекта несут огромный потенциал для преобразования общества, но только при условии ответственности и постоянного развития системы безопасности вокруг них.