Президент Байден подписал один из самых масштабных исполнительных указов, касающихся регулирования искусственного интеллекта (ИИ). Этот указ официально должен повысить безопасность и прозрачность использования ИИ в различных сферах жизни американских граждан, включая защиту от мошенничества и распространения дезинформации. На первых порах инициатива была воспринята как важный шаг в правильном направлении, учитывая стремительное развитие и распространение технологий искусственного интеллекта. Однако, несмотря на положительные намерения, ряд специалистов, включая CEO компании Reality Defender Бена Колмана, выразили серьезные опасения по поводу эффективности некоторых положений указа, особенно связанных с применением технологии происхождения данных — так называемого водяного знака или provenance watermarking. Водяные знаки — это цифровые метки, которые призваны идентифицировать источник контента и подтверждать, что он сгенерирован искусственным интеллектом.

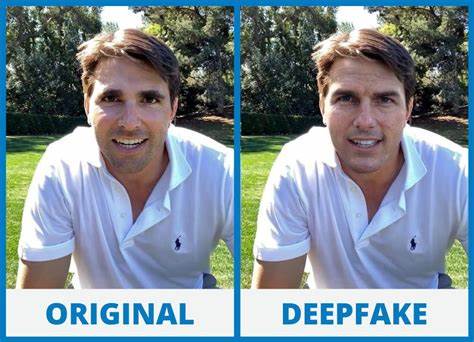

В теории, такая технология могла бы помочь отличить реальную информацию от подделки или дипфейков, сгенерированных с помощью ИИ. Белый дом настаивает, что внедрение таких стандартов для маркировки ИИ-контента позволит гражданам легче распознавать подлинные сообщения и обезопасит правительственные коммуникации, создав эталон и для частного сектора. Однако эксперты глубоко сомневаются в том, что внедрение водяных знаков действительно станет надежным решением. Колман обращает внимание на то, что современные методы водяных знаков легко обходятся злоумышленниками. Исследования таких университетов, как Мэриленд, Калифорния и Карнеги-Меллон, показали, что водяные знаки можно легко удалить или подделать с помощью простых симулированных атак.

Это ставит под сомнение возможность обеспечения надежной идентификации ИИ-сгенерированного контента в реальных условиях, где злоумышленники постоянно совершенствуют свои методы обхода защитных мер. Одним из ключевых критических замечаний является то, что водяные знаки продвигаются и разрабатываются преимущественно крупнейшими технологическими компаниями, такими как Microsoft, Adobe, Arm и Intel. Такой подход создаёт так называемую «огороженную» экосистему, в которой крупные игроки сами диктуют правила для регулирования ИИ. Колман указывает, что это может служить одновременно как способ саморегулирования индустрии, так и попыткой избежать внешнего надзора со стороны государства, скрывая свои недостатки и противоречивые интересы. Кроме того, любой подход, основанный на добровольном соблюдении правил крупными компаниями, не сможет эффективно работать для всех участников цифрового пространства.

В частности, любые хакеры, недоброжелательные акторы и государственные злоумышленники, которые по сути причиняют наибольший вред обществу через ИИ, просто не будут соблюдать созданные стандарты и законы. Они не ограничены платформами, которые пытаются контролировать доступ и вводить ограничения, поэтому даже самые продвинутые меры защиты могут быть обойдены. В результате Колман называет попытку внедрить водяные знаки "пластырем" — временной, недостаточно надежной мерой, которая создает иллюзию безопасности, но на деле не решает главных проблем. Более того, сама идея, что все пользователи и недоброжелатели будут следовать протоколам маркировки, сравнивается с установкой «умных замков» на дома, при этом надеясь, что все потенциальные преступники строго придерживаются правил использования ключей. Очевидно, что такая стратегия далека от реалий современного кибербезопасного ландшафта.

Вместо слепой веры в водяные знаки, эксперты считают важным развивать более комплексный и многоуровневый подход к выявлению дипфейков и защиты от мошенничества с использованием ИИ. Компания Reality Defender, к примеру, использует методы вероятностного анализа и глубинного обнаружения подделок, которые не полагаются на один идентификатор, а оценивают целый набор факторов, таких как анализ пикселей, спектрограммы, звуковые волны и особенности построения текста. Это позволяет получать оценку достоверности контента по шкале вероятности, давая пользователям возможность понимать риски и принимать информированные решения о распространении или доверии к информации. Еще одна важная проблема состоит в том, что компании, которые занимаются разработкой и распространением ИИ-технологий, заинтересованы в максимальной прибыли от своей продукции. Они не всегда заинтересованы в том, чтобы публично признавать уязвимости или возможности для злоупотребления своими системами.

Именно поэтому вице-президент Reality Defender настаивает на том, что государство должно приоритезировать независимые, прозрачные и надежные методы обнаружения дипфейков и других манипуляций, а не полагаться исключительно на меры и стандарты, предлагаемые крупнейшими технологическими корпорациями. Редкая изюминка в подходе Белого дома заключается в попытках повысить осведомленность общества и направить федеральные агентства на применение определенных инструментов для защиты коммуникаций. Однако полная оптимизация и внедрение надежных инструментов потребует гораздо большего времени, усилий, межведомственного сотрудничества и обязательств со стороны частного сектора и науки. Развитие технологий ИИ стремительно идёт вперед, и пока государство и отрасль не смогут предложить адекватные меры, пользователи подвергаются постоянной угрозе дезинформации, мошенничества и манипуляций. Технологии искусственного интеллекта оказывают глубокое влияние на современное общество, экономика и коммуникации.

Блестящее будущее ИИ связано с огромным потенциалом для решения глобальных проблем, повышения качества жизни и инноваций. Однако без адекватных механизмов контроля и защиты общество рискует столкнуться с серьезными вызовами, включая широкое распространение недостоверной информации, угрозы безопасности и потерю доверия к цифровым медиа. В итоге ситуация вокруг исполнительного указа Байдена показывает, что регулирование ИИ — это комплексная задача, требующая не только законодательных инициатив, но и технологических инноваций, сотрудничества между правительством, бизнесом и наукой, а также активного участия общества. Подход, основанный исключительно на доверии к крупнейшим компаниям и простых водяных знаках, не обеспечивает должного уровня безопасности и не учитывает реалий современных киберугроз. Реальная защита от дипфейков и злоупотреблений с ИИ требует более глубоких исследований, разработок и внедрения сложных инструментов, способных выявлять подделки с высокой степенью точности и предоставлять пользователям достоверную информацию о происхождении и надежности контента.

Такие меры помогут снизить риски, укрепить цифровую грамотность и повысить ответственность за создание и распространение ИИ-сгенерированного материала. Таким образом, исполнительный указ президента Байдена является важным шагом на пути к регулированию ИИ, но он нуждается в доработках и расширении. Только комплексный и хорошо продуманный подход позволит обеспечить эффективную защиту общества и повысить доверие к новым технологиям, которые продолжают изменять наш мир.