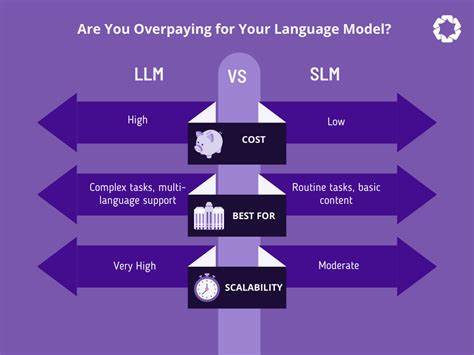

Большие языковые модели (LLM) стали фундаментальным инструментом в развитии искусственного интеллекта и автоматизации текстовой аналитики. С их помощью компании улучшают чат-боты, автоматизируют контент, оптимизируют процессы обработки данных и создают новые сервисы. Однако при выборе LLM очень легко переплатить. Мой масштабный анализ 439 различных моделей показывает, что не всегда высокая цена гарантирует высокое качество или оптимальные показатели производительности. Рынок LLM характеризуется большим разнообразием — от мировых лидеров, таких как OpenAI и Google, до менее известных, но не менее эффективных провайдеров.

Каждая модель отличается набором параметров: стоимость за миллион токенов, качество генерации текста, скорость обработки, размер контекстного окна и многое другое. И именно сопряжение этих факторов определяет рациональность вложений для бизнеса и разработчиков. Наблюдается ключевая тенденция — модели с самой высокой стоимостью не всегда обладают лучшим соотношением цена-качество. Например, GPT-5 и его вариации от OpenAI предлагают высокие параметры качества, но размеры цены на уровне 3.44 доллара за миллион токенов при этом существуют альтернативы с похожими показателями качества и значительно меньшей стоимостью.

Анализ цен показывает, что у провайдеров, вроде xAI и DeepSeek, можно найти модели производства Grok и DeepSeek V3, которые обеспечивают примерно ту же эффективность, но для них установлена цена существенно ниже, иногда до 0.28 доллара за миллион токенов. Это в десятки раз экономичнее по сравнению с лидерами рынка. Выбор модели только по качественным характеристикам непродуктивен без учета стоимости и скорости. Важно заметить, что скорость генерации токенов и задержка отклика играют критическую роль в реальных приложениях, особенно с требованиями к оперативному взаимодействию с пользователем.

Модели с меньшей задержкой отклика и высокой скоростью, даже при средней стоимости, могут оказаться более выгодными, чем дорогие высококачественные решения с длительным временем ожидания. Еще один аспект — контекстное окно. Модели с большим объемом контекстного окна позволяют обрабатывать более объемные задания без потери продуктивности и необходимости дополнительного распределения на части. Здесь тоже встречаются решения с выгодным компромиссом по цене и качеству. Отдельное внимание в обзоре уделено открытым исходным кодам моделей.

Их доля на рынке растет, что дает возможность упростить интеграцию и снизить затраты за счет отсутствия привязки к дорогим проприетарным системам. При правильном выборе разработчики и компании могут получить высококачественное решение, не переплачивая лишние средства за бренд или маркетинг. Для бизнеса критично оценивать не только качество модели, но и экосистему предоставления услуги — инфраструктуру, провайдера, сроки SLA и возможность масштабирования. Например, модель gpt-oss-120B, доступная через различные провайдеры включая Amazon Bedrock, Google Vertex и Nebius, демонстрирует хорошие показатели по цене и скорости, при высокой доступности и гибкости развертывания. При выборе LLM стоит использовать комплексный подход, который учитывает следующие параметры: эффективность модели на ваших конкретных задачах, стоимость за подачу и получение токенов, скорость отклика и совместимость с платформами и API.

Для компаний, строящих бизнес на работе с LLM, важно не только снизить стоимость одного запроса, но и добиться максимально стабильного качества при приемлемой скорости отклика, чтобы неудовлетворенные пользователи не уходили к конкурентам. Конкуренция между провайдерами заставляет рынок максимально быстро меняться. Новые модели с улучшенными алгоритмами и оптимизациями начинают выходить регулярно, а ценообразование становится прозрачнее и гибче. Тем не менее, многие пользователи продолжают зацикливаться на популярных, но дорогих моделях. Мой анализ доказывает, что сегодня реально получить сопоставимые показатели по качеству практически во всех существующих сценариях использования, потратив при этом в разы меньше, выбрав альтернативы, доступные у менее раскрученных провайдеров.

Более того, детальный разбор моделей показал, что различные версии одной и той же архитектуры могут существенно отличаться по качеству и цене в зависимости от поставщика и оптимизации. Например, модели GPT-5 мини и GPT-5 нано предлагают приемлемые уровни качества и при этом стоят значительно дешевле, что очень выгодно для долгосрочных и масштабных проектов. Нельзя не отметить, что оптимизация стоимости не должна идти в ущерб безопасности и конфиденциальности данных. Многие провайдеры сейчас предлагают модели, сертифицированные по стандартам безопасности и с возможностью локального развертывания. Это позволяет добиться полной автономии при минимальных затратах.

![Could this laser zap malaria? (2010) [video]](/images/8E052DBB-B9F2-49CF-92B3-C4C85598C3A3)