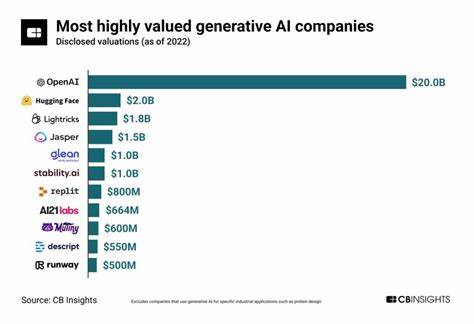

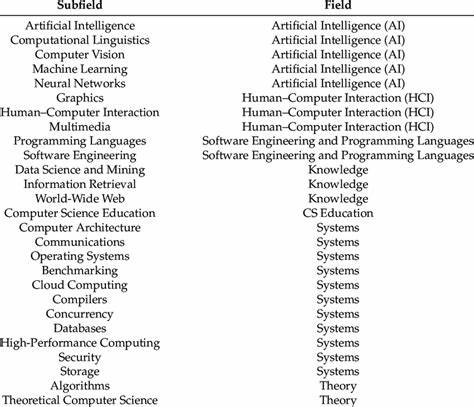

Генеративный искусственный интеллект (ИИ) стремительно меняет облик современного мира, открывая беспрецедентные возможности для творчества, науки и бизнеса. Однако за сияющей внешностью инноваций скрываются серьезные этические и социальные проблемы, связанные с деятельностью компаний, создающих эти технологии. Несмотря на все перечисленные достижения, нет ни одной компании, которая могла бы считаться полностью этичной. Наоборот, существует определённая иерархия вреда, где вопрос не в том, кто идеален, а кто наносит наименьший ущерб. Рассмотрим ключевых разработчиков генеративного ИИ, оценивая их с точки зрения экологической ответственности, условий труда, честности в маркетинге и прозрачности.

Первое место в списке наиболее вредных компаний занимает xAI — проект Илона Маска, известный своим чатботом Grok. Эта компания привлекает внимание прежде всего своим пренебрежением к экологическим и социальным нормам. Для обучения своих моделей xAI использует огромное количество электроэнергии. Недавно в Мемфисе, на территории преимущественно афроамериканского района, компания установила десятки газовых турбин без необходимых разрешений, что привело к ухудшению качества воздуха и значительному увеличению рисков заболеваний дыхательных путей и онкологических болезней среди местных жителей. Нарушения законодательства по охране окружающей среды, обвинения в экологическом расизме и безразличие к человеческому здоровью свидетельствуют о безответственном подходе к развитию ИИ.

Маск позиционирует Grok как «максимально нацеленную на правду» систему, однако ее алгоритмы распространяют дезинформацию о климатических изменениях примерно в десяти процентах случаев и даже защищают самого Маска и других влиятельных лиц от критики. Второе место занимает Meta — компания, совмещающая в своей работе масштабную эксплуатацию труда и внедрение ИИ с серьезными нарушениями этики. Meta приобрела значительную долю в компании Scale AI, которая организует трудовые процессы, требующие просмотра и маркировки контента, включающего насилие, детскую порнографию и другие травмирующие материалы. Работники из стран Глобального Юга, таких как Кения и Венесуэла, получают минимальную оплату за работу в экстремальных условиях, зачастую сталкиваясь с отсутствием механизма жалоб и поддержки. Кроме того, Meta допускает многочисленные проблемы с приватностью, например, при использовании своего AI-приложения, где личная информация пользователей становится доступна широкой аудитории.

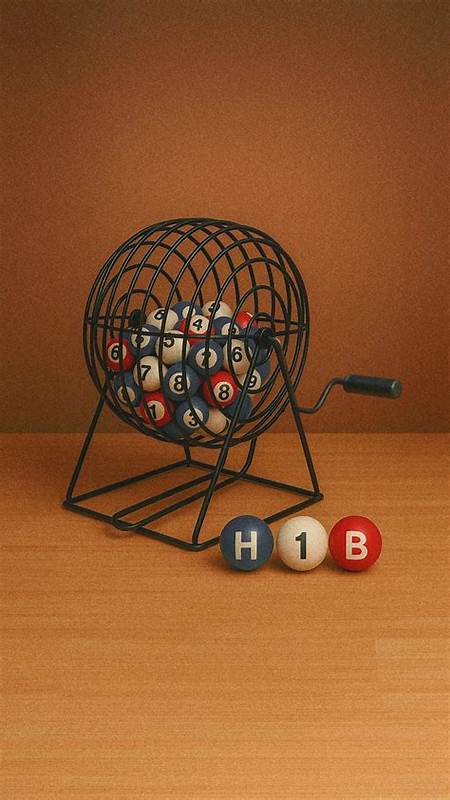

Монетизация уязвимостей пользователей, акселерация дискриминационных алгоритмов и масштабные нарушения в вопросах справедливости и равноправия превращают компанию в генератор системных нарушений и страданий. OpenAI, разработчик популярного ChatGPT, занимает третье место в рейтинге по причине своей практики демонстративного соблюдения правил безопасности при одновременном игнорировании их на практике и эксплуатации человеческого труда. Изначально учрежденная как некоммерческая организация с целью развития ИИ на благо всего человечества, OpenAI в 2019 году сменила курс на коммерческий, стремясь к неограниченной прибыли. При этом модель компании предполагает использование дешёвой рабочей силы из Глобального Юга, особенно из Кении, где работникам платят меньше двух долларов в час за просмотр и фильтрацию контента, связанного с насилием и эксплуатацией. Внутренние расследования выявили ложь основателя Сэма Олтмана перед советом директоров относительно мер безопасности, а также скрытие владения венчурным фондом, управляющим сотнями миллионов долларов.

Кроме того, ChatGPT показывает выраженную лингвистическую предвзятость, особенно по отношению к носителям афроамериканского варианта английского языка, что только усугубляет проблему цифровой дискриминации. Монетизация использования ИИ в качестве «псевдотерапевта» зачастую оборачивается ухудшением психического здоровья пользователей, а игнорирование этих последствий лишает компанию права называться ответственным разработчиком. Google в этом тревожном списке занимает промежуточное четвертое место. Компания инвестировала значительные средства в возобновляемую энергетику, построила продвинутые системы безопасности и этические принципы, даже возглавляла процессы внедрения ответственных практик. Однако за красивыми декларациями скрывается ряд нарушений и честные ошибки.

Примерами можно назвать мошенническое продвижение демо-версии модели Gemini, которое вводило в заблуждение инвесторов и пользователей, а также непрозрачное управление собственными принципами безопасности и увольнение ведущих исследователей, критиковавших эти процессы. Кроме того, Google Vision AI продемонстрировала расовую предвзятость, например, ошибочно распознавая объекты на фотографиях людей с темной кожей. Увеличение вредных выбросов от расширения инфраструктуры AI на 48% с 2019 года и отказ от углеродной нейтральности ослабляют её репутацию как экологически ответственной корпорации. Anthropic, компания, стоящая за Claude.ai, несмотря на свое позиционирование в качестве «ответственной» альтернативы, находится на пятом месте с минимальным вредом среди рассмотренных.

Она избежала худших практик эксплуатации труда, ввела инновационный метод модерации контента с минимальным участием человека и более открыта в своих коммуникациях. Тем не менее, амбиции по достижению общего искусственного интеллекта (AGI) к 2026–2027 годам, а также неспособность компании четко определять границы рисков и ненадлежащее раскрытие информации о воздействии на окружающую среду вызывают серьезные сомнения в ее этичности. Следует отметить, что Anthropic не публикует данные о выбросах углекислого газа и не раскрывает детали об использовании возобновляемых источников энергии, несмотря на планы масштабного роста дата-центров. На фоне всех перечисленных транснациональных корпораций заметно выделяются компании, такие как Mistral, базирующаяся во Франции. Они демонстрируют лучшие показатели по экологической эффективности благодаря использованию европейской ядерной энергетики и меньшему масштабу операций.

Mistral пытается избежать ручной модерации травмирующего контента, используя системы автономного самоконтроля ИИ. Несмотря на это, компания не освобождается от проблем безопасности: исследования показали высокую вероятность генерации неприемлемого контента, а позиция руководства, сводящая ответственность за злоупотребления к разработчикам приложений, вызывает тревогу. Нельзя забывать и о ключевой роли инфраструктурных гигантов, таких как Microsoft, Amazon, Oracle, Salesforce и Nvidia. Эти компании инвестируют огромные суммы в стартапы и проекты, создавая основу для развития генеративного ИИ. При этом они часто остаются вне зоны общественного внимания, аккуратно дистанцируясь от этических проблем, связанных с продуктами, разрабатываемыми на их базе.

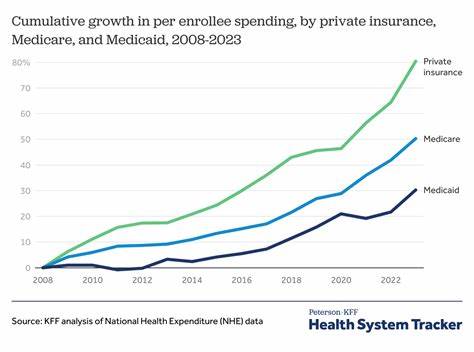

Принимая решение об использовании генеративного ИИ, пользователю важно осознавать, что ни одна из компаний не предлагает полностью безопасных и этичных решений. Каждый из ведущих игроков индустрии сделал определённый выбор — часто в пользу ускоренного роста и прибыли, рискованных экспериментов и экономии на рабочих и экологических стандартах. Желающим минимизировать вред стоит ориентироваться на компании с прозрачной политикой, меньшим уровнем эксплуатации и экологическими инициативами. В современном мире невозможно остановить развитие генеративного интеллекта — слишком велики финансовые и технологические интересы. Однако пользователи и общество в целом могут влиять на ситуацию, требуя большей ответственности, прозрачности и уважения к правам работников и окружающей среде.

Знание о недостатках и ошибках лидеров отрасли — первый шаг к выработке более продуманной и справедливой стратегии использования мощнейшей из ныне доступных технологий. В вопросах ИИ современность требует не слепого восхищения инновациями, а критического понимания, способного направить технологический прогресс на благо большинства, а не немногих избранных.