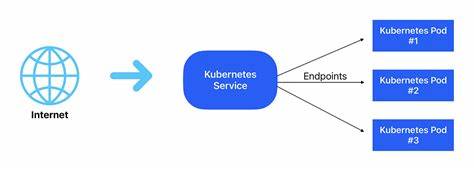

В первые дни развития интернет-приложений основой работы становились вызовы функций, запросы к базам данных или HTTP-запросы, оформленные в виде структурированных API. Архитектура микросервисов и проработанные интерфейсы позволили создавать масштабируемые системы с четко определенными контрактами между сервисами. Сетевые протоколы и модели управления трафиком, такие как уровни 4 и 7 в модели OSI, обеспечивали обработку запросов на уровне сокетов и приложений, ориентируясь на пути, заголовки и куки. Однако с развитием искусственного интеллекта и появлением больших языковых моделей ситуация кардинально меняется. В системах, построенных вокруг ИИ, центральной единицей работы становится не структурированный API-запрос, а именно запрос в форме естественного языка — prompt.

Промпт — это не просто набор данных, это открытая инструкция, сформулированная на человеческом языке. Она не имеет строгого формата, не поддается типизации или версионированию, каким обладают традиционные API. Запросы могут включать самые разные задачи: от сводки текста до создания кода, от генерации графиков до планов питания. Все они отправляются на универсальную конечную точку, например /v1/chat/completions, с POST-запросом, одинаковым по своему формату вне зависимости от запроса. Такое изменение приводит к фундаментальному вопросу: как эффективно маршрутизировать, анализировать и управлять этими промптами в масштабных системах? Классические модели маршрутизации, основанные на структурированных путях и методах HTTP, уже не работают, поскольку смысл запроса заключен в естественном тексте, а не в четко определенном адресе.

Например, запрос «Сделай короткую презентацию продукта на основе этого списка» — это задача с конкретной целью, но без формального метаданных, явно указывающего на её суть. В современных системах необходимо понимать намерение пользователя, чтобы направить запрос к подходящей модели или агенту. Возможно, творческие задачи стоит отправлять к мощному GPT-4, для суммаризации использовать Claude, а для задач со сниженным уровнем качества — локальные или менее трудоемкие модели. Некоторые ситуации требуют быстрого обнаружения вредоносных или неподобающих запросов с целью защиты системы. Это ставит разработчиков перед задачей создания так называемого «Layer 8» — концептуального, неофициального уровня в модели OSI, который работает не с протоколами и путями, а с понятиями целей и намерений за запросами.

Эта метафорическая восьмая ступень служит для анализа промптов, выявления их смысла, выбора оптимальных моделей, обеспечения ограничений безопасности и отслеживания метрик не просто на основе успешности или кода состояния, а в привязке к целям и задачам. Некоторые уже внедряют такие решения, даже не называя их Layer 8, но сама идея преобразования логики маршрутизации и наблюдаемости становится ключевой. Для разработчиков и инженеров поколение приложений на базе ИИ означает серьезные вызовы и возможности. Нужно уметь направлять запросы к нужному инструменту исходя из содержания, а не из статичного URL. Наблюдение и отладка как никогда становятся сосредоточенными на задачах и конечных целях, а не на традиционных API-эндпоинтах.

Вместо дебага кода или функций мы анализируем, почему промпт работает именно так и как модель отвечает на него. Планирование и управление задачами переходят на уровень высокоуровневых языковых инструкций, что требует нового подхода к инфраструктуре. Электронные шлюзы и прокси в прошлом помогали масштабировать и балансировать API-трафик. Сегодня же нужны системы, способные понимать запроса на естественном языке, расширяя роль прокси как «умного» маршрутизатора, способного интегрироваться с множеством моделей и агентов. Они должны обогащать входящие запросы данными о целях и контексте, обеспечивая более точное и эффективное распределение нагрузки.

Такое развитие инфраструктуры позволит строить платформонезависимые, совместимые с многочисленными фреймворками решения, существенно ускоряя процесс создания и вывода ИИ-приложений в продакшен. Одним из примеров является проект Arch — умный прокси-сервер, разработанный авторами Envoy, который берет на себя сложные задачи маршрутизации, интеграции промптов с бизнес-API и универсального мониторинга LLM. Эта практика демонстрирует реальные шаги к новой парадигме, где промпт становится атомарной единицей работы, а Layer 8 — механизмом ее обработки. В итоге можно сказать, что запросы действительно становятся новой базовой единицей труда в ИИ-ориентированных приложениях. Этот сдвиг требует переосмысления подходов к построению инфраструктур, изменяет систему наблюдения, маршрутизации и безопасности.

Признание этой перемены открывает путь к более гибким и мощным системам, которые смогут эффективно справляться с задачами будущего в мире технологий, управляемых искусственным интеллектом.

![William Cowper's pet hares [1784]](/images/C59B41FA-C37B-4C4B-9AA6-AE1C8F86C8D8)