12 июня 2025 года мир облачных технологий столкнулся с масштабным и неожиданным сбоем, вызванным ошибкой в системе управления API Google Cloud Platform (GCP). Этот инцидент затронул широкие слои интернет-инфраструктуры, вызвал серьезные перебои у множества сервисов и повлиял на работу тысяч компаний по всему миру. Среди них оказались даже такие крупнейшие игроки, которые обычно отличаются высоким уровнем устойчивости. Тем не менее, на фоне этого хаоса клиенты Redpanda Cloud смогли продолжать работу без заметных сбоев — что стало результатом тщательной подготовки, продуманной архитектуры и ответственного подхода к управлению инфраструктурой. В этой статье мы детально рассмотрим, что именно произошло, как Redpanda Cloud справилась с ситуацией, и какие выводы можно сделать для повышения надежности и устойчивости современных облачных сервисов.

Начнем с предыстории самого сбоя. Вся сложность современных информационных систем — в их принципиальной нелинейности. Небольшое изменение параметра или настройка могут привести к масштабным последствиям, гораздо большим, чем ожидалось. Это явление известно в теории хаоса как эффект бабочки, а в системном мышлении выражается фразой «целое больше суммы его частей». Именно по этой причине в индустрии разработаны различные меры безопасности и контроля, начиная от поэтапного внедрения изменений и заканчивая автоматической балансировкой нагрузки.

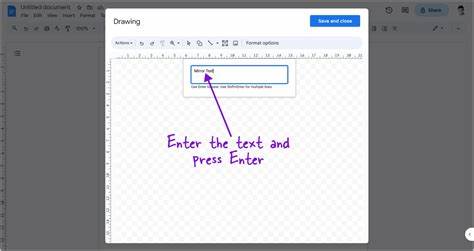

В случае GCP сбой был вызван автоматическим обновлением квоты в системе API, что скапливалось в цепочку непредсказуемых ошибок и привело к масштабному отключению сервисов по всему миру. Сообщение о сбое поступило команде Redpanda Cloud от их менеджера по техническим аккаунтам в Google в 18:41 по UTC. Практически сразу после этого Redpanda начала анализ ситуации, отслеживая влияние инцидента на работу своих клиентов в инфраструктуре GCP. Первые минуты показали, что система мониторинга работала в ухудшенном режиме. Хотя данные поступали, уведомления и предупреждения из-за частичного сбоя провайдера внешнего мониторинга не поступали.

Несмотря на это, инженеры Redpanda могли самостоятельно и эффективно контролировать состояние критических метрик и логов благодаря собственной платформе наблюдаемости, размещённой силами самой компании. В течение следующих часов Redpanda приняла ряд превентивных мер. В 19:08 UTC была объявлена внутренняя низкосерьезная инцидентная команда для координации действий на случай потенциальных проблем. Параллельно шло взаимодействие с внешними поставщиками, некоторые из которых также пострадали вследствие связанной с GCP проблемой. Любопытно, что одно из препятствий — сервис, управляющий облачными маркетплейсами, испытывал проблемы вследствие сбоя другого крупного игрока — Cloudflare, который оказался связан с цепочкой событий в GCP.

После того, как Google официально признал причину сбоя и начал корректирующие мероприятия, в течение следующих часов команда Redpanda внимательно наблюдала за показателями эксплуатационной надежности своих кластеров. Клиенты Redpanda не подавали жалобы и не сообщали о сбоях. Были замечены некоторые отклонения в работе дополнительного уровня хранения данных (так называемого tiered storage), однако они не перешли в критический уровень и не влияли непосредственно на основные операции чтения и записи данных. В связи с этим инженеры Redpanda предприняли проактивный шаг — связались с клиентами, у которых наблюдались наивысшие показатели ошибок на уровне дополнительного хранилища, чтобы подтвердить отсутствие проблем и продемонстрировать поддержку. Примерно через три с половиной часа с момента начала сбоя внутренний анализ позволил команде Redpanda признать инцидент смягченным, с уровнем серьезности SEV4, что означает отсутствие значительного влияния на пользовательский опыт.

Ошибки на водонепроницаемом уровне API вызвали незначительное замедление некоторых операций, но сотни кластеров в облаке GCP оставались полностью работоспособными. Успех Redpanda в минимизации воздействия сбоя объясняется несколькими ключевыми архитектурными решениями и организационными мерами. В первую очередь стоит обратить внимание на cell-based архитектуру, используемую в Redpanda Cloud. В отличие от централизованных систем, где все критические метаданные и сервисы выносятся в единую точку, Redpanda размещает все важные сервисы — управление топиками, ACL, хранение метаданных — непосредственно внутри каждого кластера, используя единый исполняемый бинарный файл. Такая архитектура значительно сокращает зону влияния потенциальных сбоев и повышает как безопасность, так и отказоустойчивость.

Кроме того, Redpanda Cloud был задуман сразу с целью обеспечить уровень доступности 99,99%, который вышел на практике даже выше — порядка 99,999% благодаря мультизональным кластерам в GCP. Это оказалось важным, учитывая непредсказуемость сбоев в облачной инфраструктуре. Для достижения такой надежности применяется несколько технических приемов: обязательное реплицирование данных с коэффициентом минимум 3, использование высокопроизводительных локальных NVMe дисков для первичного хранения с асинхронным выносом старых данных на многоуровневое хранение, резервирование всех основных сервисов — Kafka API, Schema Registry и Kafka HTTP Proxy. Не менее важен строгий инженерный контроль качества релизов, включая нагрузочное тестирование и постепенное развертывание обновлений с непрерывной обратной связью на метрики и эвент-операции. Но, как отмечают инженеры Redpanda, немалую роль сыграла и удача.

Из сотен кластеров, использующих GCP, только один был затронут локальной проблемой в регионе us-central-1, где произошла потеря одного узла и задержка его замещения на два часа. К счастью, этот кластер был тестовым, а не продуктивным, благодаря чем пользовательская нагрузка не пострадала. Нельзя не отметить важность собственной инфраструктуры наблюдения, которую Redpanda внедрила за год до инцидента. В отличие от многих компаний, полностью завязанных на сторонних облачных сервисах мониторинга и алертинга, Redpanda самоорганизовала сбор, хранение и обработку метрик и логов внутри своей системы. Это позволило сохранять контроль над ключевыми показателями в условиях деградации внешних сервисов и избежать катастрофических последствий.

Опыт Redpanda Cloud в преодолении этого глобального сбоя — отличный пример того, как глубокое понимание архитектурных принципов, комплексный подход к надежности и продуманное управление операциями помогают минимизировать риски и поддерживать непрерывность работы важных сервисов в нестабильных условиях. Если смотреть в будущее, системная сложность и взаимозависимость облачных и распределённых систем будет только расти — особенно с учетом развития искусственного интеллекта, Internet of Things и масштабов обрабатываемых данных. Это требует от инженеров постоянного совершенствования навыков системного мышления, тестирования на отказоустойчивость, грамотного применения теории управления и контроля, а также использования автоматизации и, возможно, в перспективе — доверия частично автономным AI-агентам для обеспечения стабильности. Вывод, который можно сделать из развернутого разбирательства Redpanda Cloud и GCP, прост и важен одновременно: продуманная архитектура с принципом локализации сервисов, строгие SLA, постоянное тестирование и наблюдение в реальном времени — это единственный способ рассчитывать на высокую надежность при работе с современными облачными технологиями. Благодаря таким решениям Redpanda Cloud смогла не только сохранить работу своих сервисов в момент глобального сбоя, но и обеспечить клиентам минимальные неудобства, превращая кризис в очередное доказательство устойчивости и профессионализма своей команды.

Для всех, кто заинтересован в изучении надежных облачных решений и современных подходов к построению систем потоковой передачи данных, Redpanda Cloud открывает бесплатный доступ и активное сообщество поддержки. В мире, где сложность систем продолжает расти, только объединенная экспертиза и глубокое понимание фундаментальных принципов поможет создавать устойчивые и эффективные цифровые сервисы.

![US Federal Land Ownership: Overview and Data (2020) [pdf]](/images/6338BAA4-8B41-4247-A0F2-78CAEA63959A)

![The Mathematics of Juggling [video]](/images/6D60B5D9-1125-4979-84BA-318355A852B7)