В современном программировании и высокопроизводительных вычислениях огромное значение имеет оптимизация доступа к данным в памяти. Одной из наиболее фундаментальных операций в области обработки числовых массивов является скалярное произведение (dot product) — умножение соответствующих элементов двух векторов с последующим суммированием результатов. Производительность этой операции существенно влияет на множество приложений — от машинного обучения и компьютерной графики до научных расчетов и обработки сигналов. Вопрос, который часто возникает среди разработчиков и инженеров, касается влияния выравнивания данных (alignment) в памяти на эффективность выполнения операции. Стоит ли беспокоиться о выравнивании данных при реализации скалярного произведения с использованием современных процессоров? Каковы реальные последствия выполнения операции над некорректно выровненными данными? В данной статье подробно разбирается именно этот вопрос, основываясь на последних исследованиях и экспериментальных результатах, включая работу Дэниела Лемира, признанного эксперта в области оптимизации программного обеспечения и производительности вычислений.

Понятие выравнивания данных относится к тому, как именно расположены байты данных в оперативной памяти относительно адресов, кратных размеру элементов. Многие современные архитектуры процессоров лучше и быстрее обращаются к данным, если те хранятся по адресам, кратным определенному базовому размеру. Например, для 32-битных чисел (4 байта) предпочтительно, чтобы адрес элемента был кратен 4. Такое строгое соответствие оптимизирует операции чтения-записи, позволяет загружать данные за один цикл и избегать дополнительных затрат на обработку. Если данные не выровнены, то есть расположены по адресу, который не кратен размеру элемента, возникает так называемая unaligned load — загрузка с выравниванием, не соответствующим требованиям архитектуры.

В ряде случаев такое обращение к памяти может замедлять процессор, приводить к двум обращениям к памяти вместо одного, а в некоторых специфических архитектурах даже вызывать сбои или неопределённое поведение программы. Однако современные процессоры Intel, AMD, ARM, Apple имеют развитые механизмы, позволяющие выполнять unaligned загрузки практически без потерь в производительности, особенно если такие обращения не пересекают границы кэш-линий. Кэш-линия представляет собой блок памяти фиксированного размера (обычно 64 байта) — минимальная единица данных, загружаемая из оперативной памяти в процессорный кэш за раз. При обращении к данным, расположенным на границе двух кэш-линий, возможно, что для получения необходимого объема будет произведена загрузка сразу из двух кэш-линий, что может вызвать незначительное замедление из-за необходимости обращения к дополнительной области кэша. Тем не менее, эффект зачастую минимален и не влияет серьёзно на общую производительность, особенно при оптимизированных циклах и массивах данных большого объема.

Практические ситуации, когда данные оказываются невыравненными, не являются редкостью. Например, при работе с бинарными файлами, загружаемыми напрямую в память без дополнительной переработки, либо при упаковке структур, где из экономии места смешиваются данные различных размеров — 1-байтовые и 4-байтовые элементы. В таком случае операционная система и процессор вынуждены работать с данными в формате, который не соответствует идеальным привязкам по адресам. Вопрос, насколько это влияет на производительность, становится крайне актуален для разработчиков, стремящихся к максимальной эффективности своих программ. Дэниел Лемир провёл обширные тестирования, чтобы проверить, действительно ли выравнивание данных существенно влияет на скорость вычисления скалярного произведения, особенно с применением SIMD-инструкций (Single Instruction, Multiple Data), которые широко используются для параллельной обработки векторных данных.

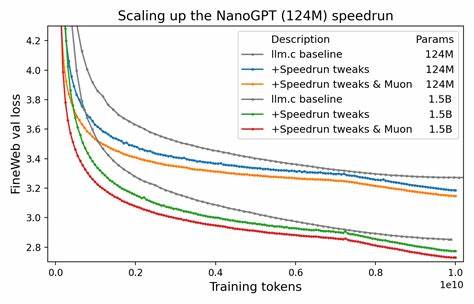

В экспериментах использовались наборы данных из 32-битных чисел с объёмом около одного мегабайта, что позволяет исключить влияние ограничений кэша L1 и минимизировать нагрузку на основной оперативный модуль памяти. Тестирование производилось на двух современных платформах — Apple M4 и Intel Ice Lake. Результаты оказались весьма показательными. На процессоре Apple M4 невыравненные данные вызывали лишь незначительное замедление порядка 10%, что практически не сказывается на общей производительности для большинства приложений. На процессоре Intel Ice Lake влияние выравнивания было ещё менее заметным и практически отсутствовало.

Использование ещё более широких регистров AVX-512 на Intel также не изменило картину — симметричные показатели демонстрировали минимальное влияние смещения данных в памяти. Главный урок, который можно извлечь из этих исследований — бояться невыравненных данных и тратить значительные усилия на их выравнивание ради повышения производительности скалярного произведения зачастую не стоит. Конечно, есть исключения — для специализированных задач, когда создаёте собственные копирования данных для обеспечения стандартных гарантий либо работаете с атомарными операциями в многопоточной среде. Также некоторые особые аппаратные проблемы, например, 4K aliasing, описанные Intel, могут повлиять на производительность при операциях с массивами, расположенными на границах страниц памяти 4Кб. Кроме того, стоит упомянуть, что само по себе обращение к невыравненным данным — очевидно, технически сложнее, но благодаря особенностям современной архитектуры и механизмам аппаратной поддержки, процессоры справляются практически без штрафа за производительность.

Оптимизации касаются, прежде всего, общего проектирования алгоритмов, уменьшения количества обращений к памяти, эффективного использования кэша и распараллеливания вычислений. В комментариях к статье Лемира сообщество экспертов подчеркивало, что в тестах стоит учитывать дополнительные факторы для более точных результатов. Например, использование нескольких аккумуляторов в цикле умножения и суммирования помогает загрузить процессор лучше и дает более реалистичные сценарии нагрузки. Размер массива, позволяющий нормально вписаться в уровни кэша L1 или L2, также влияет на интерпретацию результатов, поскольку выход за пределы кэша может значительно повысить задержки чтения данных. Наконец, вероятность появления особых значений в числах с плавающей точкой при смещении в байтах стоит контролировать при генерации тестовых данных, чтобы избежать влияния таких исключительных случаев, как субнормальные числа или NaN.

Для современного разработчика информации об архитектуре процессора и особенностях кэширования остается ключевой при оптимизации программного обеспечения. Тем не менее, понимание того, что выравнивание данных не является, как правило, узким местом и не требует чрезмерных усилий, помогает сосредоточиться на действительно важных аспектах ускорения кода. Результаты исследований подтверждают, что современные процессоры спроектированы так, чтобы эффективно работать даже с невыравненными данными, обеспечивая высокую пропускную способность и быструю обработку многомерных массивов с минимальными потерями. Это позволяет не включать выравнивание данных в число обязательных условий при написании высокопроизводительного кода для операций, подобных скалярному произведению. Таким образом, внимания к выравниванию данных заслуживают, но не стоит излишне беспокоиться, если задачи необходимо решать быстро и эффективно.

Лучший подход — более комплексная оптимизация, понимание архитектурных характеристик конкретного процессора и профилирование кода для выявления настоящих узких мест. В конечном счёте, время, потраченное на излишнюю оптимизацию выравнивания, может быть лучше использовано для других аспектов повышения производительности. Исходный код и результаты тестов Дэниела Лемира доступны в открытом доступе. Для специалистов, занимающихся углубленной оптимизацией, ознакомление с этими материалами представляет значительный интерес и даёт возможность экспериментировать с различными вариантами реализации и анализа поведения программ в условиях современных архитектур. В заключение, можно смело утверждать, что с точки зрения практической разработки при работе со скалярным произведением и SIMD-инструкциями, выравнивание данных не является критически важным фактором производительности.

Современные процессоры и их внутренние оптимизации успешно нивелируют возможные негативные последствия невыравненных обращений к памяти, позволяя разработчикам сосредоточиться на более значимых аспектах архитектуры и дизайна программного обеспечения.

![Why China Has Ships in the Desert [video]](/images/A4D32371-A698-4DEA-ABCB-A0366118F5BC)