В современном мире разработки программного обеспечения использование искусственного интеллекта становится все более распространенным и востребованным. Одной из таких инноваций является внедрение ИИ-агентов, которые берут на себя выполнение первых проверок кода в рамках pull request (PR), выявляя ошибки, антипаттерны, дублирование и другие проблемы еще до вмешательства человека. Однако несмотря на большие ожидания от подобных систем, путь их создания и оптимизации оказался далеко не простым, что подтверждается опытом команды cubic — компании, специализирующейся на AI-native GitHub решениях. Разбор их подхода и ощутимых результатов может стать полезным уроком для всех, кто планирует применение искусственного интеллекта в проверке качества кода и смежных областях. Начальные испытания такого ИИ-агента вскрыли важные недостатки, которые сегодня считаются типичными для систем первого поколения.

Главной проблемой оказалась чрезмерная шумность выводимых комментариев. Вместо помощи и упрощения работы код-ревьюеров, бот часто генерировал множество не сулящих пользы замечаний, много из которых были ложными срабатываниями, нудными придирками или проверками, уже покрытыми другими средствами статического анализа. Это не только создавало ощущение бесполезности, но и снижало доверие разработчиков, уводя их внимание от действительно значимых замечаний. Исправление данных проблем потребовало комплексного пересмотра всей архитектурной модели и принципов функционирования ИИ-агента. Важным этапом стало признание того, что первоначальный подход, основанный на одном универсальном ИИ-агенте, способном обрабатывать все задачи непосредственно на основе одного большого контекстного запроса, в реальности оказывается неэффективным.

Чрезмерно обширная и универсальная постановка задачи приводила к большому количеству ложных срабатываний и высокой неинформативности объяснений. Попытки отрегулировать параметры языка модели, эксперимент с температурой генерации и добавление подробностей в промпты практически не дали улучшений. Новым этапом стало введение требования к ИИ предварительно формализовать и публично озвучивать мотивацию своих выводов. Каждое найденное потенциальное нарушение сопровождалось предварительным пояснением причины — будь то указание на опасность обращения к null-значению, проблема с дублированием, устаревший паттерн или другая ошибка. Благодаря такому подходу стало легче понять, какие именно шаблоны приводят к ошибкам, и фокусировать развитие модели на их устранении.

Кроме того, структурирование логики рассуждений привело к уменьшению случайных и необоснованных комментариев, повышая общую точность работы. Одним из ключевых открытий стало осознание необходимости распрощаться с избыточным набором инструментов. Ранняя версия агента использовала широкий спектр вспомогательных сервисов — от Language Server Protocol (LSP) до статического анализа и запуска тестов. Тем не менее, анализ аналитики показал, что подавляющая часть ценной информации поступает из ограниченного числа основных инструментов, а добавление множества дополнительных усложнений лишь разводит вниманием и привносит больше ошибок. В результате была реализована упрощенная архитектура, концентрирующаяся на базовых средствах, что позволило ИИ уделять больше ресурсов выявлению настоящих проблем.

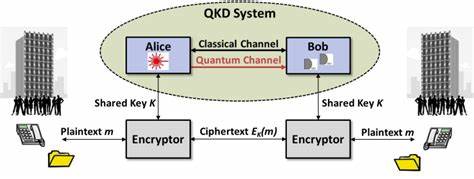

Решающим шагом стала идея создания специализированных микроагентов, каждый из которых ориентирован на выполнение строго определенной функции или набора задач. Такая специализация контрастировала с предыдущим методом бесконечного добавления правил к единому агенту, что быстро становилось неуправляемым и малоэффективным. Теперь были выделены узкопрофильные агенты — планировщик, оценивающий важность изменений и анализирующий нужные проверки; агент по безопасности, выявляющий уязвимости; агент дублирования, занимающийся поиском повторного кода; редакторский агент, фокусирующийся на исправлении опечаток и работе с документацией. Каждый такой агент работает в своем оптимальном контексте, что снижает когнитивную нагрузку, повышает точность и более эффективно расходует лимиты токенов модели. Этот подход хоть и увеличил потребление токенов из-за частичных пересечений контекстов разных микроагентов, но благодаря эффективным стратегиям кэширования удалось сохранить баланс между производительностью и качеством анализа.

Итогом комплексных изменений стало значительное снижение количества ложных срабатываний более чем вдвое, что для разработчиков означало повышение уровня доверия к автоматизированным отзывам и возможность по-настоящему полагаться на ИИ-агентов при проверке кода. Кроме количественных улучшений (сокращение средней нагрузки комментариев в два раза), разработчики из различных команд отмечали более плавный и естественный процесс ревью. Ушло время на борьбу с шумом, теперь фокус сместился на улучшение качества самой разработки — ускорение слияния изменений и сокращение времени, затрачиваемого на разрешение споров и фиксацию багов. Мотивация и удовлетворенность специалистов выросли параллельно с объективным улучшением результатов. Подводя итог, можно выделить несколько важных уроков из опыта создания эффективного ИИ-код-ревьюера.