Современные большие языковые модели (LLM) стали краеугольным камнем в развитии искусственного интеллекта и обработки естественного языка. Одним из ключевых направлений их развития является возможность работы с длинными контекстами, что позволяет моделям более глубоко и точно понимать и генерировать текст, учитывая широкий спектр информации. Однако расширение контекста сопровождается значительными вычислительными вызовами, связанными с алгоритмом внимания, распределением памяти и эффективностью обработки данных. Одним из ограничивающих факторов в работе с длительными контекстами является квадратичная вычислительная сложность механизма внимания в LLM. Это значит, что при увеличении длины контекста вычислительные затраты на обработку информации растут экспоненциально, что приводит к большим требованиям к аппаратным ресурсам и увеличению задержек.

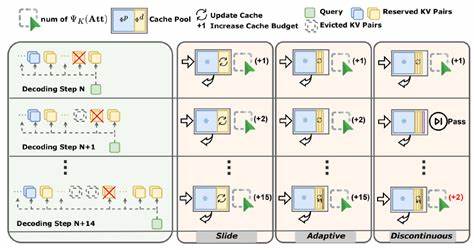

Кроме того, хранение ключей и значений (KV-кэша) для каждого элемента контекста требует значительных объемов памяти, что дополнительно усложняет работу с длинными последовательностями. Для решения этих проблем были предложены различные методы сжатия и оптимизации KV-кэша. Традиционные подходы обычно рассматривали ключи и значения как единое целое, применяя к ним универсальные сжатия или объединения. Однако недавно проведенное исследование выявило, что такая однородная работа с KV-кэшом имеет существенные ограничения, связанные с фундаментальной асимметрией в распределении ключей и значений. Было обнаружено, что ключи, расположенные рядом друг с другом в локальном участке KV-кэша, обладают высокой степенью сходства между собой — это явление можно назвать локальной гомогенностью.

Иными словами, соседние ключи, на которые модель обращает внимание, имеют практически одинаковые характеристики, что обуславливает возможность их слияния без существенной потери информации. В то же время значения, соответствующие этим ключам, демонстрируют значительную разнородность — соседние значения существенно отличаются по содержанию и распределению, то есть обладают гетерогенной структурой. Это ключевое наблюдение привело к разработке нового подхода к оптимизации KV-кэша — технологии, получившей название AsymKV. Она базируется на принципе, что ключи и значения должны обрабатываться по-разному, учитывая выявленную асимметрию. Ключи, благодаря своей схожести, могут быть эффективно сжаты и объединены без ущерба для точности модели, что снижает нагрузку на память и вычислительные ресурсы.

Значения при этом проходят через математически обоснованное безпотерянное сжатие, сохраняющее всю важную информацию. Особенностью AsymKV является то, что эта методика не требует дополнительного обучения моделей, что значительно ускоряет её внедрение и делает ее совместимой с широким спектром существующих LLM. Опираясь на эмпирические данные и теоретические обоснования, разработчики показали, что AsymKV превосходит современные методы оптимизации длинного контекста по ряду важных параметров. Эксперименты, проведенные с использованием модели LLaMA3.1-8B на тестовом наборе LongBench, подтвердили значимое превосходство AsymKV.

Средний балл 43.95, которого удалось добиться, значительно выше, чем у предыдущего лидера в области сжатия и управления контекстом — метода H2O, набравшего 38.89. Это свидетельствует как о более эффективной работе с памятью, так и о повышении качества понимания и генерации текста в условиях большого объема контекста. Важность такого прогресса трудно переоценить.

В ситуациях, когда необходимо учесть большое количество информации — например, при анализе юридических документов, технической литературы, медицинских текстов или многотомных научных трудов — способность LLM эффективно обрабатывать длинный контекст существенно расширяет границы применения искусственного интеллекта. Одним из ключевых преимуществ AsymKV является его универсальность и адаптивность. Метод не только повышает производительность моделей, но и снижает требуемые вычислительные ресурсы, что облегчает использование LLM на более доступных аппаратных платформах. Это способствует их большему распространению и внедрению в реальные задачи бизнеса и науки. Также стоит отметить, что выявленная асимметрия в KV-кэше — это не просто инженерная находка, а фундаментальная особенность распределения данных в языковых моделях.

Она открывает новые направления исследований и разработки более интеллектуальных и экономичных алгоритмов обработки естественного языка. Отдельное внимание уделяется простоте интеграции AsymKV в существующие архитектуры. Благодаря отсутствию необходимости в дообучении и совместимости с широким спектром моделей, разработчики и исследователи могут быстро испытать и применить этот подход, значительно ускоряя научно-технический прогресс в области искусственного интеллекта. Рассмотрение локальной гомогенности ключей и гетерогенности значений как основы для дифференциальной обработки KV-кэша меняет устоявшиеся парадигмы работы с памятью в больших языковых моделях. В результате достигается баланс между сохранением точности и уменьшением затрат ресурсов, что так необходимо для широкомасштабного применения LLM в реальных условиях.

В перспективе методы, основанные на изучении и использовании структурных особенностей данных, станут еще более актуальными по мере роста размеров моделей и масштабов обрабатываемой информации. Асимметрия KV-кэша открывает дверь к более глубокому пониманию внутренней работы нейросетей и созданию новых, более эффективных инструментов обработки и генерации текста. Таким образом, AsymKV и связанные с ним идеи представляют собой значительный шаг вперед в развитии больших языковых моделей, открывая путь к более эффективной, точной и масштабируемой работе с длинными контекстами. Это важный вклад в современные технологии искусственного интеллекта, который будет способствовать созданию новых приложений и возможностей в самых разных областях — от научных исследований до повседневных задач автоматизации и анализа текста.