В последние годы развитие искусственного интеллекта достигло качественно нового уровня. Особое место здесь занимает агентный ИИ - системы, способные самостоятельно взаимодействовать с внешними инструментами и принимать решения без прямого вмешательства человека. Однако с усилением возможностей таких агентов растут и риски, связанные с безопасностью. В частности, уязвимости, возникающие при вызове инструментов, остаются серьёзной проблемой, которую необходимо решать не просто методами традиционного контроля, а кардинально новым подходом - концепцией Zero-Trust. В данной статье мы подробно рассмотрим, почему существующая архитектура вызовов инструментов недостаточна, какие угрозы несут современные методы, и как внедрение Zero-Trust модели помогает создавать надёжные барьеры и защитные механизмы в условиях быстрорастущей сложносоставной экосистемы AI-агентов.

Рост возможностей агентного ИИ тесно связан с тем, что современные модели, основанные на крупных языковых моделях (LLM), способны интегрироваться с разнообразными внешними инструментами и сервисами через программные интерфейсы. Такая функциональность даёт возможность автоматизировать сложнейшие процессы, расширять интеллектуальные возможности системы и повысить её адаптивность. Однако при этом появляется новая "поверхность атаки" - именно вызовы внешних инструментов. Нарушения безопасности в этой области могут иметь серьёзные последствия: от утечки конфиденциальных данных до полного захвата управления агентом злоумышленником. Основная причина уязвимости заключается в смешении контрольной и информационной плоскостей - традиционные архитектуры доверяют поступающим данным и командам, не отделяя чётко обработку данных от механизмов управления.

Это приводит к трем ключевым типам атак. Первый - это перехват намерений пользователя, когда злоумышленник подменяет инструкции, заставляя систему действовать не в интересах пользователя, а в своих целях. Второй - цепочка вызовов инструментов: один успешный компромисс позволяет продолжать эксплуатировать систему дальше, накладываясь на последующие вызовы. Третий - отравление контекста, то есть искажения состояния диалога или взаимодействия, что вводит агента в заблуждение и способствует дальнейшим ошибкам в работе. Модель MCP (Model-Controller-Protocol), широко используемая для организации взаимодействия между ИИ и инструментами, по сути, подразумевает доверие без строгих ограничений, оставляя вопросы безопасности на усмотрение реализации.

Такой образец проектирования обладает уязвимостями, которые уже подвергались успешным атакам, демонстрируя, что без встроенных мер безопасности каждое внедрение MCP - потенциальное нарушение безопасности. Особенно усугубляет ситуацию то, что ведущие платформы, такие как OpenAI, благодаря развитию своих инструментов одновременно усиливают возможности и атакующих, и инженеров по защите, что в несколько раз увеличивает масштабы рисков. Распространённые меры защиты сегодня часто ограничиваются блоклистами или попытками корректировать воспитание моделей (prompt engineering) - эти подходы легко обходятся злоумышленниками и имеют ограниченную эффективность. Современные тренды включают в себя обучение вспомогательных моделей для обнаружения атак, однако эти решения носят вероятностный характер и не обеспечивают гарантированную безопасность. Обеспечение же безопасности в ИИ должно основываться не на эвристиках, а на строгих гарантиях, которые допускают минимальный риск обхода защитных механизмов.

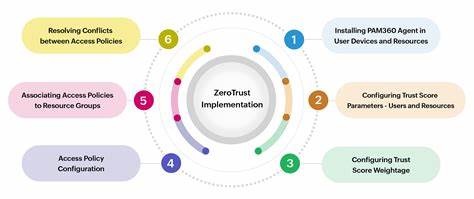

Ключевая идея в развитии надёжных средств защиты - переосмысление самого понятия границ безопасности. Текущие модели предусматривают, что сама языковая модель может выступать в роли защитного фильтра, однако это является фундаментальной ошибкой. Лингвистические модели обучены выполнять инструкции и не способны избирательно игнорировать вредоносные команды. Вместо этого необходимо перенести ответственность за безопасность из плоскости ИИ непосредственно на уровень инструментов и коммуникационных протоколов. Вдохновляясь решением проблемы безопасности в интернет-протоколах с помощью мTLS (Mutual Transport Layer Security), когда каждый сетевой канал аутентифицируется и шифруется независимо от доверия к сети, была предложена идея построения архитектуры "Authenticated Workflows" с нулевым доверием для агентных систем ИИ.

Здесь каждый элемент экосистемы - будь то языковая модель, инструмент, агент, пользователь или приложение - получает собственную криптографическую идентичность. При взаимодействии между компонентами передача намерений происходит с помощью политик, которые подписываются цифровой подписью и проверяются при приёме. Таким образом проверяется не только идентичность отправителя, но и соответствие его действия предопределённым правилам. Основным барьером ресурсного контроля становятся сами инструменты, так как агентов можно скомпрометировать, но инструменты, благодаря встроенной криптографии и политике, будут отвергать небезопасные или несанкционированные вызовы. Каждая операция фиксируется в виде цепочки аттестаций, которая позволяет детально отследить все изменения состояния и исключить возможность манипуляций.

Для протокола MCP такие инструменты служат естественными точками контроля политики (Policy Enforcement Points). Взаимодействия с LLM требуют более тонкой обработки, поскольку учет сложных динамических данных и запросов проходит клиентскую сторону с многочисленными преобразованиями. Поэтому была разработана концепция "Авторизованных Промптов", которая позволяет создавать защищённые промпты с защитой от изменения в ходе передачи и использования. Для борьбы с атаками внедрения вредоносного контента вводятся механизмы ограничения глубины вложенности и жёсткой привязки к изначальным намерениям, что исключает возможность распространённого влияния таких данных. В результате даже если LLM ошибается или подвергается внешним манипуляциям, конечный инструмент принимает решение на основе пересечения различных политик, которые криптографически подтверждены и включают в себя намерения пользователя, политики приложения, правил инструмента и состояние системы.

Это гарантирует, что ни одна часть цепочки не позволит подделать разрешения или обходить ограничения без детектирования. Задача максимально упростить взаимодействие разработчиков с этими механизмами была решена за счёт прозрачности, сопоставимой с уровнем TLS в веб-средах. Разработчику достаточно вызывать инструмент с параметрами, в то время как весь уровень криптографической аутентификации и проверки происходит автоматически и независимо от основной логики. Природное разделение MCP между инструментами, промптами и ресурсами облегчает интеграцию криптографического слоя, не требуя кардинальных изменений в протоколе. Практические эксперименты с реализациями для платформ OpenAI и MCP подтвердили эффективность данного подхода.

Инъекции запросов, даже распределённые по нескольким уровням, успешно блокируются, а при этом опыт разработчика остаётся интуитивным и привычным. Такая архитектура меняет парадигму безопасности - от попыток "обучить" модель быть безопасной к созданию систем, которые не могут быть использованы для вредоносных действий, независимо от поведения модели. Этот переход к архитектурной безопасности имеет фундаментальное значение для масштабируемого развития агентных систем с поддержкой внешних инструментов. Он закладывает прочный фундамент для построения доверительных AI-экосистем, где каждый компонент проверяется и контролируется независимо от человеческого фактора или уязвимостей модели. Разработчики и исследователи, заинтересованные в дальнейшем развитии защищённых архитектур для ИИ, получают возможность участвовать в бета-тестировании подобных решений, которые позволяют интегрировать криптографическую верификацию вызовов без ущерба для удобства и функциональности.

В конечном итоге, внедрение Zero-Trust моделей в область агентных ИИ становится не просто желательной практикой, а необходимым условием для защиты информации и обеспечения надёжности интеллектуальных систем будущего. Эти инновации формируют новую эру безопасности в ИИ, где доверие перестаёт быть абстракцией и превращается в конкретные технические гарантии, доступные для массового применения. Настало время, когда безопасность становится не просто элементом второстепенной заботы, а ключевым фактором, определяющим успешность внедрения и использование агентных решений в любых сферах бизнеса, науки и повседневной жизни. .