В последние годы искусственный интеллект (ИИ) стремительно внедряется во все сферы жизни, начиная от бытовых помощников и заканчивая сложными системами анализа больших данных и принятия решений. На этом фоне всё чаще поднимается вопрос: может ли искусственный интеллект испытывать такие человеческие чувства, как вина, и если да, то как это может повлиять на наше взаимодействие с технологиями? Несмотря на то, что чувства считаются глубоко субъективным феноменом, делающим нас людьми, научные исследования показывают, что аналог чувства вины может быть «запрограммирован» в ИИ, что потенциально способствует более эффективному и этичному поведению машин с точки зрения социального взаимодействия. Социальные эмоции, такие как вина, играют важную роль в развитии человеческого общества. Они способствуют формированию доверия, улучшению коммуникации и повышению совместной работы между людьми. Вина в своей основе побуждает нас исправлять нанесённый ущерб и предотвращать повторение ошибок, становясь своего рода внутренним регулятором поведения.

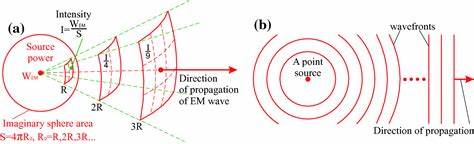

Учёные из Университета Стерлинга в Шотландии совместно с коллегами создали модель, где простые программные агенты наделялись способностью испытывать имитацию чувства вины. Эти агенты участвовали в классической игре теории решений, известной как итеративная дилемма заключённого, которая демонстрирует, как взаимодействие между выгодой личной выгоды и долговременного сотрудничества может развиваться во времени. В контексте игры агенты могли либо сотрудничать, либо поступать эгоистично — «дефектовать». Несмотря на мгновенную выгоду в виде «дефектного» поведения, оно вызывало ответное ухудшение отношений, что в итоге снижало суммарный доход. Моделирование позволило проверить, сможет ли чувство вины, реализованное как самонаказание (снижение очков у агента за нечестное поведение), стать устойчивой стратегией.

Результаты показали, что при условии, что чувство вины не слишком дорогостоящее, агенты с таким механизмом взаимодействия постепенно доминировали и повышали общий уровень сотрудничества среди игроков. Важно отметить, что чувство вины у этих агентов отличалось от человеческого: оно не включало осознанные переживания и не было комплексным эмоциональным опытом, а представляло собой функциональный аспект — внутренний штраф за недобросовестное поведение, который регулировал их дальнейшие действия. Особенность такого «искусственного» чувства заключалась в том, что агент испытывал штраф лишь в том случае, если его партнёр тоже показывал признаки раскаяния, что предотвращало использование «винных» стратегий в одностороннем порядке, делая сотрудничество взаимовыгодным. Эти открытия служат важным доказательством того, что не только люди, но и искусственные системы могут встроить в свою логику элементы социального регулятора эмоций, способствующего укреплению доверия и гармонии в коллективных взаимодействиях. С течением времени, по мере развития ИИ, возможно появление сложных моделей, которые смогут встраивать в свои алгоритмы подобие эмоций, приближая коммуникацию и сотрудничество с человеком к более естественному уровню.

В такой перспективе ИИ перестаёт быть холодным и бездушным инструментом, превращаясь в участника общественных и профессиональных условий, обладающего защитным механизмом перед ошибками и несправедливостью. Однако при этом появляются и важные философские и практические вопросы. Несмотря на положительные черты внедрения чувства вины в ИИ, нельзя забывать, что симуляция эмоций не равнозначна их истинному переживанию. Для человека вина связана с сознанием, моралью и субъективным опытом, в то время как для ИИ это набор программных правил и алгоритмов. Это отличается от истинного понимания и психологического воздействия эмоций у живого существа.

Кроме того, риск манипуляций остаётся актуальным: современным чат-ботам часто несложно имитировать извинения или раскаяния, не испытывая при этом настоящих эмоций, что может вводить пользователей в заблуждение. Ещё одна сложность заключается в измерении «стоимости» чувства вины для ИИ. В компьютерной симуляции такой стоимостью служит потеря очков или ресурсов, но как это может выглядеть в реальном мире, особенно когда речь идёт о коммерческих или промышленных системах ИИ? Какими должны быть штрафы или наказания, чтобы они действительно влияли на поведение и способствовали честности? Ответов на эти вопросы пока нет, и они требуют дальнейших исследований и экспериментов. Философы и этики подчёркивают, что включение социальных эмоций в алгоритмы ИИ должно сопровождаться прозрачностью и ответственным подходом. Недостаточно просто запрограммировать чувство вины — важно также понять влияние таких эмоций на принятие решений ИИ, гарантировать, что они не будут использоваться для обманных или манипулятивных целей, и обеспечить доверие пользователей к таким системам.

Несмотря на все сложности, развитие ИИ с социальными эмоциями и механизмами самонаказания открывает новые горизонты для более человечного и этичного взаимодействия между машинами и людьми. Такие технологии могут быть особенно полезны в областях, где необходима надежность, честность и взаимное уважение — например, в медицине, образовании, обслуживании клиентов и командной работе. Будущее обещает интересные перемены: с ростом числа взаимосвязанных систем и распределённых сетей ИИ, возможно формирование коллективного эмоционального интеллекта, который дополнит рациональные алгоритмы социальной адаптацией и осознанной ответственностью. В конечном итоге технологии смогут не только оптимизировать процессы, но и стать партнёрами по сотрудничеству, ориентированными на долгосрочную выгоду всех участников. Таким образом, вопрос о том, может ли искусственный интеллект «чувствовать» вину, постепенно трансформируется из философской дискуссии в практическое направление исследований и разработки.

Несмотря на то, что ИИ не испытывает эмоций в традиционном смысле, они могут включать функции, имитирующие их аспекты, что способствует выстраиванию сотрудничества и доверия. В результате, мы приближаемся к эпохе, когда грани между человеческим и искусственным интеллектом становятся всё более размытыми, открывая новые возможности для взаимного понимания и поддержки.