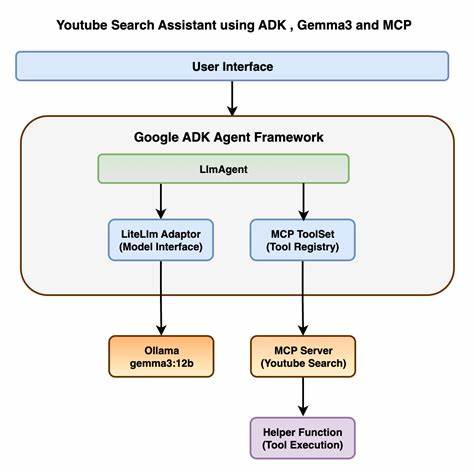

В последние годы искусственный интеллект стремительно развивается, становясь неотъемлемой частью различных сфер нашей жизни — от повседневных приложений на смартфонах до сложных промышленных систем и медицинских сервисов. Вместе с ростом возможностей AI растут и вызовы, связанные с его безопасностью, прозрачностью и этичностью использования. Компания Google, как один из мировых лидеров в области технологий, уделяет особое внимание разработке надежных и безопасных AI-агентов, которые могут эффективно взаимодействовать с людьми, сохраняя при этом высокий уровень контроля и предсказуемости. Основой философии Google в области безопасных AI-систем является стремление создать гибкую, но при этом надежную архитектуру, которая сочетает в себе лучшие традиционные методы безопасности и современные технологии динамического анализа и контроля. Их подход можно описать как стратегию многослойной защиты, в которой используются как строгие детерминированные механизмы, так и адаптивные системы, способные выявлять и блокировать потенциальные угрозы в реальном времени.

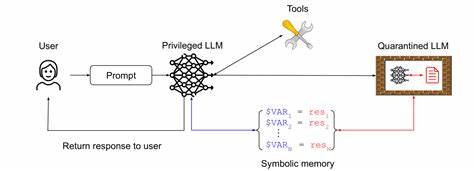

Ключевыми принципами, на которых строится этот подход, являются три важнейших положения. Во-первых, все AI-агенты должны находиться под четко определенным контролем со стороны человека. Это значит, что за каждым агентом стоит оператор или группа операторов, которые имеют возможность ограничивать его действия и принимать решения при возникновении спорных ситуаций. Такой подход исключает неконтролируемые ситуации, когда агент может самовольно выходить за установленные рамки, что особенно важно в сферах с высокими рисками. Во-вторых, Google подчеркивает необходимость строго ограничивать полномочия AI-агентов.

Это касается как доступа к данным, так и возможности выполнять определенные операции. Четкое разграничение полномочий позволяет минимизировать вероятность злоупотреблений или ошибок, предотвратить конфиденциальные утечки и обеспечить соответствие законодательным требованиям. Ограничения разрабатываются с учетом функциональных возможностей агента и области применения, что обеспечивает максимальную безопасность без потери эффективности. В-третьих, одним из краеугольных камней подхода Google является обеспечение прозрачности действий и процессов планирования AI-агентов. Всё, что делает агент, должно быть наблюдаемым и проверяемым внешними системами или операторами.

Это способствует быстрому выявлению аномалий, позволяет проводить аудит и повышает уровень доверия к таким системам как со стороны специалистов, так и конечных пользователей. Данная модель безопасности для AI-агентов отражает текущее видение Google и демонстрирует их приверженность развитию искусственного интеллекта, который не только обладает высокой производительностью и полезностью, но и отвечает самым строгим требованиям безопасности. В результате компания поддерживает открытый диалог с сообществом исследователей и разработчиков, регулярно публикует научные работы, инструменты и исходные коды, способствуя таким образом созданию общей безопасной экосистемы. Интеграция традиционных методов безопасности с новыми динамическими механизмами делает подход Google особенно интересным и перспективным. Традиционные методы включают в себя использование специализированных протоколов аутентификации и авторизации, управление доступом на основе ролей, шифрование и другие проверенные временем технологии.

Они обеспечивают стабильный фундамент и гарантируют базовые уровни защиты. В свою очередь динамические, основанные на методах логического анализа и машинного обучения технологии позволяют распознавать необычное поведение AI-агентов и своевременно реагировать на потенциальные угрозы. Такой двусторонний подход создает защиту, способную адаптироваться к новым вызовам и не позволять злоумышленникам эксплуатировать уязвимости, возникающие в постоянно меняющемся мире информационных технологий. Google также уделяет большое внимание обучению и поддержке научного сообщества, совершенствованию управленческих программ и проведению конференций. Эти инициативы направлены на обмен опытом и совместное решение проблем, связанных с безопасностью AI.

Продвинутая платформа для студентов и преподавателей помогает формировать новое поколение профессионалов, способных не только создавать инновационные решения, но и подходить к ним с позиции ответственности и этики. В перспективе такой комплексный и разумный подход позволит избежать многих проблем, связанных с неконтролируемым использованием искусственного интеллекта, включая возможные злоупотребления, ошибки, приводящие к катастрофическим последствиям, и утрату доверия со стороны общества. Безопасные AI-агенты, контролируемые людьми и обладающие ограниченными полномочиями, заложат основу для устойчивого развития множества отраслей — от здравоохранения и транспорта до финансов и экологии. В итоге стратегия Google направлена на создание баланса между мощью искусственного интеллекта и необходимостью его строгого контроля и мониторинга. Сочетание надежных традиционных методов с инновационными динамическими решениями позволяет не только повысить уровень безопасности, но и обеспечить прозрачность, масштабируемость и фактор доверия.

Это делает подход Google к безопасным AI-агентам одной из наиболее инновационных и продуманных моделей в мире современных технологий, которая открывает путь к свободному, но ответственному использованию искусственного интеллекта во всех областях жизни.