Искусственный интеллект (ИИ) все больше проникает в повседневную жизнь, становясь неотъемлемой частью технологий и процессов, которые обеспечивают функционирование нашей цифровой эпохи. Однако, несмотря на свои выдающиеся способности, ИИ не сможет заменить экспертов в области кибербезопасности. В этой статье мы рассмотрим, как важно сочетание автоматизации на основе ИИ и человеческого контроля для успешной защиты от киберугроз. Прошедшие несколько лет стали свидетелями стремительного роста и внедрения технологий Интернета вещей (IoT). По данным исследований, более 15 миллиардов устройств IoT уже подключены к сети, и эта цифра, по прогнозам, удвоится к 2030 году.

Это говорит о том, что мы живем в мире, где устройства, взаимодействующие друг с другом и с нами, становятся нормой. От умных домашних систем до автоматизированных производственных процессов — ИИ становится движущей силой, которая трансформирует наш опыт и создаёт новые возможности. С другой стороны, с развитием ИИ возникает множество новых вызовов. Системы ИИ становятся мишенью для злонамеренных акторов, что создаёт необходимость в надежной защите. Проблема в том, что автоматизированные системы безопасности, основанные на ИИ, могут генерировать много ложных тревог, что отвлекает внимание сотрудников и может привести к упущению реальных угроз.

Эта реальность подчеркивает важность работы квалифицированных специалистов в области кибербезопасности, так как ни один алгоритм не в состоянии должным образом оценить все нюансы ситуации. К тому же системы ИИ способны выдавать неожиданные результаты. Например, они могут случайно раскрывать конфиденциальную информацию или неправильно интерпретировать данные, что может иметь серьезные последствия. Это поднимает вопрос о необходимости наличия человеческого контроля над системами ИИ — ведь ни одна технология не может быть полностью надежной без участия человека. Важной особенностью новых технологий будет то, как они могут объединить усилия и находиться в одном контексте — это решение не должно принадлежать только ИИ.

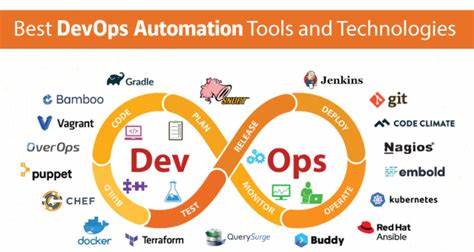

В будущем мы столкнемся с системами, которые объединяют в себе традиционные методы управления и новые методы автоматизации, при этом роль людей останется неотъемлемой. Более того, с развитием распределенных ИИ-систем, подобных муравьиным колониям, контроль над ними становится критически важным. Отвечая на эти вызовы, необходимо внедрять законодательство, способное регламентировать использование ИИ в критически важных сферах. Принятый в марте 2024 года в Европейском Союзе Закон о Искусственном Интеллекте является ярким примером — он запрещает высокорисковые приложения ИИ, такие как определенные биометрические системы и механизмы социального рейтинга. Компании теперь обязаны проводить оценку рисков и обеспечивать прозрачность работы своих систем.

Это законодательство было воспринято с разными реакциями. С одной стороны, некоторые представители бизнеса считают, что слишком строгие правила могут затормозить инновации и снизить конкурентоспособность. С другой стороны, защитники прав человека отмечают, что такие меры необходимы для предотвращения потенциальных злоупотреблений. Тем не менее, ясная регуляция становится необходимостью для балансировки инноваций и обеспечения безопасности. С увеличением зависимостей от технологий, производственные, образовательные и инфраструктурные системы нуждаются в более глубоком понимании влияния ИИ на общество.

Политики и законодатели должны осознавать как потенциальные выгоды, так и значительные риски, сопряженные с этими технологиями. Параллельно с развитием законодательства критически важно, чтобы компании инвестировали в обучение и поддержку своих сотрудников в области кибербезопасности. Автоматизация может упростить многие рутинные задачи, однако именно осведомленные специалисты способны стратегически подходить к управлению киберрисками. Наличие людей с высоким уровнем квалификации в области IT и кибербезопасности станет гарантом того, что технологии будут использованы во благо, а не во вред. Также стоит отметить, что внедрение ИИ требует пересмотра нашего отношения к безопасности и управления.

Поскольку системы становятся все более децентрализованными, встает вопрос: кто контролирует эти системы? В будущем, когда децентрализованные АИ будут управлять критическими функциями, необходимо будет обеспечивать баланс между инновациями и необходимостью доверия к этим системам. С моральной и этической точки зрения это также вызывает множество вопросов. Необходимость человеческого контроля над алгоритмами помогает избежать автоматизированных решений, которые могут быть дискриминационными или неэтичными. Вместо того чтобы полагаться исключительно на ИИ, мы должны принимать во внимание ценности и этические нормы, которые должны стать основой для создания и использования технологий. Современные реалии требуют от нас нового взгляда на кибербезопасность и роль технологий в нашем обществе.