В эпоху стремительного развития искусственного интеллекта и машинного обучения всё большую актуальность приобретают локальные модели ИИ, работающие непосредственно на устройствах пользователей. LocalLlama — одна из таких инициатив, направленная на создание и поддержку эффективных локальных языковых моделей, способных конкурировать с облачными аналогами. Этот проект получил значительное внимание в профессиональном сообществе и среди пользователей, благодаря своему уникальному подходу к обработке данных и обеспечению конфиденциальности. Современные технологии часто полагаются на центральные серверы для обработки информации и выполнения задач, связанных с ИИ. Такой подход, несмотря на высокую производительность, порождает риски утечки личной информации, а также зависимость от сторонних компаний и интернет-соединения.

LocalLlama предлагает альтернативу — эффективную работу моделей искусственного интеллекта прямо на устройстве пользователя. Это не только снижает риски безопасности, но и улучшает скорость отклика, поскольку данные не покидают локальную среду. Технология LocalLlama базируется на оптимизации языковых моделей, таких как LLaMA, разработанных Meta. Эти модели адаптированы для работы на персональных компьютерах, ноутбуках и даже мощных мобильных устройствах. Оптимизация затрагивает как архитектуру нейросети, так и использование ресурсов оборудования, что обеспечивает приемлемую производительность без необходимости в дорогом серверном оборудовании.

Сохранение и развитие LocalLlama стало возможным благодаря усилиям сообщества разработчиков с открытым исходным кодом и исследователей ИИ, которые стремятся сделать технологии доступнее и безопаснее. Благодаря открытости проекта, пользователи и специалисты имеют возможность модифицировать модель под свои задачи, оптимизировать её для специфических доменов или языков, а также напрямую контролировать работу алгоритмов на своих устройствах. Кроме технических аспектов, важным преимуществом LocalLlama является обеспечение конфиденциальности пользователей. В эпоху, когда обращение с личными данными вызывает всё больше вопросов, возможность обрабатывать информацию локально значительно снижает риски утечки. Это особенно актуально для организаций, работающих с конфиденциальной информацией, где любой доступ к внешним серверам может стать критичным.

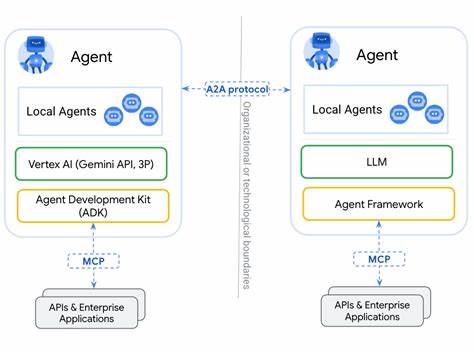

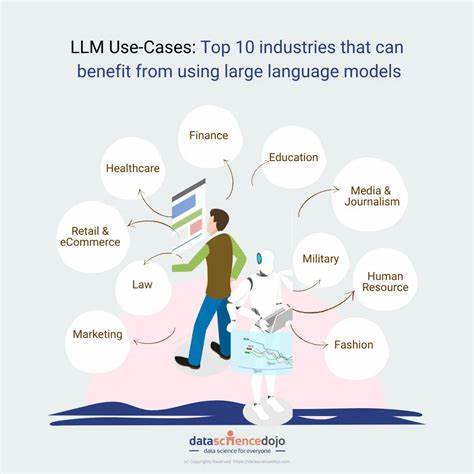

LocalLlama также имеет потенциал изменить подход к децентрализации ИИ. Вместо того чтобы сосредотачивать обработку данных и вычислительные процессы в облачных центрах, локальные модели создают сеть распределённых интеллектуальных систем, которые работают независимо. Такой подход снижает нагрузку на интернет-инфраструктуру и уменьшает риски централизованного контроля. Внедрение LocalLlama способствует развитию новых сценариев использования искусственного интеллекта. Малые и средние предприятия, а также индивидуальные пользователи могут самостоятельно использовать сложные языковые модели для автоматизации задач, таких как поддержка клиентов, создание контента, анализ данных и многое другое.

При этом они сохраняют полный контроль над своими данными и не зависят от сторонних провайдеров услуг. На фоне роста популярности концепций edge computing и privacy-first технологии, локальные модели вроде LocalLlama становятся вполне логичным и необходимым этапом развития ИИ. Они позволяют повысить уровень персонализации сервисов, улучшить их адаптивность и сократить задержки при обработке запросов. Сохраняя и развивая LocalLlama, разработчики делают большой вклад в демократизацию искусственного интеллекта. Открытость и доступность этих решений дают возможность большему числу людей и компаний использовать передовые технологии, развивать собственные инновационные сервисы и приложения без значительных инвестиций.

![AI is the new outsourcing [video]](/images/DAFFC29D-7526-4CB6-9C09-3AF8F32B0366)